李飞飞团队具身智能最新成果来了:

大模型接入机器人,把复杂指令转化成具体行动规划,无需额外数据和训练。

从此,人类可以很随意地用自然语言给机器人下达指令,如:

打开上面的抽屉,小心花瓶!

大语言模型+视觉语言模型就能从3D空间中分析出目标和需要绕过的障碍,帮助机器人做行动规划。

然后重点来了,真实世界中的机器人在未经“训练”的情况下,就能直接执行这个任务。

新方法实现了零样本的日常操作任务轨迹合成,也就是机器人从没见过的任务也能一次执行,连给他做个示范都不需要。

可操作的物体也是开放的,不用事先划定范围,开瓶子、按开关、拔充电线都能完成。

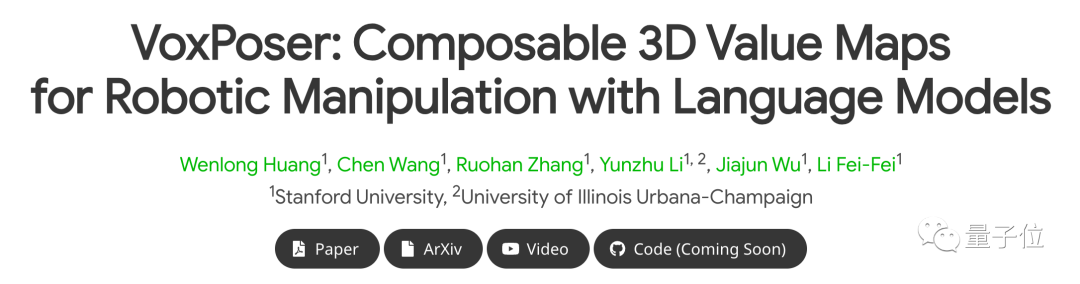

目前项目主页和论文都已上线,代码即将推出,并且已经引起学术界广泛兴趣。

论文地址:

https://voxposer.github.io/voxposer.pdf

项目主页:

https://voxposer.github.io/

一位前微软研究员评价到:这项研究走在了人工智能系统最重要和最复杂的前沿。

具体到机器人研究界也有同行表示:给运动规划领域开辟了新世界。

还有本来没看到AI危险性的人,因为这项AI结合机器人的研究而改变看法。

机器人如何直接听懂人话?

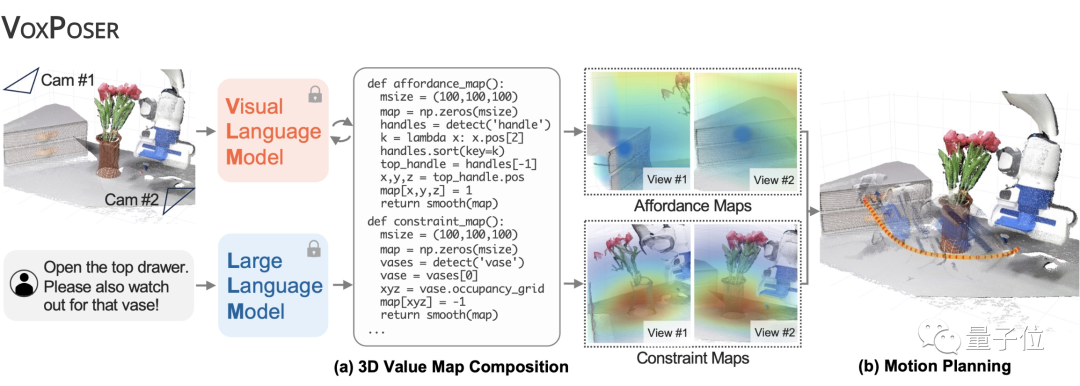

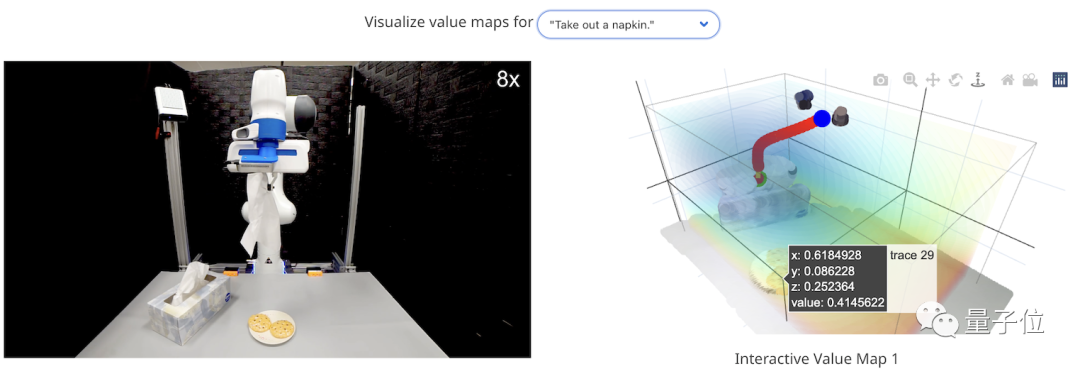

李飞飞团队将该系统命名为VoxPoser,如下图所示,它的原理非常简单。

首先,给定环境信息(用相机采集RGB-D图像)和我们要执行的自然语言指令。

接着,LLM(大语言模型)根据这些内容编写代码,所生成代码与VLM(视觉语言模型)进行交互,指导系统生成相应的操作指示地图,即3D Value Map。

所谓3D Value Map,它是Affordance Map和Constraint Map的总称,既标记了“在哪里行动”,也标记了“如何行动”。

如此一来,再搬出动作规划器,将生成的3D地图作为其目标函数,便能够合成最终要执行的操作轨迹了。

而从这个过程我们可以看到,相比传统方法需要进行额外的预训练,这个方法用大模型指导机器人如何与环境进行交互,所以直接解决了机器人训练数据稀缺的问题。

更进一步,正是由于这个特点,它也实现了零样本能力,只要掌握了以上基本流程,就能hold任何给定任务。

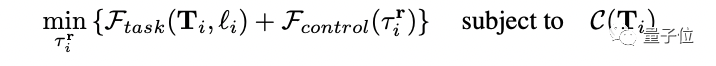

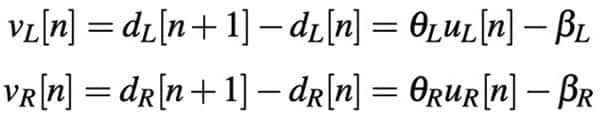

在具体实现中,作者将VoxPoser的思路转化为一个优化问题,即下面这样一个复杂的公式:

它考虑到了人类下达的指令可能范围很大,并且需要上下文理解,于是将指令拆解成很多子任务,比如开头第一个示例就由“抓住抽屉把手”和“拉开抽屉”组成。

VoxPoser要实现的就是优化每一个子任务,获得一系列机器人轨迹,最终最小化总的工作量和工作时间。

而在用LLM和VLM将语言指令映射为3D地图的过程中,系统考虑到语言可以传达丰富的语义空间,便利用“感兴趣的实体(entity of interest)”来引导机器人进行操作,也就是通过3DValue Map中标记的值来反应哪个物体是对它具有“吸引力”的,那些物体是具有“排斥性”。

还是以开头的例子举,抽屉就是“吸引”的,花瓶是“排斥”的。

当然,这些值如何生成,就靠大语言模型的理解能力了。

而在最后的轨迹合成过程中,由于语言模型的输出在整个任务中保持不变,所以我们可以通过缓存其输出,并使用闭环视觉反馈重新评估生成的代码,从而在遇到干扰时快速进行重新规划。

因此,VoxPoser有着很强的抗干扰能力。

?

?△ 将废纸放进蓝色托盘

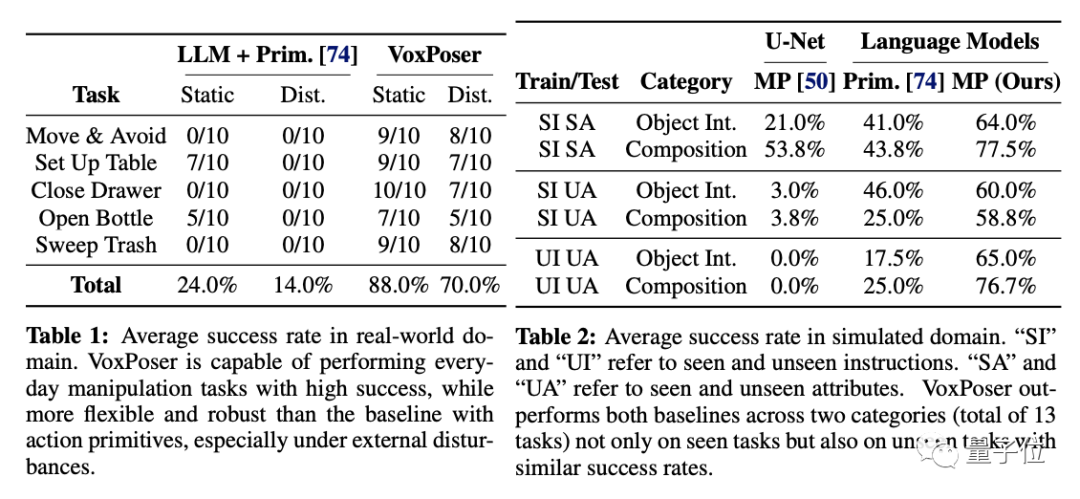

以下分别是VoxPoser在真实和模拟环境中的表现(衡量指标为平均成功率):

可以看到,无论是哪种环境哪种情况(有无干扰、指令是否可见),它都显著高于基于原语的基线任务。

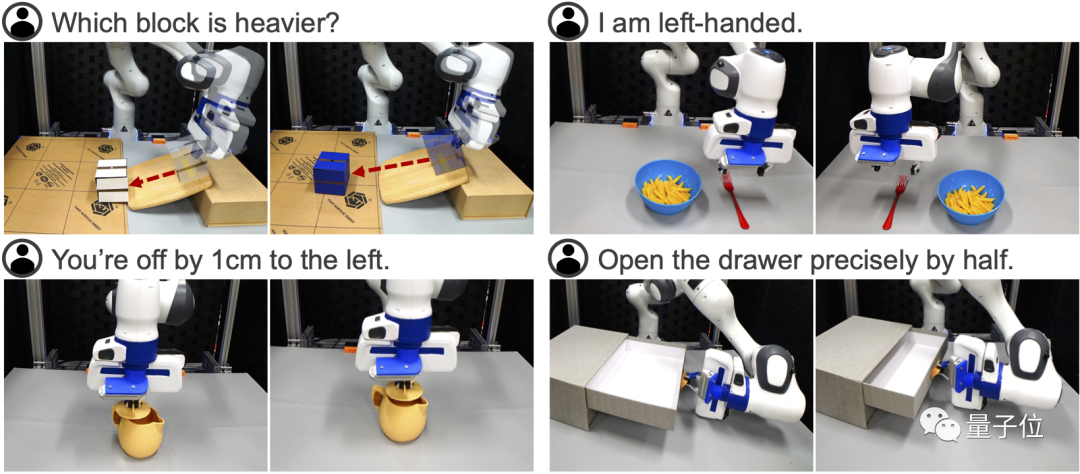

最后,作者还惊喜地发现,VoxPoser产生了4个“涌现能力”:

(1)评估物理特性,比如给定两个质量未知的方块,让机器人使用工具进行物理实验,确定哪个块更重;

(2)行为常识推理,比如在摆餐具的任务中,告诉机器人“我是左撇子”,它就能通过上下文理解其含义;

(3)细粒度校正,比如执行“给茶壶盖上盖子”这种精度要求较高的任务时,我们可以向机器人发出“你偏离了1厘米”等精确指令来校正它的操作;

(4)基于视觉的多步操作,比如叫机器人将抽屉精准地打开成一半,由于没有对象模型导致的信息不足可能让机器人无法执行这样的任务,但VoxPoser可以根据视觉反馈提出多步操作策略,即首先完全打开抽屉同时记录手柄位移,然后将其推回至中点就可以满足要求了。

李飞飞:计算机视觉的3颗北极星

大约一年前,李飞飞在美国文理学会会刊上撰文,指出计算机视觉发展的三个方向:

具身智能(Embodied AI)

视觉推理(Visual Reasoning)

场景理解(Scene Understanding)

李飞飞认为,具身智能不单指人形机器人,任何能在空间中移动的有形智能机器都是人工智能的一种形式。

正如ImageNet旨在表示广泛且多样化的现实世界图像一样,具身智能研究也需要解决复杂多样的人类任务,从叠衣服到探索新城市。

遵循指令执行这些任务需要视觉,但需要的不仅仅是视觉,也需要视觉推理理解场景中的三维关系。

最后机器还要做到理解场景中的人,包括人类意图和社会关系。比如看到一个人打开冰箱能判断出他饿了,或者看到一个小孩坐在大人腿上能判断出他们是亲子关系。

机器人结合大模型可能正是解决这些问题的一个途径。

除李飞飞外,参与本次研究的还有清华姚班校友吴佳俊,博士毕业于MIT,现为斯坦福大学助理教授。

论文一作Wenlong Huang现为斯坦福博士生,在谷歌实习期间参与了PaLM-E研究。

-

机器人

+关注

关注

213文章

29961浏览量

214551 -

语言模型

+关注

关注

0文章

565浏览量

10881 -

大模型

+关注

关注

2文章

3244浏览量

4237

原文标题:李飞飞团队「具身智能」新成果!机器人接入大模型直接听懂人话,日常操作轻松完成!

文章出处:【微信号:CVer,微信公众号:CVer】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

工业机器人的特点

RDK × 腿臂机器人:这只 “机械汪” 竟会说人话、走花路!

盘点#机器人开发平台

【「# ROS 2智能机器人开发实践」阅读体验】视觉实现的基础算法的应用

【「# ROS 2智能机器人开发实践」阅读体验】机器人入门的引路书

大象机器人携手进迭时空推出 RISC-V 全栈开源六轴机械臂产品

智能机器人加速进化:AI大模型与传感器的双重buff加成

普渡机器人接入DeepSeek满血版模型

【「具身智能机器人系统」阅读体验】2.具身智能机器人的基础模块

【「具身智能机器人系统」阅读体验】2.具身智能机器人大模型

【「具身智能机器人系统」阅读体验】1.初步理解具身智能

《具身智能机器人系统》第7-9章阅读心得之具身智能机器人与大模型

【「具身智能机器人系统」阅读体验】+初品的体验

构建语音控制机器人 - 线性模型和机器学习

机器人接入大模型直接听懂人话,日常操作轻松完成!

机器人接入大模型直接听懂人话,日常操作轻松完成!

评论