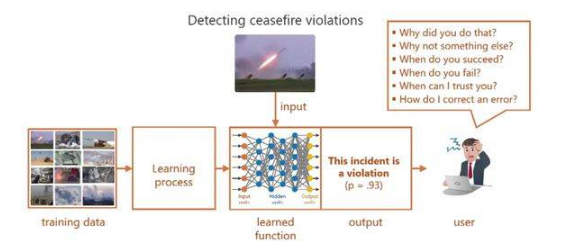

XAI 主要解决以下问题:对于使用者而言某些机器学习模型如同黑盒一般,给它一个输入,决策出一个结果。比如大部分深度学习的模型,没人能确切知道它决策的依据以及决策是否可靠。如图 1 的 output 所示,为一般网络给出的决策,缺乏可解释性的结果让使用者感到困惑,严重限制了其在现实任务中的广泛应用。

图 1 如今的深度学习 [1]

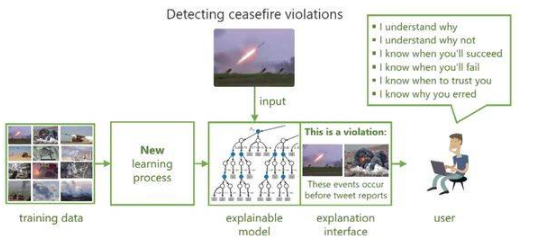

所以为了提高机器学习模型的可解释性和透明性,使用户和决策模型之间建立信任关系,近年来学术界进行了广泛和深入的研究并提出了可解释的机器学习模型。如图 2,模型在决策的同时给出相应的解释,以获得用户的信任和理解。

图 2 可解释的机器学习 [1]

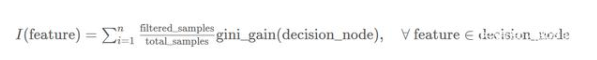

对于机器学习模型来说,我们常常会提到2个概念:模型准确性(accuracy)和模型复杂度(complexity)。模型的复杂度与准确性相关,又与模型的可解释性相对立。因此我们希望找到一种模型如图 3 所示,具有可解释性的同时尽可能保证模型的准确性和复杂度。

编辑:hfy

-

机器学习

+关注

关注

66文章

8513浏览量

135096 -

深度学习

+关注

关注

73文章

5569浏览量

123087

发布评论请先 登录

机器学习模型可解释性的结果分析

什么是“可解释的”? 可解释性AI不能解释什么

机器学习模型的“可解释性”的概念及其重要意义

Explainable AI旨在提高机器学习模型的可解释性

机器学习模型可解释性的介绍

人工智能可解释性规制面临的问题分析

小白学解释性AI:从机器学习到大模型

浅谈机器学习模型的可解释性和透明性

浅谈机器学习模型的可解释性和透明性

评论