Redis缓存穿透、雪崩、击穿三大难题的解决方案与实战

作为一名资深运维工程师,我在生产环境中处理过无数次Redis相关的故障。今天分享三个让无数运维人员半夜被叫醒的经典问题及其完整解决方案。

前言:那些让人崩溃的凌晨电话

凌晨3点,手机铃声急促响起:"系统挂了!用户无法登录!数据库CPU飙到100%!"这样的场景,相信每个运维工程师都不陌生。而在我7年的运维生涯中,80%的此类故障都与Redis缓存的三大经典问题有关:缓存穿透、缓存雪崩、缓存击穿。

一、缓存穿透:恶意攻击的噩梦

问题现象

用户疯狂查询数据库中不存在的数据,每次查询都绕过缓存直接打到数据库,导致数据库压力骤增。

真实案例回顾

某电商平台遭遇恶意攻击,攻击者使用随机生成的商品ID疯狂查询商品信息。由于这些ID在数据库中根本不存在,Redis缓存无法命中,每次请求都直接打到MySQL,导致数据库连接池瞬间耗尽。

监控数据触目惊心:

? 数据库QPS:从平时的500/s飙升到8000/s

? 缓存命中率:从95%跌至10%

? 系统响应时间:从50ms激增到5000ms

解决方案详解

方案一:布隆过滤器(推荐指数)

布隆过滤器是解决缓存穿透最优雅的方案,其核心思想是"宁可错杀,不可放过"。

实现步骤:

importredis importmmh3 frombitarrayimportbitarray classBloomFilter: def__init__(self, capacity=1000000, error_rate=0.001): """ 初始化布隆过滤器 capacity: 预计数据量 error_rate: 误判率 """ self.capacity = capacity self.error_rate = error_rate self.bit_num =self._get_bit_num() self.hash_num =self._get_hash_num() self.bit_array = bitarray(self.bit_num) self.bit_array.setall(0) self.redis_client = redis.Redis(host='localhost', port=6379, db=0) def_get_bit_num(self): """计算位数组大小""" returnint(-self.capacity * math.log(self.error_rate) / (math.log(2) **2)) def_get_hash_num(self): """计算哈希函数个数""" returnint(self.bit_num * math.log(2) /self.capacity) def_hash(self, value): """多重哈希函数""" h1 = mmh3.hash(value,0) h2 = mmh3.hash(value, h1) foriinrange(self.hash_num): yield(h1 + i * h2) %self.bit_num defadd(self, value): """添加元素""" forindexinself._hash(value): self.bit_array[index] =1 defis_exist(self, value): """判断元素是否存在""" forindexinself._hash(value): ifnotself.bit_array[index]: returnFalse returnTrue # 业务层面的使用 defget_product_info(product_id): # 先经过布隆过滤器检查 ifnotbloom_filter.is_exist(product_id): return{"error":"商品不存在"} # 查询缓存 cache_key =f"product:{product_id}" cached_data = redis_client.get(cache_key) ifcached_data: returnjson.loads(cached_data) # 查询数据库 product = database.query_product(product_id) ifproduct: # 缓存数据 redis_client.setex(cache_key,3600, json.dumps(product)) returnproduct else: # 缓存空值,防止重复查询 redis_client.setex(cache_key,300, json.dumps({})) return{"error":"商品不存在"}

运维部署建议:

? 布隆过滤器数据存储在Redis中,支持集群部署

? 定期重建布隆过滤器,避免误判率过高

? 监控布隆过滤器的容量使用情况

方案二:空值缓存

简单但有效的方案,将查询结果为空的Key也缓存起来。

defquery_with_null_cache(key):

# 1. 查询缓存

cached_data = redis_client.get(f"cache:{key}")

ifcached_dataisnotNone:

returnjson.loads(cached_data)ifcached_data !="null"elseNone

# 2. 查询数据库

data = database.query(key)

# 3. 缓存结果(包括空值)

ifdata:

redis_client.setex(f"cache:{key}",3600, json.dumps(data))

else:

# 缓存空值,但设置较短的过期时间

redis_client.setex(f"cache:{key}",300,"null")

returndata

注意事项:

? 空值缓存时间要比正常数据短

? 需要考虑存储成本

? 要有清理机制防止垃圾数据堆积

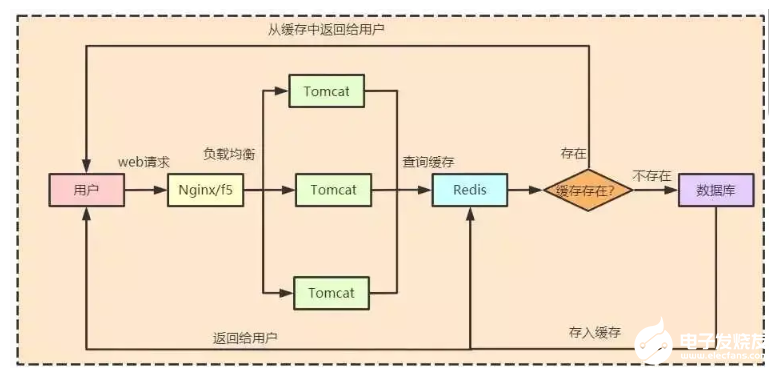

二、缓存雪崩:系统瘫痪的元凶

问题现象

大量缓存在同一时间失效,导致大量请求直接打到数据库,引发数据库压力过大甚至宕机。

血泪教训

某金融系统在促销活动期间,由于缓存批量过期,瞬间10万+用户的查询请求全部打到数据库,导致整个交易系统瘫痪45分钟,直接损失超过500万。

解决方案

方案一:随机过期时间

importrandom importtime defset_cache_with_random_expire(key, data, base_expire=3600): """ 设置带随机过期时间的缓存 base_expire: 基础过期时间(秒) """ # 在基础时间上增加随机波动(±20%) random_factor = random.uniform(0.8,1.2) expire_time =int(base_expire * random_factor) redis_client.setex(key, expire_time, json.dumps(data)) # 记录日志便于运维监控 logger.info(f"Cache set:{key}, expire:{expire_time}s") # 批量缓存预热时的应用 defbatch_warm_up_cache(data_list): """批量缓存预热,避免同时过期""" fordataindata_list: key =f"product:{data['id']}" # 每个缓存的过期时间都不同 set_cache_with_random_expire(key, data,3600) # 控制频率,避免Redis压力过大 time.sleep(0.01)

方案二:多级缓存架构

classMultiLevelCache:

def__init__(self):

self.l1_cache = {} # 本地缓存

self.l2_cache = redis.Redis() # Redis缓存

self.l3_cache = memcached.Client(['127.0.0.1:11211']) # Memcached缓存

defget(self, key):

# L1缓存命中

ifkeyinself.l1_cache:

self.metrics.incr('l1_hit')

returnself.l1_cache[key]

# L2缓存命中

l2_data =self.l2_cache.get(key)

ifl2_data:

self.metrics.incr('l2_hit')

# 回写L1缓存

self.l1_cache[key] = json.loads(l2_data)

returnself.l1_cache[key]

# L3缓存命中

l3_data =self.l3_cache.get(key)

ifl3_data:

self.metrics.incr('l3_hit')

# 回写上级缓存

self.l1_cache[key] = l3_data

self.l2_cache.setex(key,3600, json.dumps(l3_data))

returnl3_data

# 缓存未命中,查询数据库

self.metrics.incr('cache_miss')

returnNone

defset(self, key, value, expire=3600):

# 同时写入所有缓存层级

self.l1_cache[key] = value

self.l2_cache.setex(key, expire, json.dumps(value))

self.l3_cache.set(key, value, time=expire)

方案三:互斥锁重建缓存

importthreading fromcontextlibimportcontextmanager classCacheRebuildManager: def__init__(self): self.rebuilding_keys =set() self.lock = threading.Lock() @contextmanager defrebuild_lock(self, key): """互斥锁控制缓存重建""" withself.lock: ifkeyinself.rebuilding_keys: # 如果正在重建,等待一段时间 time.sleep(0.1) yieldFalse else: self.rebuilding_keys.add(key) try: yieldTrue finally: self.rebuilding_keys.discard(key) rebuild_manager = CacheRebuildManager() defget_data_with_rebuild_protection(key): # 查询缓存 cached_data = redis_client.get(key) ifcached_data: returnjson.loads(cached_data) # 缓存未命中,尝试获取重建锁 withrebuild_manager.rebuild_lock(key)asshould_rebuild: ifshould_rebuild: # 获得锁,进行数据重建 data = database.query(key) ifdata: # 设置随机过期时间防止雪崩 expire_time = random.randint(3600,4320) # 1-1.2小时 redis_client.setex(key, expire_time, json.dumps(data)) returndata else: # 等待重建完成后再次查询缓存 time.sleep(0.1) cached_data = redis_client.get(key) returnjson.loads(cached_data)ifcached_dataelseNone

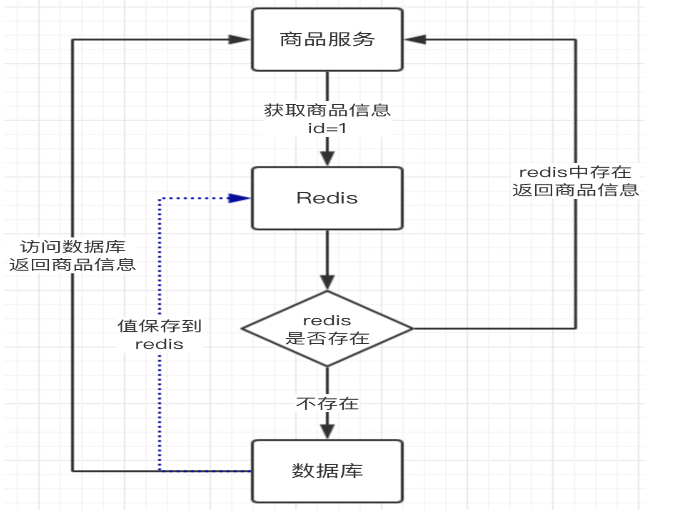

三、缓存击穿:热点数据的陷阱

问题描述

某个热点Key突然失效,导致大量请求同时查询数据库,造成瞬时压力。

经典案例

某视频平台的热门视频缓存过期,瞬间5000+并发请求打到数据库查询视频信息,导致数据库连接池耗尽,整个视频服务不可用。

解决方案

方案一:永不过期 + 逻辑过期

importjson importtime importthreading classLogicalExpireCache: def__init__(self): self.redis_client = redis.Redis() self.executor = ThreadPoolExecutor(max_workers=10) defset_with_logical_expire(self, key, data, expire_seconds): """设置带逻辑过期时间的缓存""" cache_data = { 'data': data, 'expire_time': time.time() + expire_seconds } # 永不过期,但包含逻辑过期时间 self.redis_client.set(key, json.dumps(cache_data)) defget_with_logical_expire(self, key): """获取带逻辑过期检查的缓存""" cached_json =self.redis_client.get(key) ifnotcached_json: returnNone cached_data = json.loads(cached_json) current_time = time.time() # 检查是否逻辑过期 ifcurrent_time < cached_data['expire_time']: ? ? ? ? ? ??# 未过期,直接返回 ? ? ? ? ? ??return?cached_data['data'] ? ? ? ??else: ? ? ? ? ? ??# 已过期,异步刷新缓存,先返回旧数据 ? ? ? ? ? ??self.executor.submit(self._refresh_cache_async, key) ? ? ? ? ? ??return?cached_data['data'] ? ?? ? ??def?_refresh_cache_async(self, key): ? ? ? ??"""异步刷新缓存""" ? ? ? ??try: ? ? ? ? ? ??# 获取分布式锁,避免并发刷新 ? ? ? ? ? ? lock_key =?f"lock:{key}" ? ? ? ? ? ??if?self.redis_client.set(lock_key,?"1", nx=True, ex=10): ? ? ? ? ? ? ? ??# 获得锁,开始刷新 ? ? ? ? ? ? ? ? new_data = database.query(key) ? ? ? ? ? ? ? ??if?new_data: ? ? ? ? ? ? ? ? ? ??self.set_with_logical_expire(key, new_data,?3600) ? ? ? ? ? ? ? ??self.redis_client.delete(lock_key) ? ? ? ??except?Exception?as?e: ? ? ? ? ? ? logger.error(f"异步刷新缓存失败:?{key}, 错误:?{e}") # 使用示例 cache_manager = LogicalExpireCache() def?get_hot_video_info(video_id): ? ? cache_key =?f"video:{video_id}" ? ?? ? ??# 尝试从缓存获取 ? ? video_info = cache_manager.get_with_logical_expire(cache_key) ? ?? ? ??if?video_info?is?None: ? ? ? ??# 缓存完全不存在,同步查询 ? ? ? ? video_info = database.query_video(video_id) ? ? ? ??if?video_info: ? ? ? ? ? ? cache_manager.set_with_logical_expire(cache_key, video_info,?3600) ? ?? ? ??return?video_info

方案二:分布式锁 + 双重检查

importuuid importtime classDistributedLock: def__init__(self, redis_client, key, timeout=10): self.redis_client = redis_client self.key =f"lock:{key}" self.timeout = timeout self.identifier =str(uuid.uuid4()) def__enter__(self): # 尝试获取锁 end_time = time.time() +self.timeout whiletime.time() < end_time: ? ? ? ? ? ??if?self.redis_client.set(self.key,?self.identifier, nx=True, ex=self.timeout): ? ? ? ? ? ? ? ??return?self ? ? ? ? ? ? time.sleep(0.001) ? ? ? ??raise?TimeoutError("获取分布式锁超时") ? ?? ? ??def?__exit__(self, exc_type, exc_val, exc_tb): ? ? ? ??# 释放锁(使用Lua脚本确保原子性) ? ? ? ? unlock_script =?""" ? ? ? ? if redis.call("get", KEYS[1]) == ARGV[1] then ? ? ? ? ? ? return redis.call("del", KEYS[1]) ? ? ? ? else ? ? ? ? ? ? return 0 ? ? ? ? end ? ? ? ? """ ? ? ? ??self.redis_client.eval(unlock_script,?1,?self.key,?self.identifier) def?get_data_with_distributed_lock(key): ? ??"""使用分布式锁防止缓存击穿""" ? ??# 第一次检查缓存 ? ? cached_data = redis_client.get(key) ? ??if?cached_data: ? ? ? ??return?json.loads(cached_data) ? ?? ? ??# 缓存未命中,尝试获取分布式锁 ? ??try: ? ? ? ??with?DistributedLock(redis_client, key, timeout=5): ? ? ? ? ? ??# 获得锁后,再次检查缓存(双重检查) ? ? ? ? ? ? cached_data = redis_client.get(key) ? ? ? ? ? ??if?cached_data: ? ? ? ? ? ? ? ??return?json.loads(cached_data) ? ? ? ? ? ?? ? ? ? ? ? ??# 查询数据库并缓存 ? ? ? ? ? ? data = database.query(key) ? ? ? ? ? ??if?data: ? ? ? ? ? ? ? ? redis_client.setex(key,?3600, json.dumps(data)) ? ? ? ? ? ??return?data ? ?? ? ??except?TimeoutError: ? ? ? ??# 获取锁超时,直接查询数据库(降级策略) ? ? ? ? logger.warning(f"获取锁超时,直接查数据库:?{key}") ? ? ? ??return?database.query(key)

四、生产环境最佳实践

监控告警体系

classCacheMonitor:

def__init__(self):

self.metrics = {}

defrecord_cache_hit_rate(self):

"""监控缓存命中率"""

hit_rate =self.redis_client.get('cache_hit_rate')

ifhit_rateandfloat(hit_rate) 0.85:

self.send_alert("Redis内存使用过高",f"使用率:{memory_usage:.2%}")

defcheck_slow_queries(self):

"""检查慢查询"""

slow_logs =self.redis_client.slowlog_get(10)

forloginslow_logs:

iflog['duration'] >10000: # 超过10ms

self.send_alert("发现慢查询",f"耗时:{log['duration']}μs, 命令:{log['command']}")

# 定时监控任务

defmonitoring_task():

monitor = CacheMonitor()

whileTrue:

try:

monitor.record_cache_hit_rate()

monitor.monitor_redis_memory()

monitor.check_slow_queries()

exceptExceptionase:

logger.error(f"监控任务异常:{e}")

time.sleep(60)

缓存预热策略

classCacheWarmUp:

def__init__(self):

self.redis_client = redis.Redis()

self.thread_pool = ThreadPoolExecutor(max_workers=20)

defwarm_up_hot_data(self):

"""预热热点数据"""

# 获取热点商品ID列表

hot_products = database.query("SELECT id FROM products WHERE is_hot = 1")

# 并发预热

futures = []

forproductinhot_products:

future =self.thread_pool.submit(self._warm_single_product, product['id'])

futures.append(future)

# 等待所有任务完成

success_count =0

forfutureinfutures:

try:

future.result(timeout=30)

success_count +=1

exceptExceptionase:

logger.error(f"预热失败:{e}")

logger.info(f"缓存预热完成,成功:{success_count}/{len(hot_products)}")

def_warm_single_product(self, product_id):

"""预热单个商品缓存"""

try:

product_info = database.query_product(product_id)

ifproduct_info:

cache_key =f"product:{product_id}"

expire_time = random.randint(3600,4320) # 随机过期时间

self.redis_client.setex(cache_key, expire_time, json.dumps(product_info))

exceptExceptionase:

logger.error(f"预热商品{product_id}失败:{e}")

raise

# 应用启动时执行缓存预热

if__name__ =="__main__":

warm_up = CacheWarmUp()

warm_up.warm_up_hot_data()

容灾备份方案

classCacheDisasterRecovery: def__init__(self): self.master_redis = redis.Redis(host='master-redis') self.slave_redis = redis.Redis(host='slave-redis') self.local_cache = {} defget_with_fallback(self, key): """多级降级查询""" try: # 1. 主Redis data =self.master_redis.get(key) ifdata: returnjson.loads(data) exceptExceptionase: logger.warning(f"主Redis故障:{e}") try: # 2. 从Redis data =self.slave_redis.get(key) ifdata: returnjson.loads(data) exceptExceptionase: logger.warning(f"从Redis故障:{e}") # 3. 本地缓存 ifkeyinself.local_cache: cache_item =self.local_cache[key] iftime.time() < cache_item['expire_time']: ? ? ? ? ? ? ? ? logger.info(f"命中本地缓存:?{key}") ? ? ? ? ? ? ? ??return?cache_item['data'] ? ? ? ?? ? ? ? ??# 4. 数据库查询 ? ? ? ??try: ? ? ? ? ? ? data = database.query(key) ? ? ? ? ? ??if?data: ? ? ? ? ? ? ? ??# 同步到本地缓存 ? ? ? ? ? ? ? ??self.local_cache[key] = { ? ? ? ? ? ? ? ? ? ??'data': data, ? ? ? ? ? ? ? ? ? ??'expire_time': time.time() +?300??# 5分钟本地缓存 ? ? ? ? ? ? ? ? } ? ? ? ? ? ??return?data ? ? ? ??except?Exception?as?e: ? ? ? ? ? ? logger.error(f"数据库查询失败:?{e}") ? ? ? ? ? ??return?None

五、性能优化与调优

Redis配置优化

# redis.conf 生产环境推荐配置 # 内存优化 maxmemory 8gb maxmemory-policy allkeys-lru # 持久化配置 save 900 1 save 300 10 save 60 10000 stop-writes-on-bgsave-erroryes rdbcompressionyes rdbchecksumyes # 网络优化 tcp-keepalive 300 timeout0 # 慢查询日志 slowlog-log-slower-than 10000 slowlog-max-len 128 # 客户端连接 maxclients 10000

连接池配置

importredis.connection # Redis连接池配置 redis_pool = redis.ConnectionPool( host='localhost', port=6379, db=0, max_connections=100, # 最大连接数 retry_on_timeout=True, # 超时重试 health_check_interval=30,# 健康检查间隔 socket_connect_timeout=5,# 连接超时 socket_timeout=5, # 读写超时 ) redis_client = redis.Redis(connection_pool=redis_pool)

六、故障排查实战手册

常见问题诊断

# 1. 查看Redis内存使用情况 redis-cli info memory # 2. 监控慢查询 redis-cli slowlog get 10 # 3. 查看客户端连接 redis-cli info clients # 4. 监控键空间命中率 redis-cli info stats | grep keyspace # 5. 查看过期键统计 redis-cli info keyspace

应急处理脚本

#!/usr/bin/env python3 """Redis应急处理工具""" importredis importsys importtime classRedisEmergencyKit: def__init__(self, host='localhost', port=6379): self.redis_client = redis.Redis(host=host, port=port) defflush_expired_keys(self): """清理过期键""" print("开始清理过期键...") count =0 forkeyinself.redis_client.scan_iter(): ifself.redis_client.ttl(key) ==0: self.redis_client.delete(key) count +=1 print(f"清理完成,共删除{count}个过期键") defanalyze_big_keys(self, limit=10): """分析大键""" print(f"分析占用内存最大的{limit}个键...") big_keys = [] forkeyinself.redis_client.scan_iter(): memory =self.redis_client.memory_usage(key) ifmemory: big_keys.append((key.decode(), memory)) big_keys.sort(key=lambdax: x[1], reverse=True) forkey, memoryinbig_keys[:limit]: print(f"{key}:{memory /1024:.2f}KB") defemergency_cache_clear(self, pattern): """紧急清理指定模式的缓存""" print(f"紧急清理模式{pattern}的缓存...") count =0 forkeyinself.redis_client.scan_iter(match=pattern): self.redis_client.delete(key) count +=1 print(f"清理完成,共删除{count}个键") if__name__ =="__main__": iflen(sys.argv) ") print("命令: flush_expired | analyze_big_keys | clear_pattern") sys.exit(1) kit = RedisEmergencyKit() command = sys.argv[1] ifcommand =="flush_expired": kit.flush_expired_keys() elifcommand =="analyze_big_keys": kit.analyze_big_keys() elifcommand =="clear_pattern"andlen(sys.argv) >2: kit.emergency_cache_clear(sys.argv[2]) else: print("未知命令")

总结

通过本文的深入分析,我们了解了Redis三大经典问题的本质和解决方案:

缓存穿透:使用布隆过滤器或空值缓存,构建第一道防线

缓存雪崩:通过随机过期时间、多级缓存、互斥锁等方式分散风险

缓存击穿:采用逻辑过期或分布式锁,保护热点数据

作为运维工程师,我们不仅要掌握这些解决方案,更要建立完善的监控体系、预热机制和应急预案。记住:好的运维不是没有故障,而是故障发生时能够快速响应和恢复。

在我的运维生涯中,这些方案帮我避免了无数次半夜的紧急电话。希望这篇文章能对各位同行有所帮助,让我们一起构建更稳定、更高效的系统!

-

cpu

+关注

关注

68文章

11121浏览量

218388 -

缓存

+关注

关注

1文章

247浏览量

27395 -

数据库

+关注

关注

7文章

3951浏览量

66850 -

Redis

+关注

关注

0文章

388浏览量

11572

原文标题:Redis缓存穿透、雪崩、击穿三大难题的解决方案与实战

文章出处:【微信号:magedu-Linux,微信公众号:马哥Linux运维】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

关于Redis缓存的原因及解决方案

Redis在高速缓存系统中的序列化算法研究

redis缓存mysql数据

缓存雪崩/穿透/击穿的解决方案

Redis缓存的异常原因及其处理办法分析

如何在SpringBoot中解决Redis的缓存穿透等问题

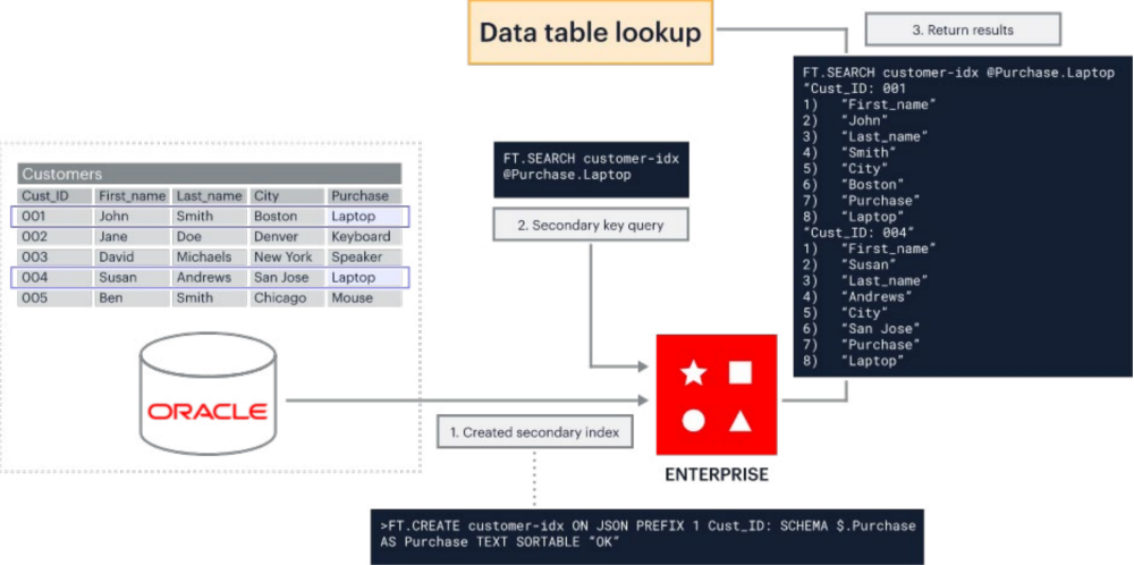

Oracle与Redis Enterprise协同,作为企业缓存解决方案

Redis Enterprise vs ElastiCache——如何选择缓存解决方案?

Redis缓存的经典问题和解决方案

Redis缓存的经典问题和解决方案

评论