案例简介

Votee AI 利用 NVIDIA 的 GPU 硬件、NeMo Curator 数据处理软件、NeMo Framework 模型训练框架及 Auto Configurator 优化工具,高效构建了精准的方言及小语种大语言模型 (LLM)。此举成功解决了数据稀缺、语言复杂及计算效率等挑战,为全球数以百万计、缺乏数字化资源的语言使用者提供了技术支持。

用技术打破小众语言数字化障碍

Votee AI 是一家致力于通过人工智能推动语言多样性发展与文化遗产保护的初创公司。全球有超过 6000 种语言,其中大量是缺乏数字化资源的方言和小语种(如粤语、伊班语、爪哇语等)。Votee AI 的使命是“让 AI 技术以用户的母语服务社区”,专注于为这些语言开发先进的 LLM。

Votee AI 提供定制化的 AI 语言解决方案,服务范围覆盖教育、媒体、金融、零售、公共服务和文化遗产保护等多个领域。公司自主研发的粤语 LLM,是一个开源、开放数据和开放模型的项目,旨在服务全球的粤语使用者。通过技术创新,Votee AI 希望打破小众语言面临的数字化障碍,不仅为这些语言社群提供更贴近本土需求的 AI 工具,更以科技力量守护全球的语言多样性。

小语种 LLM 构建的严峻挑战

为粤语等方言和小语种构建高性能的 LLM,面临着几大严峻挑战:

严重的数据稀缺性与质量问题:与英语或普通话等资源丰富的语言相比,粤语等方言和小语种的高质量、适用于计算处理的文本数据极其有限。现有的网络爬取数据往往充满噪声、格式不一致,甚至包含错误信息,且可能存在地域或主题偏差,影响模型训练的基础和泛化能力。

语言本身的复杂性:粤语等语言拥有丰富的俚语、口语化表达、网络用语以及独特的语法结构和声调系统(例如粤语的“水文化”习语)。传统 NLP 模型和分词器难以准确捕捉这些细微差别,容易导致理解错误、生成不自然甚至完全错误的“幻觉”内容。

巨大的计算需求:训练能够理解复杂语言细微差别的大规模 LLM 需要强大的计算能力。传统的 CPU 计算方案或资源不足的 GPU 环境会导致训练周期过长(数周甚至数月),使得模型迭代、实验和优化变得极其缓慢和昂贵,难以快速响应需求或改进模型。

评估困难:标准的 NLP 评估指标(如 BLEU、ROUGE)可能不足以全面衡量模型在方言和小语种上的真实表现,特别是在理解文化背景和口语地道性方面。需要结合语言特定指标和成本高昂的人工评估。

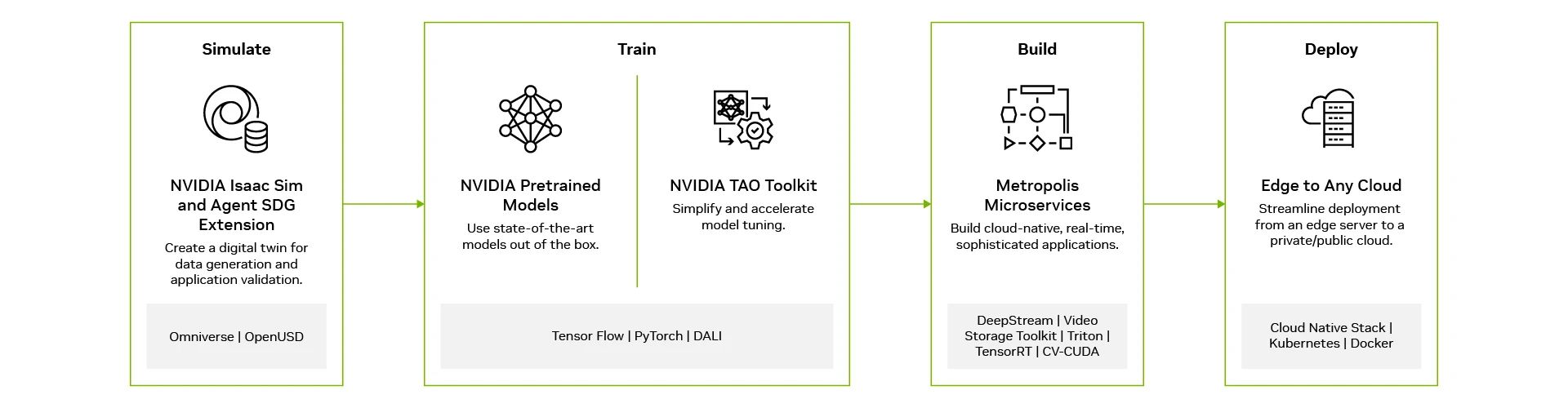

NVIDIA 技术加速方言小语种 LLM 开发

面对这些挑战,Votee AI 选择采用端到端的 NVIDIA 技术进行赋能,利用其硬件和软件堆栈来加速和优化方言和小语种语言 LLM 的开发流程:

硬件基础:Votee AI 借助 NVIDIA GPU 所具备的大规模并行计算能力,为数据处理与模型训练提供了核心支撑,成为应对计算密集型任务的底层技术基础。

数据准备与清洗:为了解决数据稀缺和质量问题,Votee AI 利用NVIDIA NeMo Curator进行高效的数据准备。NeMo Curator 是一个 GPU 加速的数据整理库,能够处理从数据下载、提取(支持 Common Crawl, Wikipedia 等)、清洗(语言识别、格式化、去噪、自定义规则处理粤语特定字符和表达)、过滤到去重(精确/模糊)的全流程。结合 NVIDIA RAPIDS cuDF 进行底层加速,数据清洗和分词等预处理任务速度提升了 20 倍,例如,处理 1TB 的粤语语料库,清理时间从数周缩短至仅需 2 小时,确保了输入模型的数据质量和处理效率。

模型训练:Votee AI 采用NVIDIA NeMo Framework,这是一个端到端的平台,用于开发和训练大规模语言模型。利用其 NeMo Megatron 组件,Votee AI 能够:

a. 高效分布式训练:在多 GPU 和多节点环境上高效扩展训练,支持张量并行 (TP)、流水线并行 (PP) 等多种并行策略。

b. 混合精度训练:使用 BF16 混合精度进行训练,显著减少内存占用并加速计算,使 Votee AI 的 120 亿参数粤语模型训练时间缩短了 40%(从预计 14 天减少到 8.4 天)。

c. 灵活架构与优化:支持多种 Transformer 架构,并允许针对方言和小语种进行调整(如模型大小、正则化策略、迁移学习)。

优化与评估:

a. 自动配置优化:使用NVIDIA Auto Configurator自动搜索和推荐影响训练吞吐量和效率的最佳超参数组合(如并行策略 TP/PP、微批量大小 MBS 等),简化了复杂的配置过程,帮助快速找到最优训练方案。

b. 超参数调优:利用NVIDIA cuML(RAPIDS 的一部分)进行加速的自动化超参数调优,以提升模型在下游任务上的性能。这使得模型的困惑度 (Perplexity) 降低了 15%,并在粤语特定评估任务中(如 BLEU 分数)提升了 22%,显著增强了模型对粤语俚语和口语化表达的理解能力。

通过整合这些 NVIDIA 技术,Votee AI 建立了一个高效、可扩展的工作流程,专用于应对方言和小语种语言 LLM 开发的独特挑战。

使用效果及影响

通过采用 NVIDIA AI 技术,Votee AI 在为方言和小语种(以粤语为起点)构建 LLM 方面取得了显著的成果:

大幅提升研发效率:借助 NVIDIA GPU和 NeMo 软件栈,Votee AI 的模型迭代周期缩短了 50%,从原来的平均 6 周减少到仅需 3 周。这使得团队能够更快地进行实验、优化模型并响应社区需求。

显著提高模型准确性与鲁棒性:通过 NeMo Curator 精心准备数据和 NeMo Framework 以及 Nemo Megatron 进行优化训练,结合 cuML 进行超参数调优,所构建的粤语 LLM 在理解复杂粤语(包括俚语和口语)方面的准确率从基线的 68% 提高到了 89%。这确保了模型在实际应用中能提供更自然、更精准的交互。

增强应用性能与用户体验:GPU 的高效计算能力不仅加速了训练,还将模型推理速度提高了 3 倍。这意味着基于该 LLM 的应用(如智慧客服、教育工具、媒体内容生成)能够实时响应用户查询,提供更流畅、更自然的交互体验。

推动语言包容性与文化传承:Votee AI 构建的高质量粤语 LLM 为全球粤语使用者提供先进 AI 工具,既弥合数字鸿沟,也助力粤语文化遗产保护与传承。

奠定可扩展的基础:Votee AI 使用 NVIDIA 技术构建的这套方法论和技术架构具有高度可扩展性,正在被应用于开发其他方言和小语种(如伊班语、爪哇语)的 LLM,推动 AI 技术在全球多语言环境中的公平普及和创新应用。

Votee AICTO陈豪杰表示:“借助NVIDIA GPU和NeMo Framework,我们成功克服了方言和小语种建模中数据稀缺性和语言复杂性的挑战。这使得我们能够高效、精准地开发AI应用,并使粤语及其他语言的大模型和AI场景能够真正在世界各地落地应用,赋能全球使用这些语言的社区。”

-

NVIDIA

+关注

关注

14文章

5358浏览量

106882 -

AI

+关注

关注

88文章

35869浏览量

282831 -

模型

+关注

关注

1文章

3549浏览量

50751 -

LLM

+关注

关注

1文章

330浏览量

941

原文标题:初创加速计划 | NVIDIA 助力 Votee AI 构建方言及小语种语言大模型

文章出处:【微信号:NVIDIA_China,微信公众号:NVIDIA英伟达】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

全球知名品牌借助NVIDIA技术规模化交付个性化广告

如何在魔搭社区使用TensorRT-LLM加速优化Qwen3系列模型推理部署

NVIDIA携手诺和诺德借助AI加速药物研发

欧洲借助NVIDIA Nemotron优化主权大语言模型

Wandercraft借助NVIDIA技术开发个人外骨骼设备

NVIDIA AI Foundry服务助力药物和医疗设备开发

在NVIDIA TensorRT-LLM中启用ReDrafter的一些变化

NVIDIA TensorRT-LLM Roadmap现已在GitHub上公开发布

NVIDIA加速AI在日本各行各业的应用

日本企业借助NVIDIA产品加速AI创新

借助NVIDIA Metropolis微服务构建视觉AI应用

借助NVIDIA NIM加速AI应用部署

Votee AI借助NVIDIA技术加速方言小语种LLM开发

Votee AI借助NVIDIA技术加速方言小语种LLM开发

评论