绿色算力

“AI的尽头是电力?”正当AI大模型的发展如火如荼之际,不少行业里的当红玩家们发出了这一灵魂叩问。

AI重塑万千产业,大模型狂飙突进,为各行各业注入新动能,但也带来了新挑战——对算力和能源(电力)的消耗呈爆发式增长,要如何满足?服务器功耗飙升到“冒烟”,芯片烫手,电费惊人,算力每前进一步,散热成本则高达三倍,这些实际的问题已经不容忽视。

AI这个“电老虎”更让不少科技巨头因此发出缺电警告。马斯克曾指出,人工智能的快速发展和自动驾驶汽车的开发进展可能导致电力短缺。Meta CEO扎克伯格也直接表达过,“对于建造AI数据中心而言,电力问题是影响下一步发展的瓶颈”。

亚马逊网络服务工程副总裁比尔·瓦斯曾透露,全球每3天就会增加一个新的数据中心。而全球数据中心的指数级增长究竟需要多少电力?

荷兰国家银行数据科学家亚历克斯·德弗里斯在一篇论文中估计,到2027年,AI的用电量可能占全球总用电量的0.5%。据他推算,如果谷歌将生成式AI技术整合到每次搜索中,每年将消耗约290亿千瓦时的电量,这相当于肯尼亚等三国年用电量总和。

这不免引发广泛的担忧——推动AI发展所需的数据中心对电力的巨大需求,这可能会给电网带来压力,并阻碍向清洁能源的过渡。另一个严峻的现实是,从算力、电力到热管理,AI模型的物理足迹正在激增。这种影响引发了人们有关能源和水资源消耗、电子废弃物(如电池和旧服务器),以及硬件制造对稀土元素等不可再生资源的依赖的担忧。

可持续人工智能可以实现吗?如何发展绿色算力并且进一步加速绿色能源结构的转变,已经成为下一步产业发展的关键。正如OpenAI CEO萨姆·奥尔特曼(Sam Altman)近日指出的,“未来十年,谁掌握智能和能源,谁就赢”。

“人工智能发展很快,但电网发展很慢。”

如何填补电力鸿沟?

与AI大模型的迅速发展同步发生的事情是,AI每天都在吞噬大量的算力和电能。

OpenAI的ChatGPT每天消耗超过50万千瓦时的电力,以响应2亿个用户的请求,而美国一个家庭平均每天的用电量约为29千瓦时。OpenAI预测,到2030年美国将需要约50吉瓦(GW)的新增电力产能,以支持AI行业的迅猛发展。

其实数据中心的能耗在AI大模型时代以前一直相当稳定,因为互联网使用水平的提高被能源效率的提高所抵消。但这种情况正在迅速改变——人工智能查询的能耗大约是现有搜索引擎的10倍。另据高盛报告,2022年算力数据中心在美国电力需求占的比例仅为3%,但是到2030年将增加到8%,电力需求年复合增长率为2.4%。相比之下,过去20年数据中心发电量年复合增率不到0.5%。该报告还预计,到2030年AI数据中心的电力需求将增长160%。

与人工智能发展的迅猛形成鲜明对比的是,电网的发展很慢。英飞凌在近期的一场AI创新技术论坛上就指出,AI算力的爆发式增长对电力基础设施提出了前所未有的挑战——AI数据中心的功耗每6个月翻一番(如NVIDIA GB200集群功耗可达120kW/机柜),而传统电网的升级周期长达10年以上。

“电力鸿沟”由此形成,并引发科技巨头们的缺电担忧。谷歌前 CEO埃里克·施密特(Eric Schmidt)更是在美国国会能源与商业委员会的听证会上警告“未来AI将消耗全球99%的电力”。在他看来,AI大模型未来发展面临的瓶颈不是算法本身,而是物理限制,比如电力资源。

因为从长远来看,按照目前AI每6个月翻一番的计算增长速度,是不可持续的。能源已经成为全球AI竞争的关键要素。

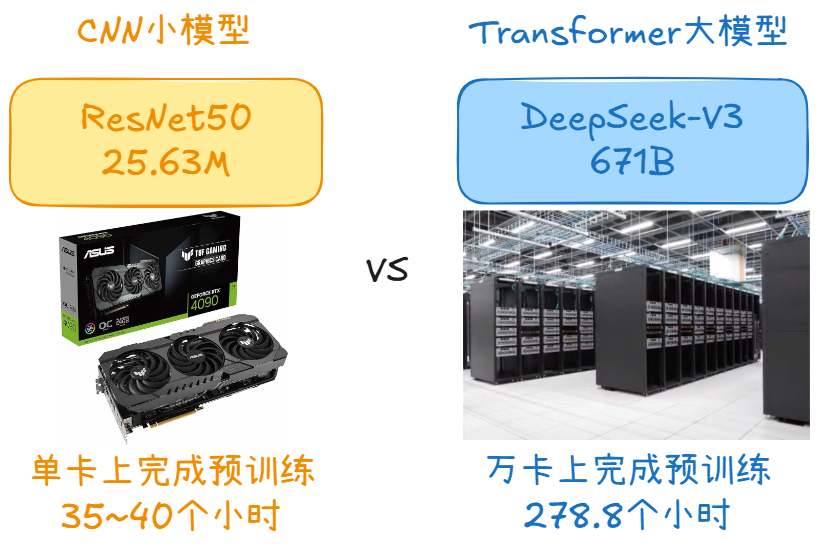

阿里研究院指出,目前全球计算范式正在发生新一轮重大变革,即从CPU主导的计算体系,向GPU主导的AI计算体系迁移,AI基础设施成为参与全球AI竞争、赢得AI战略主动的关键。从全球看,智算集群规模正从万卡级迈向百万卡级,因为超大规模集群是训练国际先进基础模型的必备设施。而建设超大规模智算集群,是一个复杂的系统性工程,不是万卡设备的简单堆砌和连接,而是需要芯片、服务器、网络设备、调度软件、模型等的紧密配合,以及对存储、GPU、基础算子底层代码、网络通讯原语等进行系统性优化。除了技术上的极高要求外,智算集群建设也面临物理条件的限制,其中主要的瓶颈就是能源。

AI数据中心里的电源革命

信通院《中国绿色算力发展研究报告》指出,未来AI算力集群功耗普遍超过20kW/柜,而机柜功率超过15kW后,目前数据中心主流风冷制冷技术也将面临瓶颈。因此,在此背景下就必须要求算力基础设施通过算法与框架优化、高能效硬件升级、可再生能源利用以及热回收系统、液冷技术等节能措施的实施,破除人工智能发展所带来的算力和能源瓶颈。

如何在高性能计算需求持续增长的同时,有效控制并降低能源消耗,成为AI数据中心建设与升级的关键命题。这也是近期半导体、电子科技大厂们发力的一大重点。

在一座AI数据中心里,从电源供应的角度来看,大致是这样一个过程:一排排独立的AI服务器机柜,要将输入进来的电压较高的电流逐步转换成电压非常低的电流,而后直接输送给GPU(图形处理器)和CPU(中央处理器)。在这个过程中会有三到四个步骤的电源转换,每一步的转换都伴随着电源的损耗。因而,极大限度地减少每一个步骤的电源损耗是提升数据中心供电效能的一大方向。

近期,安森美就针对AI算力激增带来的功耗问题,正式发布了《AI数据中心系统方案指南》(AI Data Center System Solution Guide),旨在系统性地助力工程师应对设计难题。该指南超越了单一产品介绍,构建了一个覆盖“从电网接入到核心芯片供电”(Grid-to-Chip)的全链路一站式供应体系。内容详尽解析了包括SiC及硅基功率器件、高性能栅极驱动器、数字/模拟控制器、多相稳压器、负载点(PoL)降压转换器以及关键保护电路等在内的完整电源方案链。指南不仅提供核心器件的规格参数和选型指导,更通过丰富的典型应用场景剖析和实际系统设计案例,深入阐述了如何优化系统架构、提升功率密度与转换效率,为客户提供从器件选型评估到系统集成的全方位工程支持。

电源技术的创新对于实现可持续未来至关重要,其中持续提升电源功率密度满足AI数据中心对电能需求的指数级增长的一大关键。

专注于智能电源与智能感知技术的安森美,近年来也一直在宽禁带半导体领域深耕布局。凭借先进的SiC功率器件(如MOSFET、二极管)、高集成度的智能功率级模块(IPM)等核心产品组合,公司成功开发出面向AI数据中心应用的高功率密度、高能效电源解决方案。这些方案能显著减少能源转换环节的损耗,提升整体电源系统效率。

去年,安森美推出了其新一代碳化硅技术平台EliteSiC M3e MOSFET,并计划将在2030年前推出多代新产品。EliteSiC M3e MOSFET可以更低的千瓦成本实现下一代电气系统的性能和可靠性。由于能够在更高的开关频率和电压下运行,该平台可有效降低电源转换损耗,可以有效促进数据中心向更高效、更高功率转变,以满足可持续人工智能引擎指数级增长的能源需求。此外,电动汽车动力系统、直流快速充电桩、太阳能逆变器和储能方案等广泛的汽车和工业应用也将由此受益。

除了芯片技术本身之外,英飞凌的相关技术人员指出,还需要考虑AI服务器外围的电感,以及如何缩短供电模块与作业模块(核心模块)的距离等问题也同样重要。可以说,从电源输入到电源的消耗,整个链路的长短,包括电路设计等每个环节都是非常关键的,都有可能帮助节约电能。

构筑绿色算力体系

亚洲样本有望引领全球

除了在电源技术上探索可持续智能之外,发展绿色算力一项成为更长期的系统工程,各国都在积极探索推动算力基础设施向绿色、低碳、可持续的方向转型。

中国信通院开放数据中心委员会联合国内多家IT、CT领域单位发布的《绿色算力技术白皮书(2023年)》中指出,绿色算力是一个综合性的概念,涉及算力的生产、供给、服务等全过程的绿色低碳。具体来说,绿色算力即算力的绿色低碳追求,可通过融合推进算力生产、算力运营、算力管理、算力应用等层次的绿色化来实现。作为一个系统性工程,绿色算力贯穿芯片、服务器、系统集、云服务、电力系统、储能等多个主体环节。

发展绿色算力,不仅是各国提升人工智能和算力基础设施国际竞争力的必然要求,也是加快能源结构转变和促进算能协同发展的必然要求。从算力全生命周期来看,算力的碳足迹主要来源于三个方面,算力以能源使用为主体的能源间接温室效应气体(Greenhouse Gas,GHG)排放,覆盖算力全生命周期资产投入及运营管理产生的间接碳排放,算力运行过程中拥有和控制的排放源产生的直接碳排放。而构筑绿色算力体系的三大支柱,包括降低数据中心能耗,可再生能源电力成为主要电力来源,以及智慧能源管理为数据中心绿色低碳发展提供有效助力三大方面。

其中“算力+能源”协同优化,是实现低碳转型的重要方面。通过引入AI算法优化数据中心的运营维护,智能系统能够实时监控数据中心的能源和资源使用情况,通过数据分析预测未来的使用趋势,并自动调整设备运行状态,以达到极佳的能源使用效率,可以大幅优化PUE(功率使用效率)、WUE(水使用效率)和CUE(碳使用效率)等指标。比如,微软Azure数据中心通过负载平衡技术,使得负载从10%增加到40%时,功耗只增加1.7倍,有效降低了能耗。

此外,还需要解决相应的法规治理及监管措的完善速度,跟不上AI算力基础设施的发展速度的问题。而这一点上,亚洲也完全可以引领并示范具有前瞻性的综合AI生态系统应有的面貌,为全球探索可持续智能提供可值得借鉴的亚洲样本。

放眼全球,亚太地区是全球数字经济发展非常活跃的地区之一,也是全球数据中心产业发展新高地,是推动技术创新与智能化升级的重要力量。根据此前华为数据中心能源相关部门在华为亚太合作伙伴大会期间公布的一组数据:亚太数据中心市场规模增长迅速,印尼、马来西亚、菲律宾等国2021—2026年的复合增长率均超过20%。

新加坡国立大学机械工程系主任、教授、能源研究所执行主任Lee Poh Seng与新加坡管理大学杨邦孝法学院法学教授、教职和科研事务副院长Heng Wang在近期发表的《绿色智能:为什么AI基础设施和治理必须协同发展》一文中指出,当今的数字化揭示了三个重要的错配现象:

其一是职能错配,即AI基础设施、环境可持续发展以及金融等领域之间存在“筒仓”效应;其二是空间错配,指地方、国家和国际治理之间缺乏充分的协调;其三是时间错配,即AI系统的快速部署周期与环境和社会复原力的长期需求之间存在冲突。

而应对这些错配现象需要全局视野,让基础设施的发展与治理协同进步。文章指出,这一点对于亚太地区来说尤为重要,因为该区域受到城市密度、气候脆弱性及数字化进程加速的交叉影响。

对此,新加坡的一些举措,包括制定绿色数据中心路线图,制定生成式人工智能治理框架模型,以及发布更广泛的《2030年新加坡绿色计划》,这些举措展现了基础设施与治理框架相协调以推动可持续数字生态系统发展的早期努力。可见,实现可持续AI需要政府、业界人士、学术机构和更广泛的群体共同行动,以确保数字基础设施的增长与环境和社会目标协调一致。

写在文末

英伟达创始人黄仁勋表示,AI数据中心实际上是“AI工厂”,未来的数据中心不再是存储与计算中心,而是生产Token(算力的单位)的工厂——输入能源、输出Token。

如果说,在上一轮互联网时代的技术周期里,比拼的是“算力+连接”,那么这一轮的AI周期,比拼的则是“算力+供电”。可持续绿色智能如何构建?需要绿色算力和绿色能源量大技术底座的深层协同。

-

AI

+关注

关注

88文章

35748浏览量

282379 -

能源

+关注

关注

3文章

2083浏览量

44918 -

大模型

+关注

关注

2文章

3230浏览量

4223

原文标题:从兆瓦到零碳:大模型时代的能源等式如何平衡?

文章出处:【微信号:贸泽电子,微信公众号:贸泽电子】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

新能源汽车电子水泵电机电磁场仿真分析

轮毂电机不平衡电磁力对车轮定位参数的影响

大模型时代的深度学习框架

大模型时代的能源等式如何平衡

大模型时代的能源等式如何平衡

评论