截至2025年,生成式AI大模型的能力仍在迅速提升。如果关注这个领域,会发现有不少创业者花大量精力打造的AI应用,但往往很快就被新一代大模型“原生功能”所取代。

这一类应用被归类是Prompt(提示词)包装层应用,这些应用通过设计提示词调用大模型基础能力,但没有构建更深层次业务价值。因为应用的价值主要靠大模型的原始能力,所以很容易被不断变强的大模型取代。

如何开发出不容易被大模型“抄家”的AI应用?

对此,英特尔技术专家认为,大模型应用开发不应仅仅沿着大模型本身能力的延展,直接基于大模型开发智能体,这样很容易随着大模型能力的提升而被淘汰。大模型应用开发要从大模型不擅长或无法克服的点进行切入,如解决数据地基的问题。

目前大模型最明显的两个问题都与数据有关。

首当其冲的就是幻觉。大模型本质上是在做概率运算,输出的内容越多,概率偏差就越大。此外,训练数据质量也会导致幻觉。而要在短期内彻底消除幻觉问题,则需要根本性的技术变革为前提。

第二,是大模型的知识无法实时更新。大模型预训练都有固定的时间,可能是几个月甚至是几年之前,完全不知道新发生的事情,无法及时更新自己的知识库。做出的回答也只能基于旧的已知内容。

针对这两大问题,业内达成的共识就是基于RAG(检索增强生成)构建知识库,它在预训练的大模型基础上连接外部的数据源,所有的任务和回答的内容上下文都从知识库中提取,然后,由大模型做出回答。

具体操作中,企业需要把内部的文档资料转化为机器能读懂的形式。先对文档进行切分,然后再进行向量化处理,最后存到向量数据库里。当用户提出问题时,问题也被转成向量,基于这些在向量数据库里进行检索,最后根据检索到的内容生成答复。

在生成答复的时候,召回率和准确率是非常关键的指标。召回率看的是,在所有“真正相关”的文档中,有多少被检索到了。而准确率Precision看的是,在所有被检索出来的文档中,有多少是“真正相关”的。

英特尔专家表示,当看到这些技术细节后,就应该意识到,大模型的效果受到太多因素或环节的影响。比如,负责把文本转换成向量的Embedding模型的选择,切分文档的大小,检索数据的处理等等都会影响最后生成的结果。

在英特尔专家看来,做大模型开发,直接从智能体开始或许不是最优选。数据基础上的微小差异,最终效果可能会差出很多。换言之,如果能处理好数据本身,而不只是单纯依靠大模型本身的表现,则会创造更多不可替代的价值。

快速上手,在云上构建企业级RAG开发环境

目前,国内外多家大型企业都基于大语言模型和RAG技术构建了企业知识库,而且很多一线员工都非常认可。鉴于RAG知识库对企业非常重要,火山引擎推出了支持RAG场景的云主机镜像。

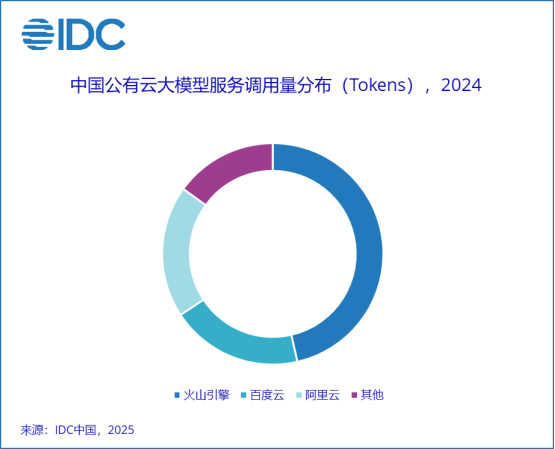

火山引擎在大模型服务领域表现非常亮眼。根据IDC发布的《中国公有云大模型服务市场格局分析,1Q25》报告,火山引擎在2024年中国公有云大模型调用量市场中占据了46.4%的份额,位居第一。

火山引擎不仅有火山方舟这种大模型服务平台,还有扣子(Coze)这类低代码AI应用开发平台,以及HiAgent这样的企业专属AI应用创新平台。新推出的RAG镜像则是让普通开发者以更低的门槛,开发出不容易被大模型“抄家”的AI应用。

RAG镜像中不仅包含Embedding(嵌入式)模块,还有向量数据库、Re-rank模型和7B的DeepSeek蒸馏模型,甚至还提供了数据预处理服务,以及处理在线问答服务的模块和前端页面,而且所有软件栈都经过了提前优化。

火山引擎的RAG镜像作为面向企业的服务,参考了OPEA的架构。OPEA是英特尔在去年发起的开源社区,利用开放架构和模块化组件的方式,帮助企业构建可扩展的AI应用部署基础。相比普通的开源架构,火山引擎的镜像具备更多企业级特性。

很多云厂商也提供了RAG服务,这些服务对普通用户来说门槛更低,但对于专业开发者而言,这些“黑盒”屏蔽了大量技术细节。而火山引擎的RAG镜像作为开源方案,让开发者能够看到更多底层细节,从多个技术维度进行优化,从而构建起真正的技术壁垒。

DeepSeek爆火之后,很多企业都计划进行本地部署,市场上出现了很多一体机解决方案,一台一体机里经常会有8张高性能显卡,这套方案的成本并不低,在没有明确业务需求之前,动辄几十万的成本投入或许并不明智。

现在,用户只需要在火山引擎上选择好虚拟机和镜像,就能在三分钟内搭建好一套开发环境,开始各种学习和实践。为了帮助开发者提升能力,英特尔还准备了一系列课程,帮助大家补齐相关知识,更轻松地迈出从0到1的第一步,打好数据基础。

大模型应用开发的三要素,硬件平台是基础

英特尔专家总结了大模型应用开发的三要素,除了刚才提到的软件栈和配套的指导课程,硬件环境同样至关重要。火山引擎基于英特尔至强处理器打造了多种云主机,最近推出的基于英特尔至强6性能核处理器的通用型实例 g4il,非常适合做大模型应用开发。

g4il是火山引擎的第四代通用型实例,其中 “g” 代表通用型,“4” 表示第四代,“i” 代表英特尔CPU平台。与第三代相比,其整体性能有显著提升,无论是在数据库应用、Web应用,还是图像渲染方面表现都更加出色,而在AI推理方面的优势更是尤为突出。

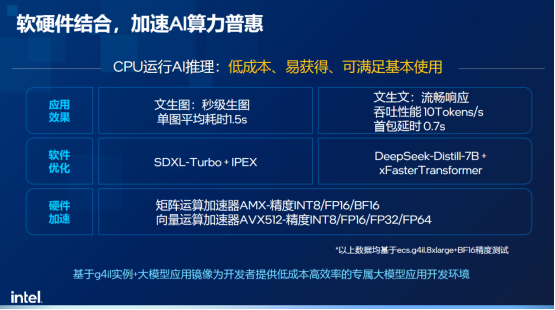

得益于集成AMX加速器,英特尔至强6处理器已成为目前最擅长AI推理的x86架构处理器之一。在火山引擎的g4il实例中,用户可以使用CPU完成AI推理。相比基于GPU的方案,它具备成本更低、资源更容易获得的优势,能满足基本需求。

基于CPU的AI推理方案特别适合用于AI应用的开发和验证阶段。搭配前面提到的火山引擎RAG镜像,用户可以在云上快速搭建起一套大模型应用的开发环境,大大降低了对硬件资源的门槛。

而到了生产环节,通常需要采用CPU+GPU的异构计算架构。比如,可以使用带有AMX的至强CPU来处理Embedding(文本嵌入)、Re-Rank、向量数据库等轻量级AI负载,让GPU专注于处理重型AI负载,从而提高资源利用率和整体处理能力。

g4il的一大亮点在于:用户只需选择一台配备16 vCPU或32 vCPU的云主机,即使不使用GPU,也能运行参数量为7或14B的DeepSeek蒸馏版模型。值得一提的是,该方案还支持DeepSeek推荐的高精度计算格式BF16,进一步提升推理质量。

小结

在技术快速演进的当下,借助云平台进行开发,既能降低试错成本,又能加快创新速度,为企业和开发者提供了更灵活的选择。更重要的是,通过精细化RAG等技术深耕数据底座,而不只是单纯靠巧妙的提示词,才能打造出不容易被大模型“抄家”的AI应用。

审核编辑 黄宇

-

英特尔

+关注

关注

61文章

10212浏览量

175463 -

AI

+关注

关注

88文章

35758浏览量

282451 -

大模型

+关注

关注

2文章

3231浏览量

4225

发布评论请先 登录

使用 llm-agent-rag-llamaindex 笔记本时收到的 NPU 错误怎么解决?

【「零基础开发AI Agent」阅读体验】+ 入门篇学习

DevEco Studio AI辅助开发工具两大升级功能 鸿蒙应用开发效率再提升

《AI Agent 应用与项目实战》阅读心得3——RAG架构与部署本地知识库

利用OpenVINO和LlamaIndex工具构建多模态RAG应用

【「基于大模型的RAG应用开发与优化」阅读体验】RAG基本概念

【「基于大模型的RAG应用开发与优化」阅读体验】+第一章初体验

【「基于大模型的RAG应用开发与优化」阅读体验】+Embedding技术解读

旋转测径仪的底座如何保证稳定性?

检索增强型生成(RAG)系统详解

RAG的概念及工作原理

Cloudera推出RAG Studio,助力企业快速部署聊天机器人

名单公布!【书籍评测活动NO.52】基于大模型的RAG应用开发与优化

使用OpenVINO和LlamaIndex构建Agentic-RAG系统

AI应用如何不被淘汰?深耕RAG与数据底座是关键

AI应用如何不被淘汰?深耕RAG与数据底座是关键

评论