电子发烧友网报道(文/周凯扬)随着LLM与生成式AI热度不减,不少AI芯片初创公司都找到了新的发力点,纷纷调整设计思路,专为这一爆款应用开发出了新款芯片。且不说这些芯片的实际性能如何,但这无疑是当下推动这些公司获得投资,并在行业下行期存活下去的救命稻草。今天我们就来聊聊刚发布新品SN40L的AI芯片初创公司SambaNova。

SN40L背后的SambaNova

SambaNova成立于2017年,截至目前已经历了共计6轮融资,参与融资的公司包括谷歌、英特尔和软银等,融资总额高达11亿美元。只不过最近的D轮融资,距今已经有两年多的时间,也难怪SambaNova急于推出SN40L这一芯片,毕竟此类初创公司的开发从来都是烧钱的。

其实在SN40L推出以前,SambaNova也并非默默无闻,比如美国阿贡国家实验室早在第一代产品SN10推出时就在使用和测试SambaNova的系统了,只不过届时基于SN10的SambaNova Dataflow系统还只是用于消除数据噪声而已。

如果我们现在看阿贡国家实验室的ALCF AI测试平台,我们可以看到5大系统,分别是Cerebras的CS2、SambaNova的Dataflow、Graphcore的Bow Pod64、Grop系统以及Habana的Gaudi。而目前用于ALCF AI测试平台的SambaNova Dataflow就是基于SN40L的上一代产品SN30 RDU打造的,该芯片基于台积电的7nm工艺打造。

目前SN30用在阿贡国家实验室的这套系统主要用于一些科学研究领域的AI计算,比如中微子物理、癌症预测、气候建模以及下一代汽车引擎研发等。而我们真正关注的是刚发布的SN40L,以及它在LLM这一应用上能提供何种不同的优势。

英伟达GPU的替代方案

目前LLM的主流方案,即英伟达的A100、H100 GPU,存在一个很大的问题,那就是缺货。对于任何互联网厂商来说,在市面上找到足够多的GPU都是一件费钱费力的事。而对于云服务厂商来说也是如此,他们也要考虑出租这类服务器时,GPU的算力与容量分配问题。

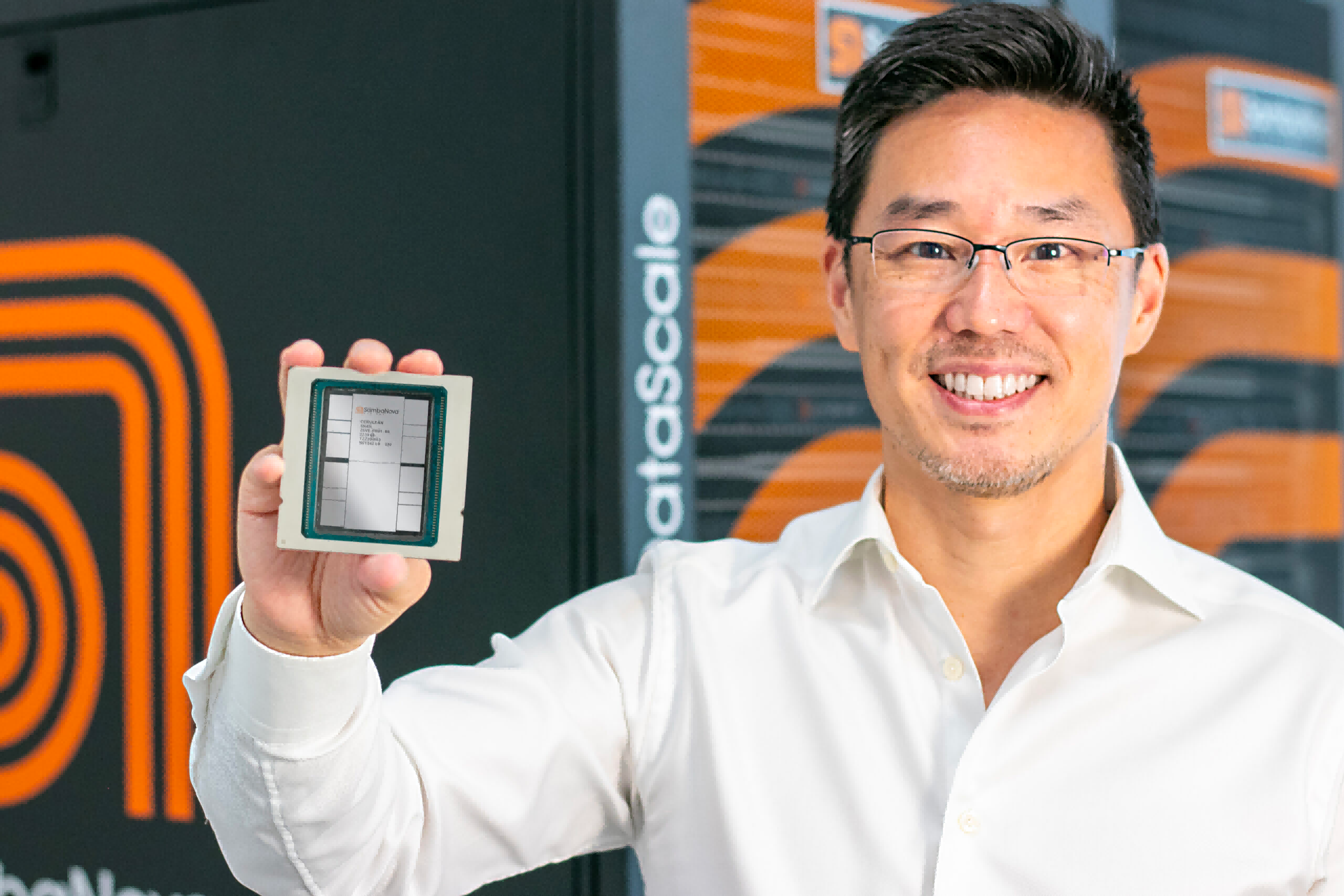

SN40L芯片和CEO Rodrigo Liang / SambaNova

为了解决“数量”的问题,SambaNova推出了SN40L。相较上一代的SN30,该芯片基于台积电5nm工艺打造,每个芯片集成了1020亿个晶体管和1040个核,算力高达638TFlops。更夸张的是,SambaNova称单个SN40L系统节点(8块SN40L芯片)就能支持到最高5万亿参数的大模型。

与其他AI芯片初创公司不一样的是,他们并没有选择直接将芯片卖给其他公司这条路线,而是选择了售卖访问其定制AI技术栈的访问权,包括其自研硬件和运行超大模型的软件等。这种商业模式或许能吸引一部分互联网公司,但在云服务厂商眼中,他们应该不会觉得这是一套可盈利的方案。

此外,SambaNova与其他竞争对手一样,在AI芯片上引入了64GB HBM用于解决内存墙的问题,这也是SN40L与上一代芯片的差异之一。只不过SambaNova并没有透露SN40L用的是何种HBM,以及带宽性能如何。

写在最后

虽然SambaNova展示了提高LLM扩展性的另一条道路,但在没有经过实际验证之前,市场还是会对其持观望态度。此前也有不少AI芯片公司发表过同样大胆的声明,但事实证明这类芯片只适合用于运行那些预训练完成的模型,而训练过程仍需要靠GPU来完成。所以哪怕SambaNova的CEO Rodrigo Liang强调SN40L的训练性能足够优秀,但是否能在这套商业模式下闯出一片天,就得交由市场去验证了。

-

gpu

+关注

关注

28文章

4980浏览量

132100 -

SambaNova

+关注

关注

0文章

7浏览量

315 -

SN40L

+关注

关注

0文章

2浏览量

100

发布评论请先 登录

?Groq LPU 如何让万亿参数模型「飞」起来?揭秘 Kimi K2 40 倍提速背后的黑科技

面向万亿级参数大模型,“超节点”涌现

万亿参数!元脑企智一体机率先支持Kimi K2大模型

大模型推理显存和计算量估计方法研究

为什么无法在GPU上使用INT8 和 INT4量化模型获得输出?

【「算力芯片 | 高性能 CPU/GPU/NPU 微架构分析」阅读体验】+NVlink技术从应用到原理

无法在GPU上运行ONNX模型的Benchmark_app怎么解决?

GPU是如何训练AI大模型的

PyTorch GPU 加速训练模型方法

【一文看懂】大白话解释“GPU与GPU算力”

不再焦虑GPU供应,8芯片挑战5万亿参数大模型

不再焦虑GPU供应,8芯片挑战5万亿参数大模型

评论