电子发烧友网报道(文/周凯扬)从最近英伟达公布的财报中就可以看出,AI应用的火热使其赚得盆满钵满,原本就在AI软硬件生态称王的英伟达,现今更是如日中天。而这样的处境也让不少AI芯片初创公司不好过,他们的产品有的还没落地,有的则难以与A100、H100这样的产品匹敌。这几年沉寂下去的AI芯片初创公司着实不少,但还是有的厂商敢于继续往这个市场里钻。

水平扩展性的限制

随着AI/ML的模型越来越大,甚至是以5年内翻4万倍的速度提升,要想在硬件上跟上软件进度已经越来越难了。可即便如此,从16nm到4nm,从低精度到脉动阵列,都给了我们巨大的优势去追随这些大模型。

但运行这些大模型终究不是靠单个芯片的力量,而是整个规模集群需要面临的问题,所以这就牵扯到了水平扩展性。工艺制程的提高带来了5倍的性能提升,芯片架构带来了14倍的性能提升,而水平扩展则要实现600倍的性能提升,才能满足未来的AI/ML计算要求。这也就是目前AI计算存在的问题,大模型往往需要更大的内存、更高的算力和更大的带宽,随着设备数量越多,这三大硬件要求的分配复杂程度就变得越来越高。

比如在GPU上就已经尝试了不少并行扩展方案,比如数据并行、流水线模型并行或张量模型并行等,但以上方案往往都会受到内存、带宽和参数量的限制,并没有单一通用的解决方案,大模型往往需要同时结合这三种方案,所以扩展效率不高。AI芯片公司Cerebras则想出了一个在大规模集群下提高水平扩展性的解决方案。

Cerebras的WSE

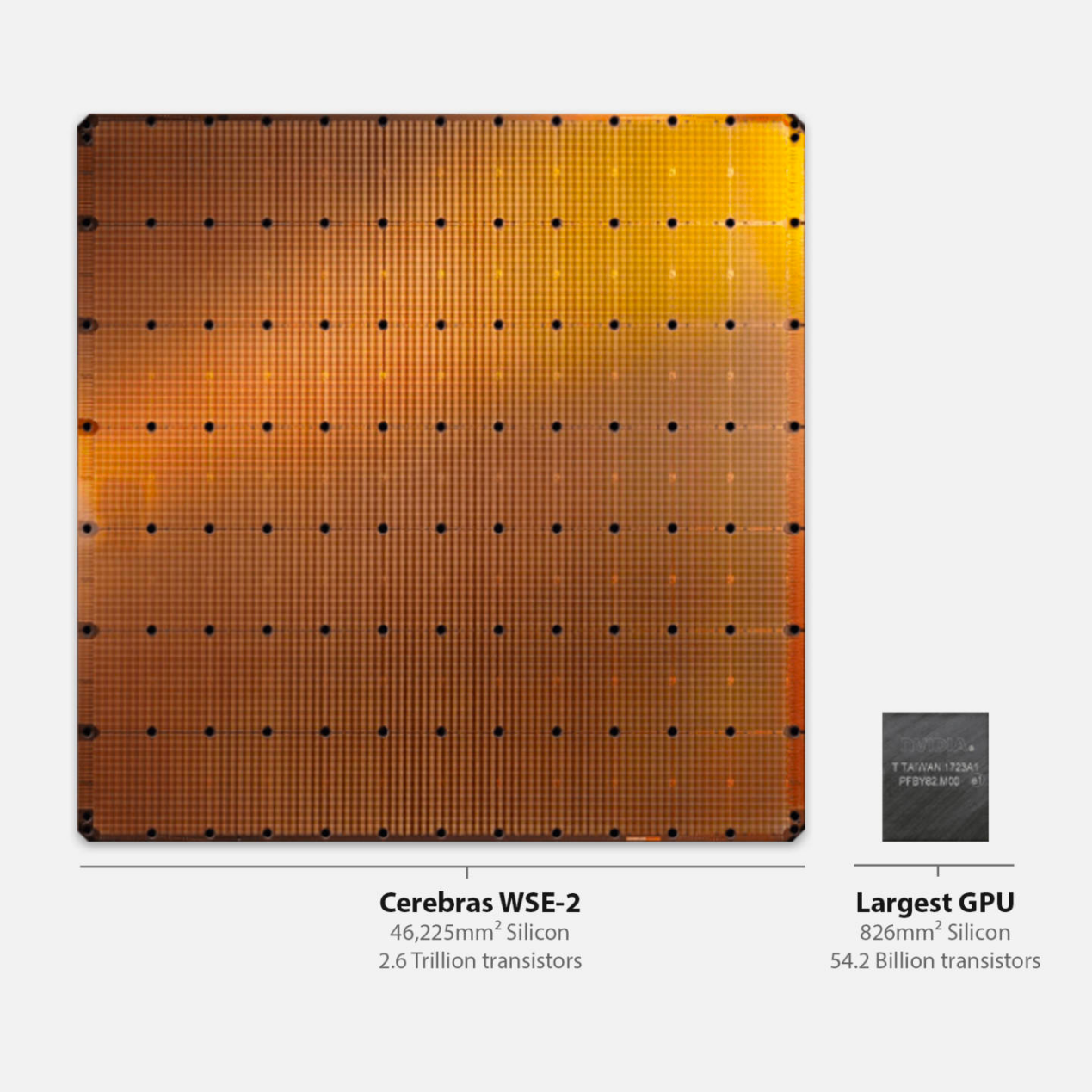

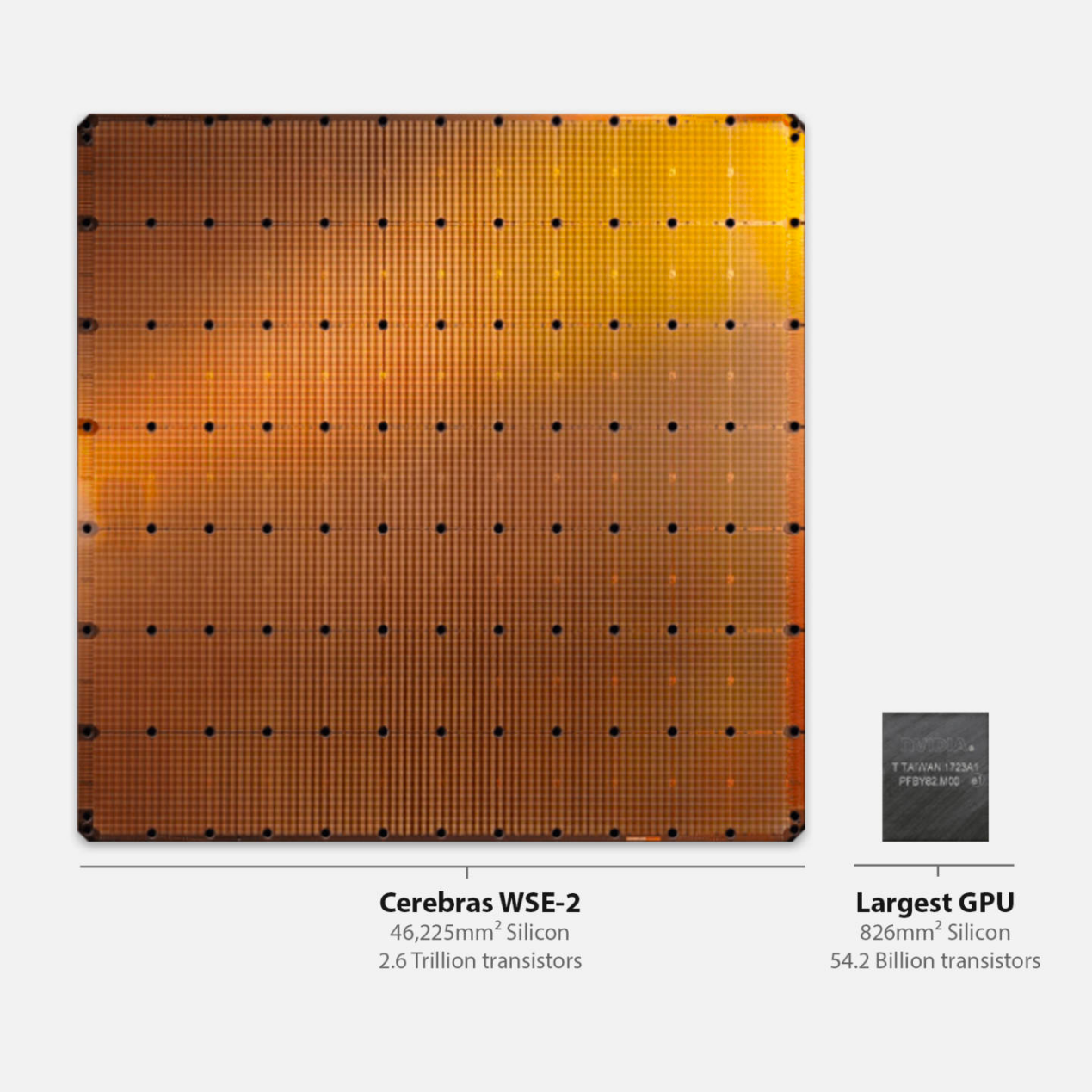

要说在AI芯片的初创公司里,走着独立无二路线的公司,Cerebras绝对能排得上名号。2019年,他们推出了WSE,一个晶圆大小的AI处理器,到了2021年,他们又推出了第二代的WSE-2,采用更先进的工艺将单个处理器的核心数推进至85万核。而这次Hot Chips上,他们则展示了用于对抗英伟达的解决方案。

WSE-2与GPU大小对比 / Cerebras

Cerebras选择了将内存和计算解耦的方案,利用内存扩展技术MemoryX,将模型权重存储在外部,然后将权重传输给WSE-2组成的CS-2系统,CS-2再将梯度传给外部存储。Cerebras还打造了一个互联方案SwarmX,用于连接多个CS-2系统,从而提高扩展性。

以Cerebras搭建的Andromeda超算为例,该超算由16个CS-2系统组成,拥有1350万个AI优化核心,稀疏算力高达1ExaFLOPs,稠密算力高达120PetaFLOPs。在这样强大的算力下,训练大模型只要几周的时间。而且在Cerebras不同规模的集群上,不同参数的大模型可以共享同样的代码,以同样的方式训练,省去了不少开发时间。

除了Andromeda以外,Cerebras也已经开始了下一个AI超算的部署,由64个CS-2系统组成的Condor Galaxy 1,该超算的算力将扩展至4ExaFLOPs的稀疏算力。而Condor Galaxy 1名字后的1,也意味着这仅仅是单个超算中心所用的系统而已,未来他们计划在2024年底之前扩展为9个超算中心,分布在美国各地,构建最大的分布式超算网络,总算力高达36ExaFLOPs,是英伟达Israel-1超算的9倍,是谷歌最大TPUv4集群的4倍。

写在最后

单从扩展性和性能的角度来看,Cerebras确实已经做到了一个新的高度。但对于购置这些GPU或AI芯片的云服务或互联网公司来说,GPU或许是一个更加通用的资源,在AI技术日新月异的当下,GPU总能凭借自己的软硬件生态快速找到自己的一席之地,并在高性能的王座上稳坐一段时间。这也就是AI爆款应用的市场导向决定的了,性能固然重要,但抢占先机才是最关键的一环。

水平扩展性的限制

随着AI/ML的模型越来越大,甚至是以5年内翻4万倍的速度提升,要想在硬件上跟上软件进度已经越来越难了。可即便如此,从16nm到4nm,从低精度到脉动阵列,都给了我们巨大的优势去追随这些大模型。

但运行这些大模型终究不是靠单个芯片的力量,而是整个规模集群需要面临的问题,所以这就牵扯到了水平扩展性。工艺制程的提高带来了5倍的性能提升,芯片架构带来了14倍的性能提升,而水平扩展则要实现600倍的性能提升,才能满足未来的AI/ML计算要求。这也就是目前AI计算存在的问题,大模型往往需要更大的内存、更高的算力和更大的带宽,随着设备数量越多,这三大硬件要求的分配复杂程度就变得越来越高。

比如在GPU上就已经尝试了不少并行扩展方案,比如数据并行、流水线模型并行或张量模型并行等,但以上方案往往都会受到内存、带宽和参数量的限制,并没有单一通用的解决方案,大模型往往需要同时结合这三种方案,所以扩展效率不高。AI芯片公司Cerebras则想出了一个在大规模集群下提高水平扩展性的解决方案。

Cerebras的WSE

要说在AI芯片的初创公司里,走着独立无二路线的公司,Cerebras绝对能排得上名号。2019年,他们推出了WSE,一个晶圆大小的AI处理器,到了2021年,他们又推出了第二代的WSE-2,采用更先进的工艺将单个处理器的核心数推进至85万核。而这次Hot Chips上,他们则展示了用于对抗英伟达的解决方案。

WSE-2与GPU大小对比 / Cerebras

Cerebras选择了将内存和计算解耦的方案,利用内存扩展技术MemoryX,将模型权重存储在外部,然后将权重传输给WSE-2组成的CS-2系统,CS-2再将梯度传给外部存储。Cerebras还打造了一个互联方案SwarmX,用于连接多个CS-2系统,从而提高扩展性。

以Cerebras搭建的Andromeda超算为例,该超算由16个CS-2系统组成,拥有1350万个AI优化核心,稀疏算力高达1ExaFLOPs,稠密算力高达120PetaFLOPs。在这样强大的算力下,训练大模型只要几周的时间。而且在Cerebras不同规模的集群上,不同参数的大模型可以共享同样的代码,以同样的方式训练,省去了不少开发时间。

除了Andromeda以外,Cerebras也已经开始了下一个AI超算的部署,由64个CS-2系统组成的Condor Galaxy 1,该超算的算力将扩展至4ExaFLOPs的稀疏算力。而Condor Galaxy 1名字后的1,也意味着这仅仅是单个超算中心所用的系统而已,未来他们计划在2024年底之前扩展为9个超算中心,分布在美国各地,构建最大的分布式超算网络,总算力高达36ExaFLOPs,是英伟达Israel-1超算的9倍,是谷歌最大TPUv4集群的4倍。

写在最后

单从扩展性和性能的角度来看,Cerebras确实已经做到了一个新的高度。但对于购置这些GPU或AI芯片的云服务或互联网公司来说,GPU或许是一个更加通用的资源,在AI技术日新月异的当下,GPU总能凭借自己的软硬件生态快速找到自己的一席之地,并在高性能的王座上稳坐一段时间。这也就是AI爆款应用的市场导向决定的了,性能固然重要,但抢占先机才是最关键的一环。

声明:本文内容及配图由入驻作者撰写或者入驻合作网站授权转载。文章观点仅代表作者本人,不代表电子发烧友网立场。文章及其配图仅供工程师学习之用,如有内容侵权或者其他违规问题,请联系本站处理。

举报投诉

-

AI

+关注

关注

88文章

35748浏览量

282387 -

英伟达

+关注

关注

22文章

3972浏览量

94347

发布评论请先 登录

相关推荐

热点推荐

英伟达、高通布局AI投资版图,这些明星企业被收入囊中!

的模型并不会减少芯片的需求,相反,未来的计算需求只会增加,尤其是对计算基础设施的需求。 英伟达也在利用其雄厚的资金大幅增加了对各种初创公司的

微软大手笔采购英伟达AI芯片

据全球知名市场调研机构Omdia的最新估计,微软在2024年的英伟达Hopper架构芯片采购计划上展现出了惊人的手笔。这一举动旨在帮助微软在构建下一代人工智能(AI)系统的激烈竞争中抢

Tenstorrent获7亿美元融资,贝索斯参投挑战英伟达

AI芯片初创公司Tenstorrent近日宣布获得高达7亿美元的融资,公司估值也随之攀升至26亿美元。此次融资旨在挑战

OpenAI领投Rain AI,挑战英伟达AI芯片市场地位

巨头英伟达展开有力竞争。 为了加强其领导团队,Rain AI于2024年6月成功聘请前苹果公司芯片执行官Jean-Didier Allegr

英伟达超越苹果成为市值最高 英伟达取代英特尔加入道指

苹果公司的市值,重新成为全球市值最高的公司。 在AI领域,英伟达正疯狂奔跑,我们看到有外媒报道英伟

英伟达加速Rubin平台AI芯片推出,SK海力士提前交付HBM4存储器

日,英伟达(NVIDIA)的主要高带宽存储器(HBM)供应商南韩SK集团会长崔泰源透露,英伟达执行长黄仁勋已要求SK海力士提前六个月交付用于英伟

英伟达拟1.65亿美元收购OctoAI

英伟达再次展现其在AI领域的雄心壮志,计划以约1.65亿美元的价格收购西雅图软件初创公司OctoAI。据OctoAI向股东披露的文件,

英伟达投资日本AI研发初创公司

Ventures及Lux Capital等业界巨头,而英伟达亦作为重要参与者加入这一行列。此番携手不仅彰显了Sakana AI在AI研发领域的深厚潜力,也预示着双方将开启一段崭新的合

韩国AI芯片巨头合并,剑指英伟达龙头地位

的合资公司创造超过1万亿韩元的业务价值,标志着韩国在AI芯片领域的雄心壮志,旨在挑战全球领导者英伟达(NVIDIA)的霸主地位。

英伟达愈发强势,AI芯片初创公司仍不服输

英伟达愈发强势,AI芯片初创公司仍不服输

评论