科学界和工业界正开始利用 AI 与数据中心规模的加速计算相结合的强大指数级算力

研究人员正在寻找能使他们的工作所需计算性能提升百万倍的“燃料”。

不断增长的数据导致计算需求飞涨。面对此情况,他们无法完全依靠已是明日黄花的摩尔定律。

因此,他们利用三大“推进器”,获取所需的指数级加速。

纵向加速和横向扩展

加速计算是科技的三大现代驱动力之一。在过去的十年中,借助五代 GPU 的进步以及我们在这些 GPU 之上构建的完整软件栈,加速计算已实现了 1000 倍性能提升。

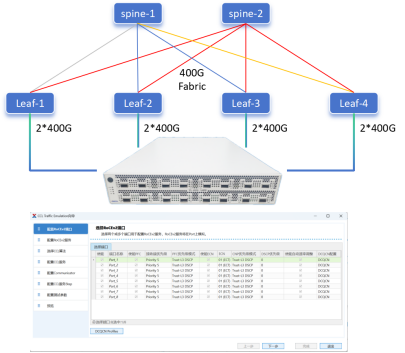

扩展能力是第二个驱动力,已取得近十万倍的性能提升。这是因为数据中心正在成为新的计算单元。

例如,在 2015 年,使用一个 Kepler GPU 训练 ResNet-50(热门的计算机视觉模型之一)花了将近一个月的时间。今天,我们在 Selene 上训练同样的模型只用了不到半分钟的时间。Selene 是世界上性能超强的工业超级计算机,其包含数千个 NVIDIA Ampere 架构 GPU。

我们开发了许多关键技术来实现这种扩展,例如 Megatron 软件、用于多 GPU 和多节点处理的 Magnum IO,以及用于网络计算的 SHARP。

开启深度学习的新时代

当今时代的第三个,也是最具变革性的驱动力是 AI。

去年,深度学习在一毫秒的时间尺度内对 3.05 亿个原子进行了模拟,揭示了新冠病毒 SARS-CoV-2 的内部结构。这项工作标志着与 15 年前在 20 秒内对 100 万个原子进行模拟的最先进技术相比,其效能增加了 1000 万倍以上。

这就是 AI 和高性能计算的结合正在席卷科学界的原因。研究人员去年在 arXiv 上发表了近 5000 篇关于利用 AI+HPC 进行工作的论文,而五年前此类论文还不到 100 篇。

最近的一篇论文来自 NVIDIA 的研究人员。它展示了一种将神经网络与经典物理方程式相结合的方法,可令传统模拟获得 1000 倍的速度提升。

加快药物研发

如今,加速计算、大规模扩展和 AI 的结合正在推动科学和工业计算的发展。

在疾病治疗领域,加速药物研发是一切工作的重中之重。这项工作颇具挑战,开发者需要解码 3D 蛋白质结构,了解其工作原理,然后发现能够阻止它们感染健康细胞的化合物。

使用 X 射线和电子显微镜的传统方法只解码了大约 25000 种人类蛋白质中的 17%。DeepMind 去年在其 AlphaFold 系统中使用了一套 AI 模型,实现了重大飞跃,预测了超过 20000 种人类蛋白质的 3D 结构。

无独有偶,NVIDIA 和美国加州理工学院的研究人员将机器学习和物理相结合,创造了 OrbNet,可加速多个数量级的分子模拟。初创公司 Entos 利用 OrbNet,令其蛋白质和候选药物之间的化学反应模拟速度提高了 1000 倍,在三个小时内就完成了原本需要超过三个月时间的工作量。

了解气候变化

类似情况在其他领域也屡屡发生。科学家希望尽快以千米级分辨率模拟全球气候,以帮助我们适应不断变化的天气模式,更好地为灾难做好准备。

但是,为了准确追踪云层和风暴的运动模式,科学家需要在一米的分辨率级别进行研究。这需要高达 1000 亿倍的计算能力。

按照摩尔定律,我们要到 2060 年才能获得这个能力。因此,寻求百万倍性能飞跃的科学家正在通过大规模加速计算和 AI 来构建我们星球的数字孪生。

多行业已应用数字孪生

研究人员已经在利用这些技术来构建工厂和城市的数字孪生。

例如,西门子能源公司使用在云中数十个 GPU 上运行的 NVIDIA Modulus AI 框架,模拟了整个发电厂。它可以预测蒸汽的腐蚀性影响造成的机械故障,减少宕机时间,节约成本并持续运作。

这种模拟技术可打造更高效的农场、医院,以及帮助任何行业转型。这就是我们开发 Modulus 原因:使创建 AI 驱动、物理级准确的模拟变得简单。

这是在当今新计算引擎的助力下,我们打造出的又一个工具,可实现下一个百万倍的飞跃。

数据中心规模的 AI 加速计算将带来百万倍的性能提升,从而解决诸如了解气候变化、研发药物和推动工业转型等问题。

责任编辑:haq

-

数据

+关注

关注

8文章

7270浏览量

92494 -

NVIDIA

+关注

关注

14文章

5363浏览量

106933 -

AI

+关注

关注

88文章

35926浏览量

283224

原文标题:GTC21 | 百万级因子:令计算能力实现Million-X 百万倍飞跃的三大驱动力

文章出处:【微信号:NVIDIA_China,微信公众号:NVIDIA英伟达】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

利用AI与数据中心规模的加速计算相结合的强大指数级算力

利用AI与数据中心规模的加速计算相结合的强大指数级算力

评论