对于需要实时响应的数据中心工作负载,性能不仅是指原始吞吐量或处理能力。挑战在于:在保持吞吐量和能效的同时,实现确定性时延。

CPU 和 GPU 仍将是基础架构。但正如系统架构师和数据中心运营商所发现的,在时延控制变得至关重要时,传统计算架构往往会遇到困难。对于那些寻求对性能、功耗和时延进行精细控制的用户来说,采用硬件自适应加速卡的自适应计算正在成为一种战略选项。

如果您正在探索如何加速实时工作负载,以下是一些基本考虑因素,有助于指导该过程,并着重介绍自适应计算的用武之地。

针对实时(而非只是原始)吞吐量构建

对于许多工作负载而言,可预测的响应时间至关重要。无论是在高频交易中,还是在数据流传感器处理中,仅靠快是不够的。您必须确保可靠情况下的快速性——无论输入变化或系统负载如何。CPU 和 GPU 拥有类似的编程模型,但依赖于线程调度和固定的存储器缓存层次结构,这可能会影响低时延响应时间。在这些架构上实现确定性性能通常需要过度配置( overprovisioning )资源、微调( fine-tuning )软件堆栈或隔离工作负载——这些都无法保证在不同系统负载下保持一致的时延。

由现场可编程门阵列( FPGA )或自适应 SoC(集成处理器子系统和专用 IP 的 FPGA)提供支持的加速卡通过提供硬件并行性和数据路径优化来解决这一问题。该架构可在电路层面进行动态编程,其中数据路径经过定制并“硬连接”至硅片本身,从而避免了不可预测的软件指令周期。这种方法能够实现始终如一的低时延性能,并对数据的处理及移动方式进行精细控制。

内存比您认为的更重要

在这些性能敏感型环境中,内存往往是隐藏的瓶颈。这不仅关乎加速器可用的内存大小,还关乎内存与计算的距离有多近,以及运行时的访问速度有多快。这正是自适应计算提供架构优势的地方,尤其是与片上高带宽存储器( HBM )结合使用时。

HBM 是一种成熟的 3D 封装 DRAM 技术,具备每秒 TB 级的带宽,可满足数据密集型加速卡的需求。但 FPGA 和自适应 SoC 还为它们带来了灵活应变的存储器层次结构,其中包括紧邻处理逻辑、大小各异的嵌入式片上 SRAM。这可以实现快速、低时延的缓冲和中间存储,无需往返外部 DRAM。对于流式应用或实时 AI 推理,这种接近性可降低时延并提升吞吐量,而不会阻塞流水线。

将您的加速卡直接连接至网络

如果您的加速卡会处理来自网络的流式数据,为何不将其直接连接至网络?传统的加速卡依靠 PCIe接收传入数据——通常经过网络接口卡( NIC )进行路由,然后通过主机 CPU 和系统内存,最终到达加速器。这会带来时延并消耗资源。

基于 FPGA 的网络连接加速卡可直接连接以太网,从而实现在数据到达时进行实时处理。这也为高性能计算( HPC )环境提供了经由以太网的可扩展计算集群。

随工作负载演进调整您的加速卡,

而非基础架构

如今推动您的基础设施发展的工作负载与未来扩展基础架构的工作负载将有所不同,而自适应计算能够随着应用发展而演进。例如,在网络防火墙中,加密协议和威胁检测模型在不断演进。在同一服务器节点上部署压缩、解压缩和分析功能的存储机架中,灵活的硬件可以随着数据量的增长或压缩格式的改变而调整计算管线。

同一加速卡的架构灵活性可以带来长期效益,不仅能实现实时性能,还能在工作负载需求变化时保持敏捷性——所有这些都在同一张卡、同一台服务器和同一个机架上实现。

借助适合的硬件专业技术加速部署

要最大限度提升基于 FPGA 的加速卡性能,需要获得 FPGA 开发人员的帮助。无论是通过内部团队、设计合作伙伴,还是预构建 FPGA IP 的提供商,成功都取决于能否构建或集成满足严格时延、吞吐量和内存访问要求的特定应用逻辑。

为了加快部署速度,需要寻找一款可提供强大 FPGA 工具链、预验证 IP 和合作伙伴生态系统的平台,该平台支持从 RTL 开发到完整解决方案集成的所有环节——助力您的团队满怀信心地从概念走向量产。

下一步

这些只是低时延和工作负载灵活应变性至关重要的几项考虑因素。尽管 CPU 和 GPU 仍然作为数据中心的核心,但它们并非永远最适合流式工作负载。自适应平台——例如集成 HBM 的 AMD Alveo V80 计算加速卡——则提供了另一条途径。凭借连网连接、自适应硬件架构和高带宽存储器,Alveo V80 计算加速卡可以在最关键时刻提供实时性能。

-

处理器

+关注

关注

68文章

19995浏览量

239518 -

cpu

+关注

关注

68文章

11151浏览量

219299 -

数据中心

+关注

关注

16文章

5351浏览量

73953

原文标题:在数据中心进行实时加速

文章出处:【微信号:赛灵思,微信公众号:Xilinx赛灵思官微】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

通过NVIDIA RTX PRO服务器加速企业工作负载

NVIDIA加速的Apache Spark助力企业节省大量成本

程控水冷负载解析

NetApp革新块存储,赋能现代工作负载

Arm技术助力Google Axion处理器加速AI工作负载推理

HPC工作负载管理的关键要素

亚马逊云科技发布Amazon Q Developer,助力工作负载转型

燃料电池测试负载如何进行负载测试?

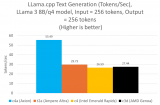

深度学习工作负载中GPU与LPU的主要差异

如何加速实时工作负载

如何加速实时工作负载

评论