[首发于智驾最前沿微信公众号]自动驾驶汽车想要自动驾驶,首先要做的就是能对周边环境实现精准感知,也就是能“看”清道路,那自动驾驶汽车如何在复杂、快速变化的道路环境中做到感知的精确又可靠?

自动驾驶感知的定义及原理

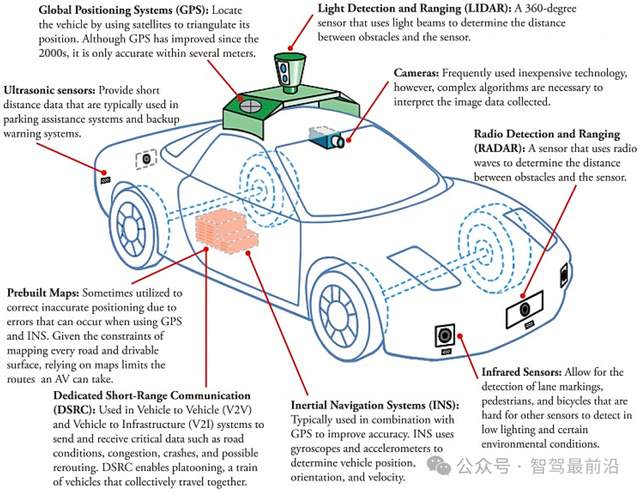

在聊这个话题之前,我们先聊一聊感知是什么,自动驾驶感知系统就是一个把外界变成机器可用信息的工程流水线。感知系统的输入主要依靠如摄像头(可见光、近红外)、激光雷达(LiDAR)、毫米波雷达(RADAR)、超声波传感器、定位传感器(GNSS/INS)以及车载惯性测量单元(IMU)等传感器。这些传感器各自擅长不同事情,摄像头分辨率高、能识别颜色和标志,但在夜间或强反光时受限;雷达对速度和恶劣天气的鲁棒性强但分辨率低;LiDAR能给出精确的三维点云,有利于重建物体形状和距离,但成本和在雨雪雾中的性能却差强人意。自动驾驶汽车想实现精确感知不是只靠某一种传感器就可以,而是要把这些互补传感器组合成一个“感知套件”,由软硬件把传感器的原始数据转成语义化、结构化的环境模型(例如:周围有哪些物体、它们的位置、速度、预测轨迹等),供规划与控制模块使用。

为什么一定要把不同传感器的数据融合起来?想像一下人类开车的感知,在白天主要靠视觉,但雨夜或浓雾环境中,视觉感官受到影响,此时就需要靠触觉、听觉甚至微妙的经验来弥补视力不足,对于自动驾驶汽车来说也是如此。单一传感器有“盲区”和特定失效模式,摄像头在强逆光、夜间或遮挡物后面就看不见;雷达在细小形状的细节检测上弱;LiDAR在大雨和积雪时会产生噪声。将多传感器数据做融合,不仅能互补信息,还能通过冗余提高安全性和鲁棒性。这些融合既包括在原始数据层面的“早期融合”(例如把点云投影到图像上做联合感知),也包括在决策层或轨迹层面的“后期融合”。近年来大量研究把深度学习方法与传统滤波器方法结合,用以提升融合效果与实时性。

既然感知系统非常重要,那感知系统的工作流程有哪些?其实可以把感知系统分成几个连续的子任务,即传感器数据采集、时间同步与预处理、检测与分割、跟踪与状态估计、场景理解与预测、以及最终的输出表示。数据采集要求硬件接口、高带宽和确定性时延;时间同步要把不同传感器的时序对齐,否则融合出的世界模型会出现“幽灵”物体。预处理包括去噪、畸变校正(摄像头畸变、LiDAR的点云去畸变)、以及基于内参/外参的坐标变换。检测通常是深度网络或者基于点云的模型输出物体边界框与类别;跟踪模块会把连续帧中的检测结果关联起来,估计物体的速度与加速度,使后续预测更稳定;预测模块给出未来几秒内其他参与者可能的运动;最后把这些语义化信息打包成地图层、障碍列表、车道信息等。整个链路要求实时性、确定性与可解释性(尤其在安全场景下)。这些模块在工程上往往并非完全独立,而是一个有反馈回路的系统,感知的置信度会反馈给规划层以决定是否降级或请求人工接管。

如何确保感知的准确性?

懂得了感知系统的工作流程,那如何保证感知“精确”?在谈及这个之前,先说“精确”到底包含什么,“精确”即定位精度(egovehiclelocalization)、检测精度(有没有漏报或误报)、测距精度(目标与车的相对位置误差)、速度/轨迹估计精度、以及语义/类别识别准确率等。

硬件层面的保证主要是冗余与分工。冗余是指同一类或不同类传感器的数量和布局以避免单点失效,例如前向长距雷达用于高速远距探测,侧向短距雷达加强盲区探测,顶部LiDAR提供360°点云感知,多个摄像头覆盖不同视角以完成覆盖和立体视觉。传感器的选择和放置不是随意的工程美学,而是基于视野、量程、分辨率、以及车辆动力学需求来决定的。不同厂商会根据成本和业务场景在“全套感知”与“精简感知”之间做平衡,像Waymo、Cruise等机器人出租车一般采用较丰富的套件以追求更高的鲁棒性。

算法层面的保证包含感知模型本身的设计、融合策略与不确定性建模。传统的滤波方法(卡尔曼滤波、扩展卡尔曼滤波、粒子滤波等)长期用于目标跟踪和状态估计,擅长在已建模噪声下给出概率最优估计;近年深度学习在物体检测、语义分割、以及基于注意力的跨模态融合上表现出强大能力,因此实际系统常见“混合”策略:用深度网络做检测/分类/分割,用滤波器做跟踪与状态平滑,并在融合时引入基于置信度的不确定性加权。对于多传感器延迟、数据丢包或对齐误差,工程上也会用时序补偿、延迟估计与延迟补偿算法来降低误差影响。最新研究还把“感知的不确定性”直接纳入网络输出(例如输出置信度与协方差矩阵),让上层规划模块依据不确定性决定更保守的动作。

标定与同步是工程里经常被低估但至关重要的一环。每个传感器都有自己的内参(例如摄像头的焦距、畸变系数)和外参(传感器相对于车辆坐标系的位姿)。多传感器融合的前提是这些外参要在毫米级或更高精度下正确,不然融合出的点云和图像映射会出现偏移,最终导致误判或跟踪失败。标定分为静态标定(在实验室或停车场用标定板完成)和在线自标定(车辆在运行过程中对外参进行微调以应对安装抖动或温度引起的漂移)。此外,时间同步(把不同传感器的采样时间统一)也同等重要:即便空间对齐精确,如果时间不同步,在高速场景下也会导致相同物体在不同传感器的相对位置发生显著偏移。工程实践包括定期自动校准、启动自检、以及对标定变差的容错策略。

数据和验证策略则是保证精确的另一个重要维度。自动驾驶感知的训练与测试强烈依赖大规模、多样化、带标注的数据集。过去十年里,出现了诸如KITTI、nuScenes、WaymoOpenDataset等公开数据集,这些数据集包含不同城市、天气、传感器组合下的标注,是算法开发和benchmark的基石。除了离线数据集,行业还大量依赖仿真(包含高保真物理渲染与传感器噪声建模)来补充稀有或危险场景的训练样本。验证不仅是单纯的离线指标评估(例如平均精度AP、定位误差等),更重要的是系统级测试,也就是在闭环仿真、封闭场地的场景回放、以及大量里程的实际道路测试中评估感知在真车条件下的表现。只有通过多层次、多场景的检验,才能对一个感知系统的精确性和鲁棒性形成工程级信心。

那在工程实施上,如何处理罕见但危险的场景?这里有两个常见做法,一是“扩大数据覆盖”,通过有针对性的采集与仿真合成极端天气、罕见交互、以及遮挡场景;二是“安全降级策略”,也就是说当感知置信度下降或发现显著不一致(例如LiDAR检测到物体但相机未确认,且置信度低)时,系统会触发如减速、靠边、进入受限模式或请求人工接管等更保守的规划策略。把“系统不确定性”作为主动决策的输入,是保证安全的重要设计思想。制造一个既勇敢又谨慎的自动驾驶系统,本质上是工程上的权衡艺术。

另外,感知系统的可解释性、可追溯性也非常重要,尤其在出现事故或异常时。这就需要设计完整的日志体系,记录感知模块的每一步置信度、传感器状态、标定历史和异常告警。这不仅可以帮助定位故障根因,也为算法改进提供数据支持。在某些严格的验证场景下,厂家会把感知决策的关键中间表示(例如特征图、点云投影、跟踪历史)保存下来,以便事后复盘和法规合规需要。

那未来感知系统会如何发展?随着端到端深度学习在某些感知子任务上取得突破,可以通过联合视觉+点云的多模态网络提升检测精度;此外,传感器硬件也在迭代,成像雷达、固态LiDAR、以及更高分辨率的毫米波雷达正在被商业化,提供了更多选择。工程层面其实更强调“软硬件协同优化”,也就是把传感器能力、数据带宽、算力、以及算法设计一起考虑,做出成本-性能-安全的平衡。运营层面,则是把大量现实车队数据回传,做持续的模型迭代和边缘部署更新,以提升系统在真实世界的长期表现。

最后的话

总结一下,自动驾驶的感知系统不是单一的“相机”或“激光雷达”,而是一个由多种传感器、复杂算法、严格标定和系统级验证组成的工程体系。要做到“精确”,需要在硬件冗余、算法融合、不确定性建模、标定同步、以及大规模数据验证上同时用力。技术路上没有捷径,只有工程上的反复验证、对异常的深入分析与对系统安全边界的严谨设计,才能把“看见世界”的能力变成可用、可控、可验证的自动驾驶产。

-

传感器

+关注

关注

2569文章

53362浏览量

770894 -

感知

+关注

关注

1文章

74浏览量

12517 -

自动驾驶

+关注

关注

790文章

14418浏览量

171663

发布评论请先 登录

如何确保自动驾驶汽车感知的准确性?

如何确保自动驾驶汽车感知的准确性?

评论