WAIC 2025前夕,在摩尔线程技术分享日上,摩尔线程GPU 计算软件开发总监吴庆,发表了题为《摩尔线程 MUSA 软件栈助力 KUAE 集群释放无限潜能》的演讲。他从专业视角出发,深入剖析了 MUSA 软件栈在驱动 KUAE 集群高效运转方面的核心技术与创新成果。

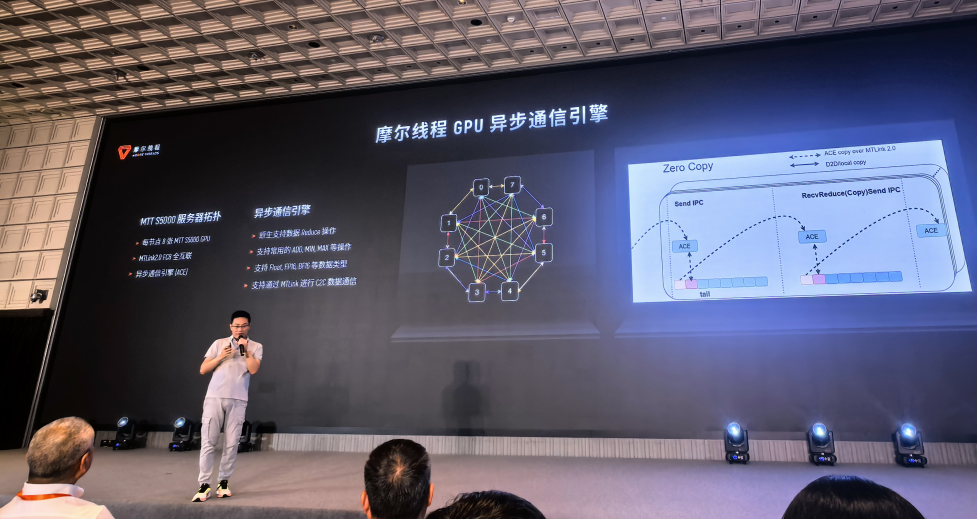

摩尔线程GPU 计算软件开发总监吴庆在WAIC 期间的技术分享 (来源:电子发烧友网拍摄)

一、MUSA 驱动和运行时库:KUAE 集群的坚实底座?

首先是驱动的重要性。在推理场景中,Kernel 延时如同悬在高效运算头上的 “达摩克利斯之剑”,对运算效率影响极大。而摩尔线程的 MUSA 驱动和运行时库就像是一位技艺精湛的调度大师,凭借自身高效的任务调度能力,将用户的 Kernel launch 开销大幅缩减,为 KUAE 集群筑牢了根基。

吴庆详细介绍,MUSA 实现即时任务下发,通过独特的软硬协同方式,将核函数启动延迟成功降低到业界平均水平的 1/2。打个比方,这就如同在酷热的仲夏,人们能够借助手机远程提前开启暴晒在户外车辆的空调,待上车时便能立刻享受清凉。MUSA 正是巧妙地将调度开销前置,在上一个 Kernel 执行尚未结束时,就提前有条不紊地完成下一个 Kernel 的配置,由此最大程度减少了 Kernel 间的调度延时,让运算衔接更加紧密流畅。?

在批量任务下发方面,吴庆表示,MUSA 将近千次的计算和通信任务下发开销巧妙优化为单次。他举例解释道,这类似于汽车座椅的一键记忆功能,驾驶者只需轻松操作一次,就能一次性打包调节好多个复杂步骤,后续使用时无需再重复繁琐操作。在实际应用中,这种优化带来的端到端收益因不同应用场景而有所差异,最高可达好几倍,极大节省了 GPU 的等待时间,提升了整体运算效率。

谈及引擎间依赖解析能力,吴庆强调,GPU 拥有多引擎可配置的特性,MUSA 借助硬件解析引擎间的依赖进行同步,这一创新之处在于无需再回到 host,从而使任务流之间的依赖解析延时大幅降低至 1.5μs,相较于业界头部算力卡表现更为出色。此外,吴庆还介绍了调优工具接口 MUPTI,它能够像贴心助手一般,帮助开发者深入优化 MUSA 应用程序;而 GPU 错误转存功能(GCD)则在程序遭遇出错情况时,迅速生成详细信息,大大提升了问题定位的效率,为程序稳定运行保驾护航。?

二、MUSA 算子库生态:性能与广度兼备?

吴庆在演讲中着重提到,算子库的效率在分布式集群的训练过程中扮演着关键角色,恰似汽车的引擎决定着汽车的动力表现。MUSA 算子库在研发过程中,始终秉持着追求极致性能的理念,同时兼顾覆盖广度和兼容性,致力于为用户提供丰富多元的选择。?

MUSA 算子库生态涵盖三大算子库。吴庆首先介绍了 muDNN,它堪称是开箱即用的标准算子库,功能十分全面,完整覆盖常见的前向和反向算子,对完整的 XMMA、Tensor Core 全精度及所有量化模式等均提供支持。在性能数据上,其矩阵乘算子效率可达 98%,Flash Attention 算子效率能达到 95%,这些数据远超行业平均水平,彰显出强大的运算实力。在讲解 FP8 GEMM 算子效率时,吴庆形象地比喻道,Per-Tensor scale 如同整面墙刷一种颜色,操作过程简单直接;而 Per-Block scale 则像给墙上的小方块刷不同颜色,复杂度明显更高。但摩尔线程通过深度的软硬协同优化,成功使 Per-Block 与 Per-Tensor FP8 GEMM 计算效率差距控制在不到 2%,极大提升了复杂场景下的运算性能。?

接着,吴庆介绍了 MUTLASS,它作为高性能线性代数模板库,已经在 Github 开源。MUTLASS 支持平湖架构所有特性,并且贴心地提供 Attention 最优化示例,这一举措极大降低了用户自定义算子的开发工作量,让开发者能够更便捷地进行相关开发工作。最后,吴庆透露,即将发布的 MUSA AI Tensor Engine 是面向大语言模型的开源推理算子库,它提供友好的 Python API,未来还将支持丰富后端,能够助力开发者快速搭建自定义推理引擎,为大语言模型领域的开发工作带来更多便利与可能。?

三、高性能通信技术:避免通信抢占计算核心资源?

在大模型分布式训练领域,通信问题一直是制约发展的主要瓶颈,犹如交通拥堵阻碍城市高效运转。吴庆在演讲中指出,摩尔线程在 MTT S5000 上支持 MTLINK 2.0,并创新性地配备 GPU 异步通信引擎,成功实现了通信技术与计算的高度并行,为解决这一瓶颈问题提供了有效方案。

图:摩尔线程的异步通信引擎技术支持通过MTLink进行C2C数据通信

吴庆回顾道,早在之前,摩尔线程的技术团队就敏锐洞察到通信与计算抢占 SM 计算单元这一行业痛点,经过深入研究与技术攻关,最终在 GPU 上成功增加了异步通信引擎。以 MTT S5000 服务器为例,每节点配备 8 张 GPU,通过 MTLINK 2.0 实现全互连,每张 GPU 与其他 7 张 GPU 直连。并且,每个 GPU 的异步通信引擎原生支持多种 reduce 操作和数据类型,还能借助 Zero Copy 技术避免本地 D2D 拷贝,直接进行跨卡通信,大大提升了通信效率。?

在通信性能方面,吴庆详细列举了相关数据。基于全互联(FC8)拓扑的高效通信算法,在单机 8 卡 All Reduce 场景中,将延迟从 Ring 算法的 53us 大幅降至 7.8us,缩减近 1/7;带宽方面,单机 8 卡 All Reduce 带宽利用率接近 85%,跨节点通信中,All Reduce 带宽达 194GB/s,RDMA 通信带宽利用率更是高达 97%。不仅如此,异步通信引擎的通信优化将通信部分巧妙卸载到单独引擎,不占用 MPC 计算资源,在无数据依赖时能够实现完全 overlap。吴庆特别提到,结合 MT Transformer Engine,这一优化使 Llama 模型端到端计算通信性能提升约 10%,切实为大模型分布式训练的高效运行提供了有力支撑。?

四、展望未来:首届MUSA开发者大会即将启幕

分享日最后,摩尔线程还宣布将于今年10月举办首届MUSA开发者大会,进一步推动国产GPU生态建设。从芯片架构到集群系统,从技术突破到行业落地,摩尔线程正以“AI工厂”为蓝图,引领国产算力基础设施迈向AGI时代的新高度。(完)

-

gpu

+关注

关注

28文章

4968浏览量

131675 -

MUSA

+关注

关注

0文章

5浏览量

2096 -

摩尔线程

+关注

关注

2文章

242浏览量

5456

发布评论请先 登录

摩尔线程副总裁王华:AI工厂全栈技术重构算力基建,开启国产 GPU 黄金时代

摩尔线程亮相WAIC 2025:以“AI工厂”理念驱动算力进化,全栈AI应用赋能千行百业

摩尔线程发布Torch-MUSA v2.0.0版本 支持原生FP8和PyTorch 2.5.0

摩尔线程GPU率先支持Qwen3全系列模型

摩尔线程GPU成功适配Deepseek-V3-0324大模型

摩尔线程吴庆详解 MUSA 软件栈:以技术创新释放 KUAE 集群潜能,引领 GPU 计算新高度

摩尔线程吴庆详解 MUSA 软件栈:以技术创新释放 KUAE 集群潜能,引领 GPU 计算新高度

评论