电子发烧友网报道(文/梁浩斌)周二xAI发布了Grok3,这个马斯克称之为“地球上最聪明的AI”抢占了所有人的眼球。

为了打造最强AI大模型,xAI投入了20万块H100 GPU,计算资源是上一代Grok2的15倍左右。在Benchmarks中,Grok3毫无悬念成功地领先Deepseek R1、o3 mini等对手。

不过用如此大规模的算力集群,花费上一代15倍的计算资源投入,业界认为Grok3的性能只是略微提升了大模型能力上限,实际提升幅度低于算力投入的预期。这或许也预示着大模型的Scaling Laws或许已经出现边际效益递减。

来源:X

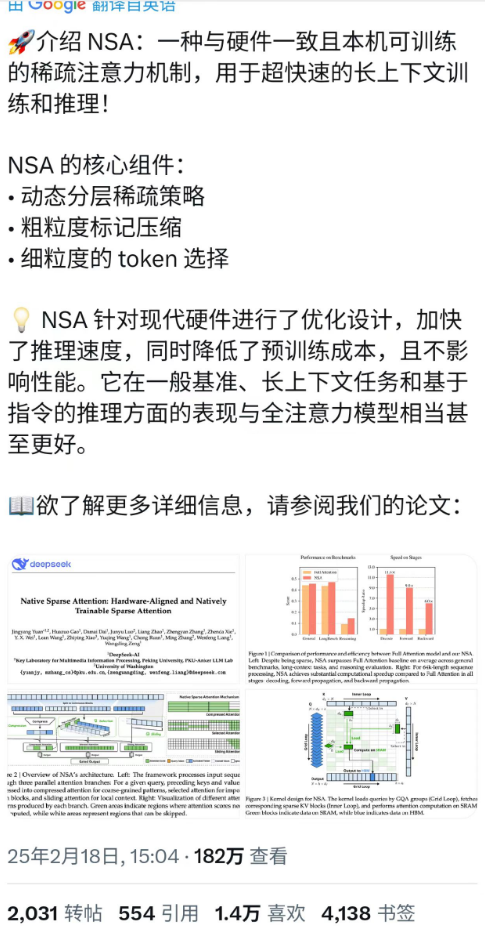

就在Grok3发布的当天,DeepSeek团队也发表了一篇论文(https://arxiv.org/pdf/2502.11089),介绍了一种新的稀疏注意力机制(Natively Sparse Attention,NSA),用于提升长文本训练和推理的效率,并具备硬件对齐和端到端训练的特性。

截至19日下午,这篇推文在X上已经有超过180万观看量。值得一提的是,DeepSeek创始人梁文锋也出现在这篇论文的作者名单中。下面我们就来看一下这篇论文有哪些创新点。

核心理念:用更少的计算做更多的事

在大语言模型(LLM)发展的初期,曾经有一段时间处理长文本是考量不同模型性能的指标之一。因为传统LLM在处理长文本时要面临的一个问题是,计算成本过高。

为什么计算成本高?这主要是因为LLM此前使用的“全注意力”机制需要计算每个词与其他所有词之间的关系,当文本长度增加时,这种计算量会以指数级别增加,导致高延迟和高能耗,大幅增加了计算成本。比如要处理一本十万字的书时,传统方法需要计算这十万字中所有词之间的两两关系,这会让计算速度变得极为缓慢,甚至根本无法完成任务。

为了解决这个问题,实际上稀疏注意力(Sparse Attention)机制一直在LLM中被应用。稀疏注意力的核心思想是,不需要计算所有词之间的关系,只需要关注那些最重要的部分。通过这种方式实现“偷懒”,可以大大减少计算量,同时保持模型性能。

但现有的稀疏注意力机制也存在一些问题,比如在推理端,尽管理论上计算量是减少了,但实际推理速度没有明显加快;而在训练端,现有的稀疏注意力机制在训练端效果都不太好,只适用于推理阶段。

所以这次DeepSeek团队推出的NSA就是为了解决现有稀疏注意力机制的缺点,提高计算效率。

具体来看,NSA主要通过对文本的处理和硬件优化两大方面实现。在文本处理方面,NSA采用分层稀疏策略,首先是将文本进行粗粒度压缩,即将长文本分成多个块,比如每32个词为一个块,然而用机器学习模型提取每个块的摘要,减少计算量。

然后对文本进行细粒度选择,即动态筛选出对当前任务最关键的几个块,比如通过注意力评分选出16个块,只计算这些块的详细信息。

最后保留局部的上下文,比如最近的512个词,来确保模型能够捕捉到上下文中短期的关系。

这个过程可以用阅读书本来理解。比如你想看一本很厚的书,但没有时间逐个字去看,那么你会通过哪些方法去了解这本书里的内容?上面提到的粗粒度压缩,就相当于是将这本书快速翻阅一下,每页都只是一眼扫过,大致了解内容;而细粒度选择,就相当于标记出书里比较重要的章节和段落;最后仔细阅读标记出来的部分,同时也能简单看一下标记部分的上下文内容,这样对于快速阅读一本书而言显然会是一个有效的方式。

而在硬件优化方面,NSA首先是将数据按连续块加载到GPU的内存中,减少随机访问的开销,实现分块内存访问;在解码阶段,令多个注意力头共享相同的键值缓存,降低内存带宽需求;在训练阶段,直接引入稀疏性,确保模型学会如何有效利用稀疏结构,实现端到端训练。

DeepSeek在使用NSA进行验证时,实际效果也相当喜人。首先是模型的训练和推理速度都有明显的提升,在64k长度的文本处理中,使用英伟达A100 GPU,NSA的推理速度比传统注意力快11.6倍,训练速度提升6-9倍。

同时在知识问答(MMLU)、代码生成(HumanEval)、长文本理解(LongBench)等任务中,NSA的性能与全注意力模型相当甚至更好。证明NSA在提高效率的同时,依然可以保持良好的模型性能。

通过适配GPU的Tensor Core和内存架构,NSA也能最大化硬件利用率。NSA首次将分层稀疏策略与GPU内存层级(HBM→SRAM)对齐,实现理论计算节省与实际加速的统一。

所以总结下来,NSA的出现解决了稀疏注意力机制在实际应用中的两大难题。在推理效率上,NSA显著加快长文本处理速度,令大模型能够处理更多超长文本任务;在训练上,NSA相比传统的稀疏注意力机制,可以更好地支持模型训练。

更重要的是,NSA证明了稀疏注意力不是只能被用于推理,还能在训练上应用,这能够为下一代低功耗、高吞吐的LLM部署提供了关键技术基础。

Kimi同步发布MoBA论文,提高长文本处理效率

来源:X

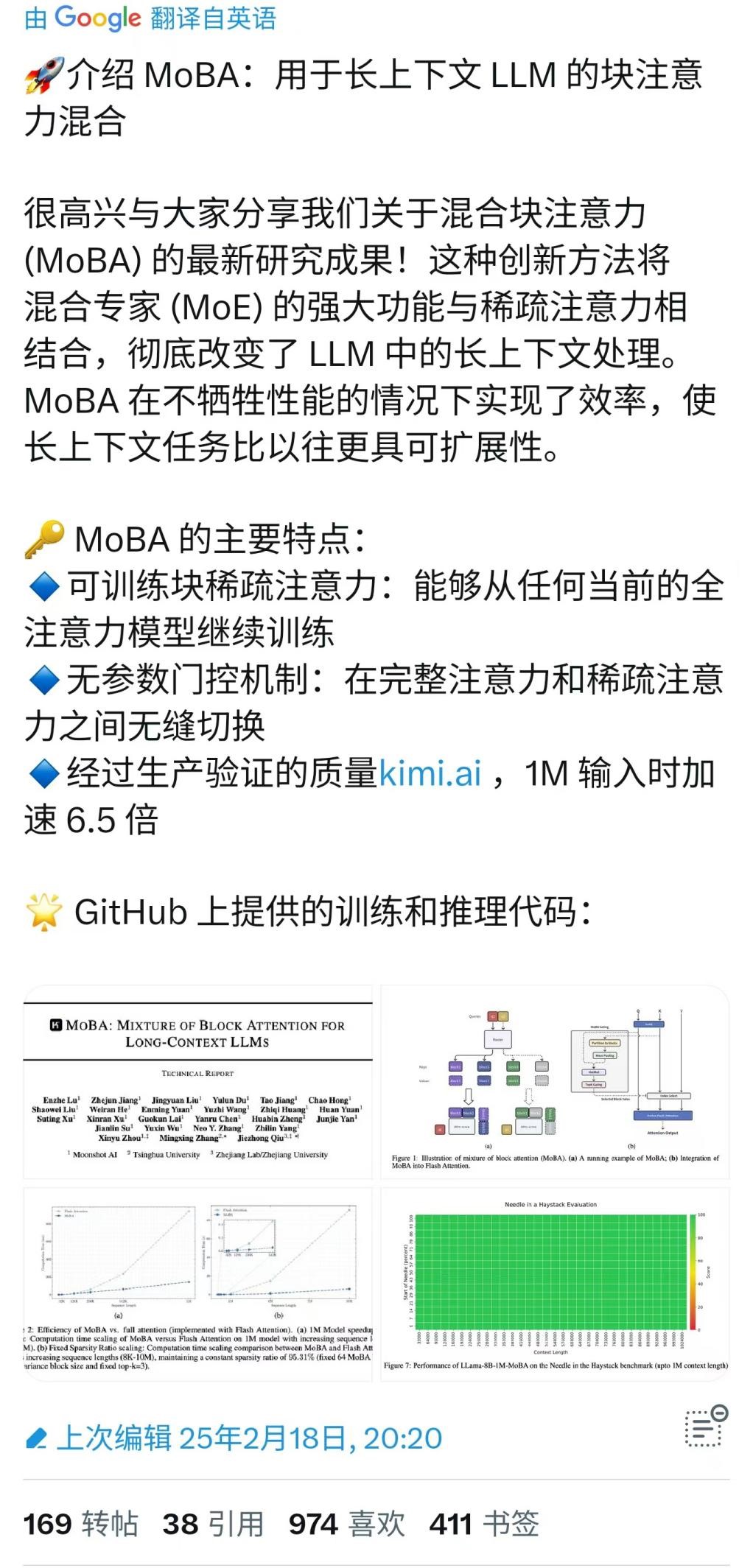

DeepSeek发布论文的同一天,Kimi也发布了与NSA类似的MoBA,同样采用了稀疏注意力的机制,旨在解决大语言模型处理长上下文时计算成本过高的问题。(论文链接https://github.com/MoonshotAI/MoBA/blob/master/MoBA_Tech_Report.pdf)

不过于NSA不同的是,MoBA借鉴了“专家混合”(MoE)的理念,把整个文本分成多个“块”,然后通过一种“选择机制”决定每个查询应该关注哪些块。这种方式类似于让模型自己决定“哪些部分更重要”,而不是预先设定固定的规则。

MoBA的核心是“动态选择”,即通过一个“门控机制”来决定哪些块需要被关注。这种方式让模型可以根据任务需求灵活调整注意力范围。

同时在硬件优化上,结合了FlashAttention技术,进一步提升了计算效率。通过分布式计算解决了GPU内存限制的问题,可以轻松扩展到1000万词以上的超长序列。超长文本也是MoBA最显著的特性之一。

小结:

目前大模型Scaling Laws已经开始出现边际效益递减的迹象,未来提高算力利用率可能是推动大模型应用普及的关键方向。但随着AI应用的不断普及,算力需求整体来看依然是会继续增长,大模型想要继续发展,继续投入算力硬件的回报或许不会再有显著提升,各大研究机构和公司还需要寻找更多新的突破。

-

DeepSeek

+关注

关注

2文章

806浏览量

1887

发布评论请先 登录

【「DeepSeek 核心技术揭秘」阅读体验】--全书概览

【「DeepSeek 核心技术揭秘」阅读体验】书籍介绍+第一章读后心得

信而泰×DeepSeek:AI推理引擎驱动网络智能诊断迈向 “自愈”时代

NVIDIA Blackwell GPU优化DeepSeek-R1性能 打破DeepSeek-R1在最小延迟场景中的性能纪录

【书籍评测活动NO.62】一本书读懂 DeepSeek 全家桶核心技术:DeepSeek 核心技术揭秘

MVG推出SpeedProbe DL解决方案:有源相控阵天线校准速度提升至5倍

DeepSeek推动AI算力需求:800G光模块的关键作用

【幸狐Omni3576边缘计算套件试用体验】DeepSeek 部署及测试

壁仞科技支持DeepSeek-V3满血版训练推理

研华边缘AI平台测试DeepSeek蒸馏版模型的最新数据

DeepSeek推出NSA机制,加速长上下文训练与推理

了解DeepSeek-V3 和 DeepSeek-R1两个大模型的不同定位和应用选择

昆仑芯率先完成Deepseek训练推理全版本适配

DeepSeek最新论文:训练速度提升9倍,推理速度快11倍!

DeepSeek最新论文:训练速度提升9倍,推理速度快11倍!

评论