电子发烧友网报道(文/李宁远)近日,韩国政府拟与AI芯片、云计算企业联合,组建团队研发高算力、低能耗的神经网络处理器NPU推理芯片。这一举措的目的是与英伟达竞争并避开英伟达主导的图形处理单元GPU市场。

自OpenAI旗下的智能聊天机器人程序ChatGPT去年年末发布后,全球掀起了一波人工智能热潮,热度持续至今。ChatGPT超出人们预期的智能化表现掀起了人工智能领域的技术革命。这一场生成式人工智能热潮催生了海量的数据,处理海量的数据离不开背后庞大的基础算力作为支撑。

CPU、GPU和DPU作为人们熟知的人工智能场景中重要的算力芯片,能够为高带宽、低延迟、数据密集的计算场景提供计算引擎,是未来处理超算流量和安全网络存储的核心硬件。而神经网络处理器NPU作为一种专门用于进行深度学习计算的芯片,在大算力应用场景的应用优势也正被业界广泛看好。

NPU,为深度学习计算而生

早在2011年,Google就已经提出了利用大规模神经网络进行图像识别的技术,由于深度学习计算需要大量的计算资源和算力支持,此时传统的CPU和GPU并不能完全满足这种需求,因此NPU应运而生。

设计NPU的目的就是为了进行深度学习计算,其特点是具有极高的计算效率和能耗效率,能够运行多个并行线程在短时间内完成大规模的神经网络计算任务。NPU的计算单元通常采用矩阵计算、向量计算等方式以保证快速完成计算任务。

同时为了计算单元快速处理数据,其存储通常采用高速缓存和显存的结合方式,方便更快地存取和读取数据。这种设计在降低计算延迟和提高复杂计算任务稳定性有着很明显的帮助。

NPU和TPU、BPU这些AI芯片一样,同属于ASIC专用集成电路,是为特定应用场景(如NPU的神经网络和深度学习场景)而设计的定制芯片,其开发成本高且周期长,但在性能和功耗上优于同时期的GPU和FPGA。

传统的ASIC在开发完成后是不能更改的,这一点上NPU还是略有差异,NPU一般会具有一定的可编程性,可以通过更改配置适配不同的计算任务,所以其日后的应用空间也远不止局限于深度学习模型。

NPU这种专用芯片在特定的人工智能需求下提供了一种提升算力和能效比的新思路。虽然GPU已经针对AI算法加强了并行计算单元,但NPU更容易从高规律性的深度神经网络中获益,短时间内完成大规模的神经网络计算任务。

在ChatGPT拉高算力需求的背景推动下,NPU开始进入发展快车道。

大模型需求推动NPU产业发展

目前,国内人工智能芯片行业里GPU仍然是首选,根据IDC的数据,GPU占有90%以上的市场份额,而NPU、FPGA和其他ASIC等非GPU芯片占有的市场份额相对较少,整体市场份额接近10%,其中NPU的占比为6.3%。

在这条新赛道上,还没有哪一家厂商成为巨头主导市场,韩国政府与AI芯片、云计算企业联合发展高算力、低能耗的NPU也正是为了避开了英伟达主导的GPU市场,开辟一条新的增强AI芯片实力的道路。

今年4月已有韩媒BusinessKorea报道,三星半导体已成功量产采用三星14nm制程工艺第一代WarBoy NPU芯片,速度可以达到普通GPU的十倍,预计不久后投入市场,同时第二代WarBoy NPU芯片预计采用5nm工艺,明年或可推出。

国内NPU行业也是潜力十足,不同于CPU、GPU国内起步较慢,国内芯片设计公司在NPU这条赛道的起步时间不晚,已经有不少相关产品量产并推出应用。

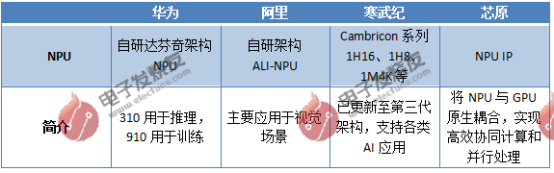

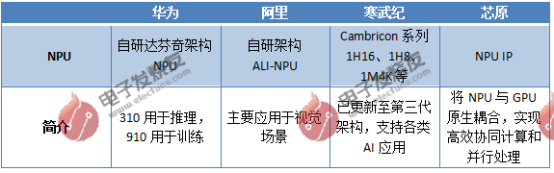

华为海思自研的Da Vinci架构昇腾NPU已经在移动端AI计算领域中崭露头角,张量化的立体运算单元提供了业界领先的量化精度,在移动端AI计算中用于图像识别、语音识别、AR SLAM等应用大幅提升了运算速度。

紫光展锐的NPU也在旗下多颗SoC中搭载,采用新一代高能效NPU+VDSP架构,垂直优化计算能力,其中NPU算力达到8TOPS,相比上一代提升67%,支持图像超分、视频增强、语义分割、目标检测、文本识别等AI应用。

阿里的含光NPU也是用了自研的硬件架构,集成了达摩院先进算法,针对CNN及视觉类算法深度优化计算、存储密度。国科微的NPU芯片同样自主自研,目前相关产品正在落地,今年会择机发布嵌入自研NPU、带算力的相关产品。

寒武纪的NPU也是国内很早进入NPU赛道的玩家,目前NPU产品主要包括寒武纪1A、寒武纪1H、寒武纪1M等,其IP指令集已扩大范围授权集成到手机、安防、可穿戴设备等各类终端芯片中,整体性能上与国外厂商比肩。

芯原股份的Vivante NPU IP也已经应用于百款人工智能芯片中,不仅可满足多种芯片尺寸和功耗预算还可以结合芯原自有的其他处理器IP。同时芯原还将自有的GPU和NPU原生耦合,利用芯原独有的FLEXA低功耗低延迟同步接口通信技术,实现二者的高效协同计算和并行处理。

还有不少国内厂商在NPU已有建树,如中星微的VC0616 NPU、OPPO的自研NPU MariSilicon X、瑞芯微的自研NPU、爱芯元智的Neutron NPU等等。

?

?

未来NPU如何发展?

NPU作为一种专门针对深度神经网络计算的硬件器件,随着深度学习技术的不断发展,越来越多的算法模型加入,NPU 的多样化肯定会越来越重要。目前NPU在图像识别、自然语言处理以及传感器数据处理上所展现出的强大计算性能,已经从IoT、消费电子领域开始向汽车自动驾驶领域等更广泛多样的场景延伸应用。

另一个发展趋势则是独立化,目前大多数NPU都需要与其他CPU/GPU等配合使用才能完成整个计算任务,对其他芯片的依赖度较高。未来NPU集成度进一步提高,能独立完成计算任务后其应用空间将更为广阔。

写在最后

NPU的诞生就是为了应对深度神经计算,在ChatGPT将算力需求再推上一个新台阶后,NPU芯片显著的能耗节约优势和高效的计算效率在算力需求愈发凸显的当下已经显露了不少发展机遇,在市场需求的推动下相关产业发展也开始加速。

和其他AI芯片相比,NPU依赖定制化,国内厂商在这一方面很有优势。在这个赛道上,可以预见竞争会越来越激烈,不过市场还没有被巨头垄断,国内厂商空间更大,可以争夺的生态位更多,国内厂商在这一细分AI芯片领域前景可期。

自OpenAI旗下的智能聊天机器人程序ChatGPT去年年末发布后,全球掀起了一波人工智能热潮,热度持续至今。ChatGPT超出人们预期的智能化表现掀起了人工智能领域的技术革命。这一场生成式人工智能热潮催生了海量的数据,处理海量的数据离不开背后庞大的基础算力作为支撑。

CPU、GPU和DPU作为人们熟知的人工智能场景中重要的算力芯片,能够为高带宽、低延迟、数据密集的计算场景提供计算引擎,是未来处理超算流量和安全网络存储的核心硬件。而神经网络处理器NPU作为一种专门用于进行深度学习计算的芯片,在大算力应用场景的应用优势也正被业界广泛看好。

NPU,为深度学习计算而生

早在2011年,Google就已经提出了利用大规模神经网络进行图像识别的技术,由于深度学习计算需要大量的计算资源和算力支持,此时传统的CPU和GPU并不能完全满足这种需求,因此NPU应运而生。

设计NPU的目的就是为了进行深度学习计算,其特点是具有极高的计算效率和能耗效率,能够运行多个并行线程在短时间内完成大规模的神经网络计算任务。NPU的计算单元通常采用矩阵计算、向量计算等方式以保证快速完成计算任务。

同时为了计算单元快速处理数据,其存储通常采用高速缓存和显存的结合方式,方便更快地存取和读取数据。这种设计在降低计算延迟和提高复杂计算任务稳定性有着很明显的帮助。

NPU和TPU、BPU这些AI芯片一样,同属于ASIC专用集成电路,是为特定应用场景(如NPU的神经网络和深度学习场景)而设计的定制芯片,其开发成本高且周期长,但在性能和功耗上优于同时期的GPU和FPGA。

传统的ASIC在开发完成后是不能更改的,这一点上NPU还是略有差异,NPU一般会具有一定的可编程性,可以通过更改配置适配不同的计算任务,所以其日后的应用空间也远不止局限于深度学习模型。

NPU这种专用芯片在特定的人工智能需求下提供了一种提升算力和能效比的新思路。虽然GPU已经针对AI算法加强了并行计算单元,但NPU更容易从高规律性的深度神经网络中获益,短时间内完成大规模的神经网络计算任务。

在ChatGPT拉高算力需求的背景推动下,NPU开始进入发展快车道。

大模型需求推动NPU产业发展

目前,国内人工智能芯片行业里GPU仍然是首选,根据IDC的数据,GPU占有90%以上的市场份额,而NPU、FPGA和其他ASIC等非GPU芯片占有的市场份额相对较少,整体市场份额接近10%,其中NPU的占比为6.3%。

在这条新赛道上,还没有哪一家厂商成为巨头主导市场,韩国政府与AI芯片、云计算企业联合发展高算力、低能耗的NPU也正是为了避开了英伟达主导的GPU市场,开辟一条新的增强AI芯片实力的道路。

今年4月已有韩媒BusinessKorea报道,三星半导体已成功量产采用三星14nm制程工艺第一代WarBoy NPU芯片,速度可以达到普通GPU的十倍,预计不久后投入市场,同时第二代WarBoy NPU芯片预计采用5nm工艺,明年或可推出。

国内NPU行业也是潜力十足,不同于CPU、GPU国内起步较慢,国内芯片设计公司在NPU这条赛道的起步时间不晚,已经有不少相关产品量产并推出应用。

华为海思自研的Da Vinci架构昇腾NPU已经在移动端AI计算领域中崭露头角,张量化的立体运算单元提供了业界领先的量化精度,在移动端AI计算中用于图像识别、语音识别、AR SLAM等应用大幅提升了运算速度。

紫光展锐的NPU也在旗下多颗SoC中搭载,采用新一代高能效NPU+VDSP架构,垂直优化计算能力,其中NPU算力达到8TOPS,相比上一代提升67%,支持图像超分、视频增强、语义分割、目标检测、文本识别等AI应用。

阿里的含光NPU也是用了自研的硬件架构,集成了达摩院先进算法,针对CNN及视觉类算法深度优化计算、存储密度。国科微的NPU芯片同样自主自研,目前相关产品正在落地,今年会择机发布嵌入自研NPU、带算力的相关产品。

寒武纪的NPU也是国内很早进入NPU赛道的玩家,目前NPU产品主要包括寒武纪1A、寒武纪1H、寒武纪1M等,其IP指令集已扩大范围授权集成到手机、安防、可穿戴设备等各类终端芯片中,整体性能上与国外厂商比肩。

芯原股份的Vivante NPU IP也已经应用于百款人工智能芯片中,不仅可满足多种芯片尺寸和功耗预算还可以结合芯原自有的其他处理器IP。同时芯原还将自有的GPU和NPU原生耦合,利用芯原独有的FLEXA低功耗低延迟同步接口通信技术,实现二者的高效协同计算和并行处理。

还有不少国内厂商在NPU已有建树,如中星微的VC0616 NPU、OPPO的自研NPU MariSilicon X、瑞芯微的自研NPU、爱芯元智的Neutron NPU等等。

?

?未来NPU如何发展?

NPU作为一种专门针对深度神经网络计算的硬件器件,随着深度学习技术的不断发展,越来越多的算法模型加入,NPU 的多样化肯定会越来越重要。目前NPU在图像识别、自然语言处理以及传感器数据处理上所展现出的强大计算性能,已经从IoT、消费电子领域开始向汽车自动驾驶领域等更广泛多样的场景延伸应用。

另一个发展趋势则是独立化,目前大多数NPU都需要与其他CPU/GPU等配合使用才能完成整个计算任务,对其他芯片的依赖度较高。未来NPU集成度进一步提高,能独立完成计算任务后其应用空间将更为广阔。

写在最后

NPU的诞生就是为了应对深度神经计算,在ChatGPT将算力需求再推上一个新台阶后,NPU芯片显著的能耗节约优势和高效的计算效率在算力需求愈发凸显的当下已经显露了不少发展机遇,在市场需求的推动下相关产业发展也开始加速。

和其他AI芯片相比,NPU依赖定制化,国内厂商在这一方面很有优势。在这个赛道上,可以预见竞争会越来越激烈,不过市场还没有被巨头垄断,国内厂商空间更大,可以争夺的生态位更多,国内厂商在这一细分AI芯片领域前景可期。

声明:本文内容及配图由入驻作者撰写或者入驻合作网站授权转载。文章观点仅代表作者本人,不代表电子发烧友网立场。文章及其配图仅供工程师学习之用,如有内容侵权或者其他违规问题,请联系本站处理。

举报投诉

-

AI

+关注

关注

88文章

35765浏览量

282558 -

NPU

+关注

关注

2文章

335浏览量

19935

发布评论请先 登录

相关推荐

热点推荐

芯原超低能耗NPU可为移动端大语言模型推理提供超40 TOPS算力

芯原股份今日宣布其超低能耗且高性能的神经网络处理器(NPU)IP现已支持在移动端进行大语言模型(LLM)推理,AI

6TOPS算力NPU加持!RK3588如何重塑8K显示的边缘计算新边界

与复杂运算。明远智睿推出的RK3588芯片,以6TOPS算力的NPU为核心,为这一难题提供了突破性的解决方案。 从硬件架构来看,RK3588的NPU

发表于 04-18 15:32

【「芯片通识课:一本书读懂芯片技术」阅读体验】从deepseek看今天芯片发展

的:

神经网络处理器(NPU)是一种模仿人脑神经网络的电路系统,是实现人工智能中神经网络计算的专用处理

发表于 04-02 17:25

英国政府计划大幅提升AI算力

近日,英国首相斯塔默宣布了一项雄心勃勃的计划,承诺到2030年,英国政府将采购多达10万块图形处理器(GPU),以大幅提升英国的AI算力水平

人工神经网络的原理和多种神经网络架构方法

在上一篇文章中,我们介绍了传统机器学习的基础知识和多种算法。在本文中,我们会介绍人工神经网络的原理和多种神经网络架构方法,供各位老师选择。 01 人工神经网络 ? 人工神经网络

卷积神经网络与传统神经网络的比较

在深度学习领域,神经网络模型被广泛应用于各种任务,如图像识别、自然语言处理和游戏智能等。其中,卷积神经网络(CNNs)和传统神经网络是两种常

RNN模型与传统神经网络的区别

神经网络是机器学习领域中的一种强大工具,它们能够模拟人脑处理信息的方式。随着技术的发展,神经网络的类型也在不断增加,其中循环神经网络(RNN

NPU的市场前景与发展趋势

随着人工智能技术的快速发展,神经网络处理器(Neural Processing Unit,简称NPU)作为AI领域的关键硬件,其市场前景和

【「算力芯片 | 高性能 CPU/GPU/NPU 微架构分析」阅读体验】--全书概览

、GPU、NPU,给我们剖析了算力芯片的微架构。书中有对芯片方案商处理器的讲解,理论联系实际,使

发表于 10-15 22:08

名单公布!【书籍评测活动NO.43】 算力芯片 | 高性能 CPU/GPU/NPU 微架构分析

力,在全球范围内,对于推动科技进步、经济发展及社会整体的运作具有至关重要的作用。随着信息技术的高速发展,高性能计算(HPC)和人工智能(AI

发表于 09-02 10:09

韩国政企组团研发NPU,大模型算力需求推动中国AI神经网络处理芯片发展

韩国政企组团研发NPU,大模型算力需求推动中国AI神经网络处理芯片发展

评论