5月31日(当地时间),openai宣布其开始对抗人工智能的“错觉”,并采用新的方法来训练人工智能模型。

据说,如果open ai开发的chatgpt和谷歌开发的bard等模型完全捏造信息,就像罗列事实一样,显示ai的“幻觉(hallucination)”。例如,在谷歌今年2月公开的bard宣传视频中,聊天机器人对詹姆斯-韦伯太空望远镜进行了虚假说明。chatgpt最近在纽约联邦法院写了一份引用虚假案件的文件,涉及此案的纽约律师可能会受到处罚。

目前,openai提出了一种新的方法——来缓解chatgpt中的“幻觉”,并让激情变得更好,这是通过“过程监督”来提高大ai模型的数学推理能力。

openai研究组在报告书中表示:“最先进的模型也可能生成虚假信息——,有在不确定的瞬间捏造事实的倾向。”“这种幻想在需要多个层次推论的领域尤其有问题,因为逻辑错误可能会破坏更大的解决方案。”

openai对抗ai“幻觉”的新战略不是单纯地因为正确答案而给予补偿,而是因为猜对正确的推理过程而给予补偿。据研究者称,这种方法被称为“过程监测”,而不是“结果监测”。

这一策略也可能会导致更具描述性的人工智能,因为它鼓励模型更多地遵循人类“思想”之类的方法链。除了结果监控以外,过程监控也有助于解决排序问题。

openai的研究人员还不知道这些结果是否适用于数学以外的领域,但他们认为在其他领域探索“过程监督”的影响也很重要。

-

模型

+关注

关注

1文章

3547浏览量

50742 -

聊天机器人

+关注

关注

0文章

348浏览量

12848 -

OpenAI

+关注

关注

9文章

1220浏览量

9105

发布评论请先 登录

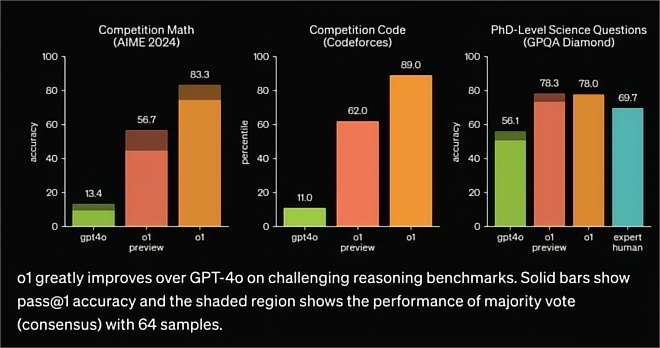

OpenAI发布o1大模型,数理化水平比肩人类博士,国产云端推理芯片的新蓝海?

芯片制造中高精度膜厚测量与校准:基于红外干涉技术的新方法

无刷直流电机反电势过零检测新方法

今日看点丨OpenAI将发布新的GPT-4.5模型;三星西安工厂将升级286层NAND闪存工艺

OpenAI即将推出GPT-5模型

大华股份荣获中国创新方法大赛一等奖

微软寻求在365 Copilot中引入非OpenAI模型

OpenAI暂不推出Sora视频生成模型API

基于遗传算法的QD-SOA设计新方法

一种降低VIO/VSLAM系统漂移的新方法

OpenAI称找到新方法减轻大模型“幻觉”

OpenAI称找到新方法减轻大模型“幻觉”

评论