OpenAI GPT 技术的聊天机器人,其拥有 3000 亿单词的语料基础,预训练出拥有 1750 亿个参数的模型,海量的参数与强大的智能交互能力离不开背后算力和服务器的支撑。据我们测算,若未来 ChatGPT 达到 10 亿日活,每人平均 10000字左右问题,则需新增服务器投入 46.30 万台。服务器的需求起量为上游的存储/PCB/模拟市场带来新增量。我们预计,单台服务器带来的 PCB 价值量约为 4000元,而 AI 服务器放量亦将带来 DDR5 和 HBM 存储用量的快速提升。

01

ChatGPT:引领内容生成式 AI 行业变革

此前微软宣布将在未来向 OpenAI 投资 100 亿美元,并将 ChatGPT 的技术整合到最新版本的必应搜索引擎和 Edge 浏览器中。微软这一举动拉开了大型科技公司 AI 竞赛的序幕,谷歌亦宣布推出 Bard 对抗 ChatGPT,国内百度、腾讯等科技巨头亦在加紧推出自己的生成式 AI

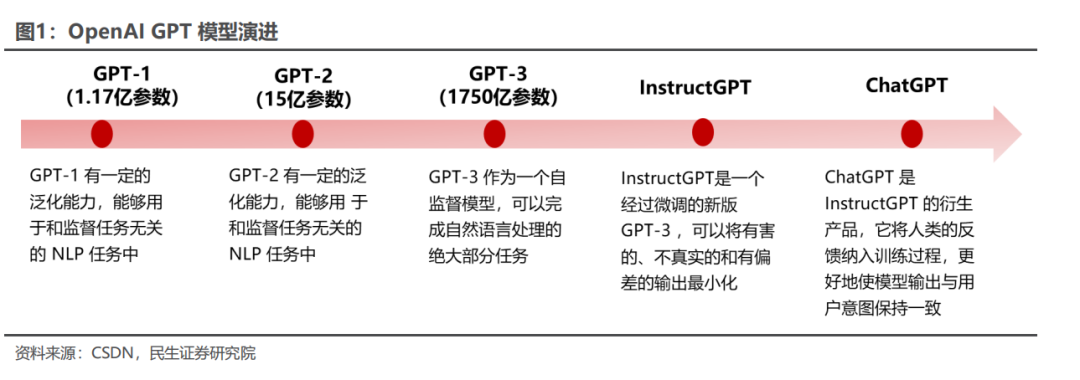

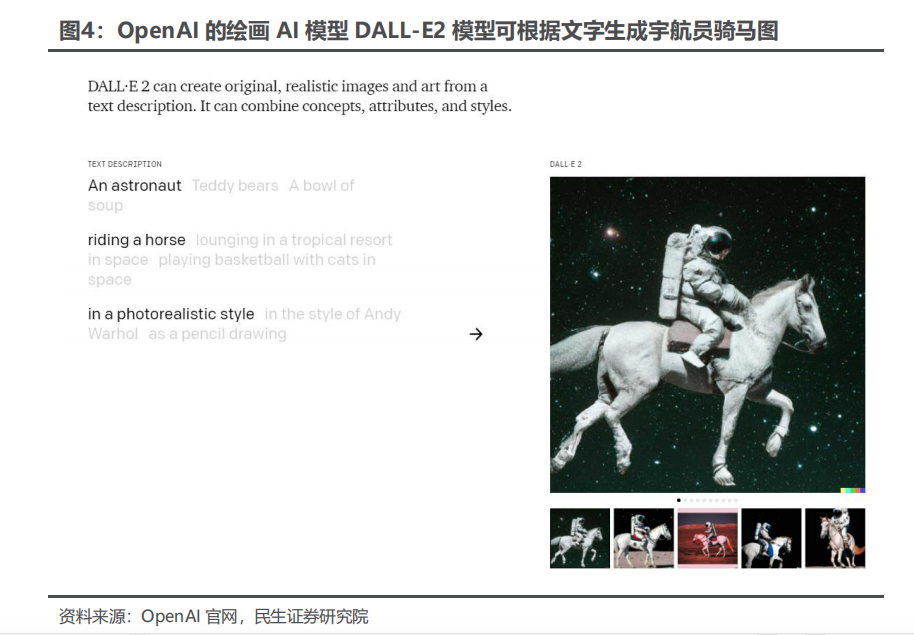

从 2018 年 OpenAI 开发出 GPT-1 开始,GPT 模型的智能化程度不断提升,ChatGPT 是从 GPT3.5 系列中的模型进行微调而诞生的,此前 OpenAI 还设计了GPT-1、GPT-2 和 GPT-3 模型。相比于前几代 GPT 模型,ChatGPT 具有类似人类的情境感知和回馈能力,在语言识别、判断和交互层面实现了较好的效果。除此之外,OpenAI 旗下还有可生成图片内容的 AI 应用 Dall-E,高智能化的内容生成式 AI 有望在未来一段时间内改变人类科技发展的格局,让智能化广泛进入人们的日常生活。

ChatGPT 为人类开拓出了训练大语言模型的新道路。ChatGPT 在拥有 3000亿单词的语料基础上预训练出拥有 1750 亿个参数的模型(GPT-2 仅有 15 亿参数),预训练数据量从 5GB 增加到 45TB。ChatGPT 证明了在高算力的支持下,千亿级参数规模的模型训练+人类反馈,可以使 AI 融合世界的知识和规则,极大提升模型表现。

02

ChatGPT 拉动算力需求快速增长

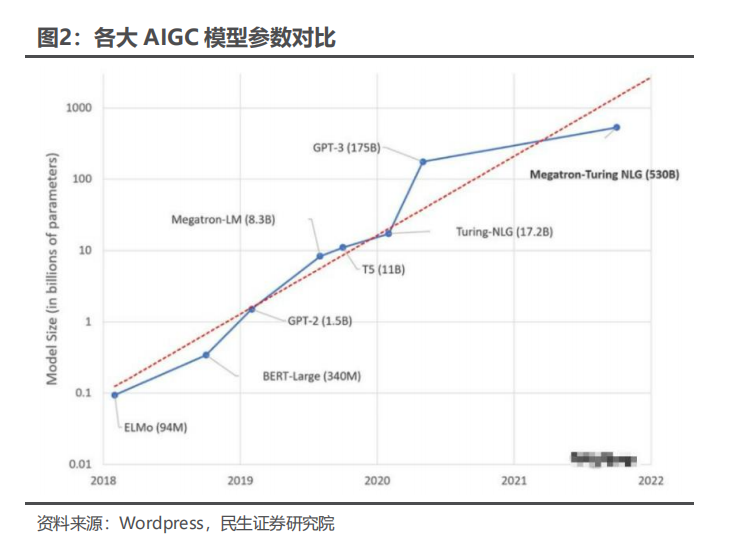

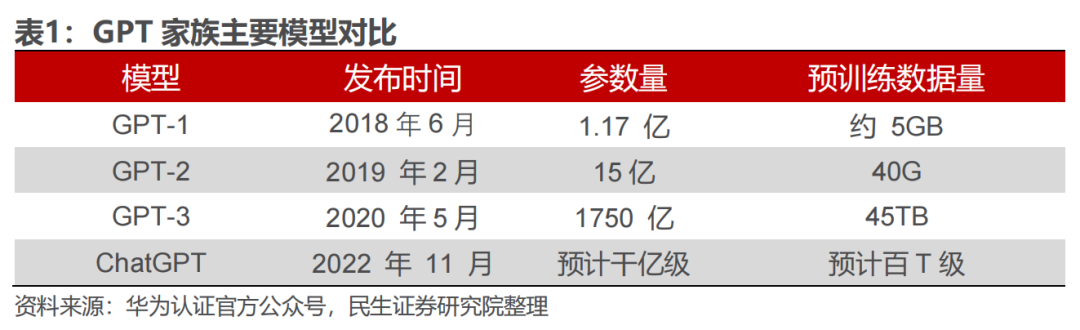

ChatGPT 参数量、数据量高度扩张,算力需求剧增。从 2018 年起,OpenAI就开始发布生成式预训练语言模型 GPT(Generative Pre-trained Transformer),可用于生成文章、代码、机器翻译、问答等各类内容,每一代 GPT 模型的参数量都快速增长:2019 年 2 月发布的 GPT-2 参数量为 15 亿,而 2020 年 5 月的 GPT-3,参数量达到了 1750 亿。

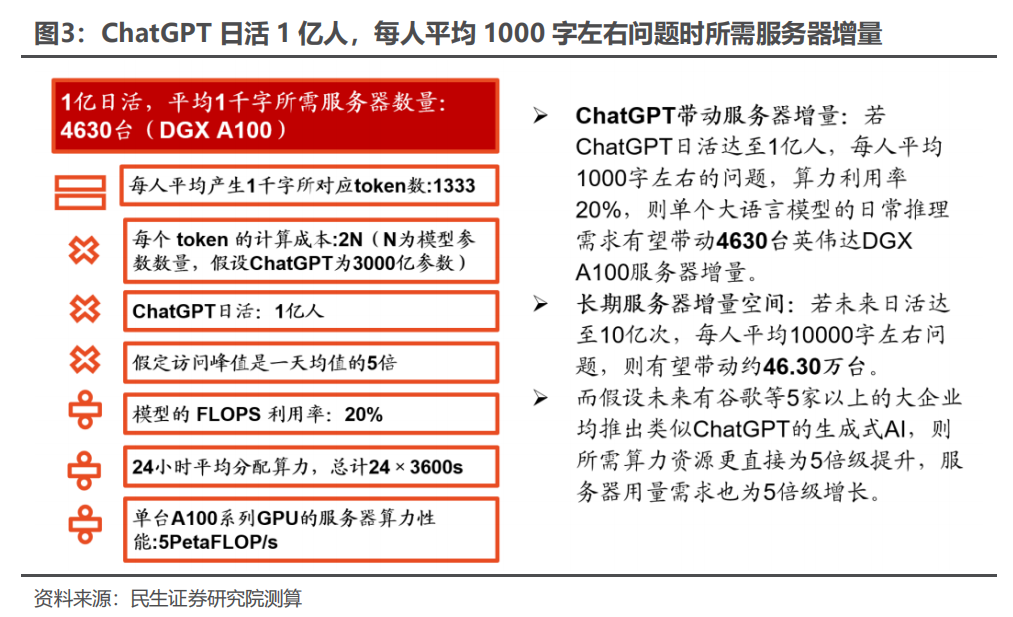

ChatGPT 海量的参数与强大的智能交互能力,离不开算力的支撑。根据Similarweb 的数据,23 年 1 月份 ChatGPT 日活约 1300 万人,累计用户已超 1亿人,创下了互联网最快破亿应用的记录。若 ChatGPT 日活达至 1 亿人,每人平均 1000 字左右的问题,那么需要多大的算力资源支持?

我们建立计算假设如下:

1) 假设均采用英伟达 DGX A100 服务器:该服务器单机搭载 8 片 A100GPU,AI 算力性能约为 5 PetaFLOP/s,单机最大功率约为 6.5kw;

2) ChatGPT 日活达至 1 亿人,每人平均 1000 字左右问题;

3) 自回归语言模型以 token 作为单位进行数据处理和计算,在英文环境下,一般 750 个单词等于 1000 个 token。最常见的 Transformer 类语言模型在推理过程中每个 token 的计算成本(以 FLOPs 为指标)约为 2N,其中 N 为模型参数数量(20 年发布的 GPT-3 拥有 1750 亿参数,22 年谷歌发布的 PaLM 拥有 5400 亿参数,假定 ChatGPT 为 3000 亿参数);

4) 模型的 FLOPs 利用率为 20%;

5) 假定访问峰值是一天均值的 5 倍;

若 ChatGPT 日活达至 1 亿人,每人平均 1000 字左右的问题,初始服务器投入需 4630 台。粗略估计 ChatGPT 1000 字左右的问题需要的算力资源为2*3000 亿*1000*1.333/20%=4PetaFLOP,而 ChatGPT 日活约 1 亿人,若每人平均 1000 字左右的问题,假设 24 小时平均分配任务,则所需算力为 1 亿*4PetaFLOP/(24*3600s)=4630PetaFLOP/ s。考虑访问流量存在峰值,假定访问峰值是一天均值的 5 倍,而单台英伟达 DGXA100 系列服务器算力为 5 PetaFLOP/s,则需要对应服务器数量为 4630PetaFLOP/s*5/ PetaFLOP/s=4630 台。

而若未来 ChatGPT 日活达至 10 亿人,每人平均 10000 字左右问题,则有望带动约 46.30 万台。

且考虑谷歌每日搜索量已达 35 亿次,长期来看 ChatGPT 日活有广阔的提升空间,算力需求将持续释放。此外,若考虑 ChatGPT 嵌入终端应用后,其对算力资源的消耗量或将成数倍级增长,所需服务器数量需求更是成数倍级提升。

文字交互仅是大模型用量的起点,未来图像、视频等多种形态带动算力需求大幅提升。ChatGPT 目前仍主要停留在文字交互层面,但图像、视频等领域也可使用 Transformer 大模型,所需算力规模远大于文字交互。例如 OpenAI 的绘画 AI模型 DALL-E2,其可直接根据文字生成逼真的图像,也可以对现有图像上根据文字指令创建新作品。

03

上游存储/PCB/模拟受益 ChatGPT 需求新增量

ChatGPT 拉动服务器需求快速增长的同时,将直接拉动算力芯片需求增长,我们于下文中详细对算力芯片需求进行了介绍。此外,服务器需求的增长,也将带动上游存储/PCB/模拟的需求快速增长。

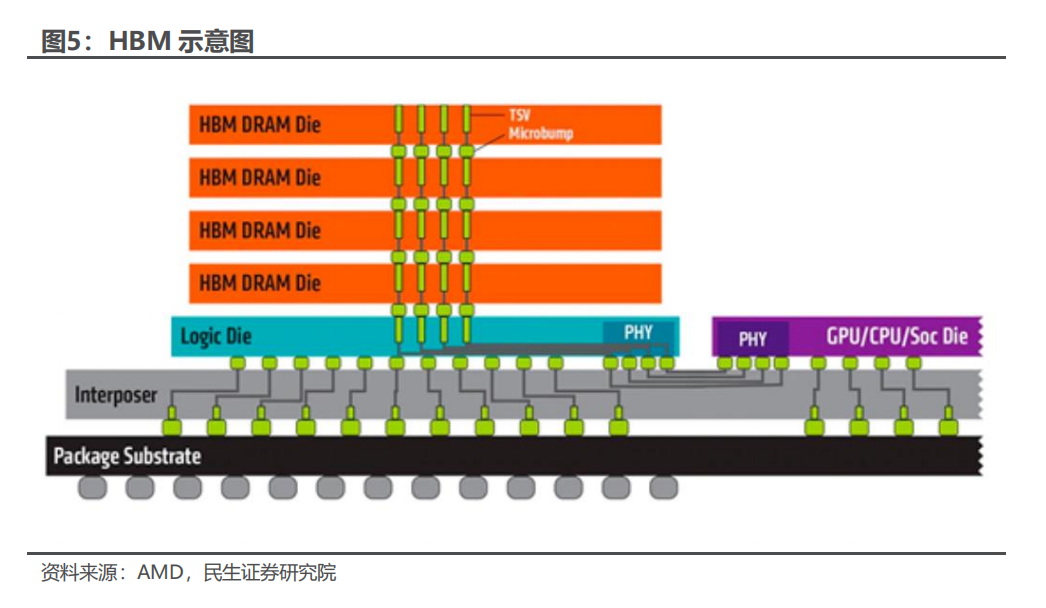

1)ChatGPT 新时代,服务器需求带动 DDR5 和 HBM 用量快速提升。随着ChatGPT 等应用开启 AI 新时代,全球数据生成、储存、处理量有望呈等比级数增长,而 DDR5 内存和高带宽存储器(HBM)可支持更高速率的带宽。对于计算-内存而言,DDR5 标准的最高速率是 DDR4 的两倍,而 HBM 基于 TSV 和芯片堆叠技术的堆叠 DRAM 架构,可实现高于 256GBps 的突破性带宽。深度学习和人工智能的快速发展对数据运算的要求越来越高,随着数据指数式增长,内存墙对于计算速度的影响越来越凸显,而 DDR5 和 HBM 技术可以帮助数据中心突破“内存墙”瓶颈。我们看好在 ChatGPT 的带动下,服务器 DDR5 和 HBM 的渗透率有望加速提升

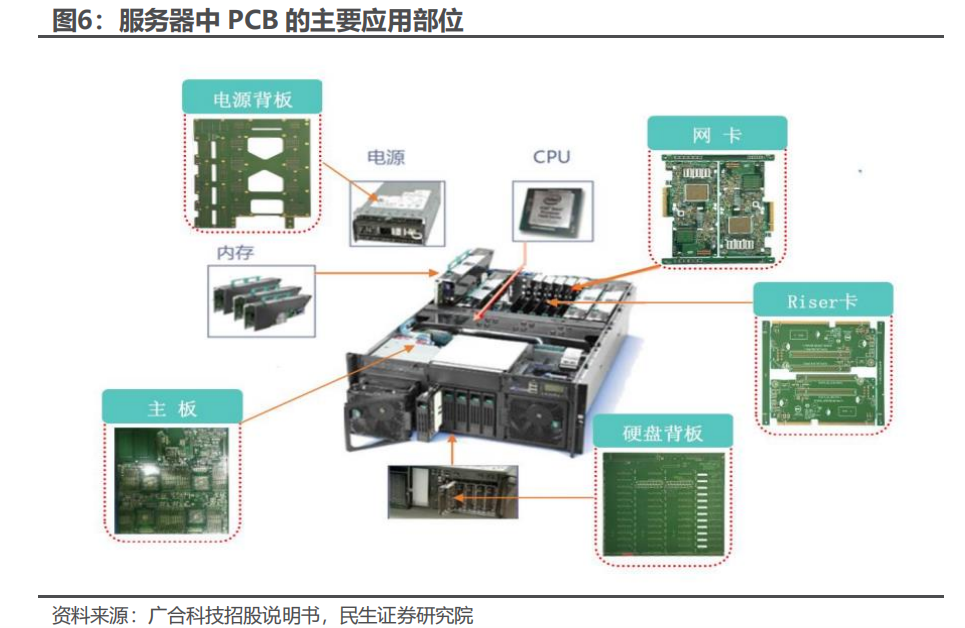

2) ChatGPT 带动 PCB 需求新增量。服务器内部涉及 PCB 的主要部件包括主板、电源背板、网卡、Riser 卡、硬盘背板等,PCB 在 AI 服务器应用中对板厚、层数、工艺等有着更高的要求,具有高层数、高密度及高传输速率的特点。

PCB 层数越多,设计越灵活,能够对电路起到更好地抗阻作用,更易于实现芯片之间地高速传输,单位价值量也越高。PCIe3.0 接口的信号传输速率为 8GT/s,对应的服务器 PCB 板为 8-10 层;PCIe4.0 接口的传输速率为 16GT/s,使用的服务器 PCB 层数为 12-14 层,目前渗透率在快速提高,如英伟达 DGXA100 系列服务器就采用了 PCIe4.0 接口;服务器平台下一步将升级到 PCIe 5.0,传输速率为32GT/s,PCB 的层数可达 18 层。随着 ChatGPT 对算力要求的提升,预计服务器PCB 将呈量价齐升的态势,保守估计每台服务器的 PCB 价值量可达 4000 元。

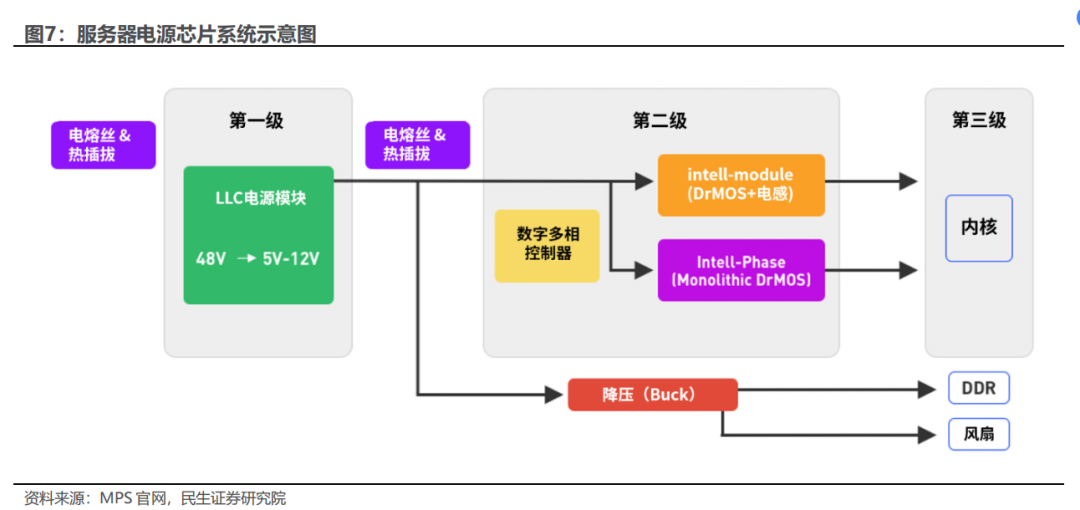

3)ChatGPT 拉动服务器建设的同时,亦带来大量电源管理芯片需求。从市电输入服务器开始,到电流输入 CPU 等元器件止,大体上需要经过三次电流的改变。第一次是经过服务器的电源模块,将市电从交流电转换成 48V 的直流电(ACDC)。接下来,该直流电会被输送至 DC/DC 变换器,进一步被转换成 12V,提供给中间母线结构(IBA)。最后该 12V 母线电压将被分配至板上多个负载点(PoL)变换器中,为芯片或子电路提供电源。不过由于主板上 CPU 等内核器件与风扇等

其他器件对功率的要求各不相同,因此需要分开处理。对于 CPU 等内核器件,往往需要使用多相电源供电,而对于部分功率较小且比较稳定的其他器件,不需要使

用多相电源,只需要使用 Buck 进行降压就可以对其进行供电。具体而言,主板上的电源管理 IC 主要包括 eFuse/热插拔、多相电源、LDO 与降压 Buck 等四类。

审核编辑 :李倩

-

服务器

+关注

关注

13文章

9829浏览量

88245 -

ai技术

+关注

关注

1文章

1308浏览量

25227 -

OpenAI

+关注

关注

9文章

1211浏览量

9006 -

ChatGPT

+关注

关注

29文章

1590浏览量

9184

原文标题:ChatGPT 引领 AI 技术变革,带动服务器需求增量

文章出处:【微信号:S3ITIA-,微信公众号:安防监控存储联盟】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

GPU猛兽袭来!HBM4、AI服务器彻底引爆!

从12kW到800V,AI服务器电源架构变革下,功率器件如何解题?

CES Asia 2025蓄势待发,聚焦低空经济与AI,引领未来产业新变革

AI 服务器电源如何迭代升级?

总功率超198kW,AI服务器电源对元器件提出了哪些要求?

泰克科技解析AI服务器电源架构的技术演进

ChatGPT引领AI技术变革,带动服务器需求增量

ChatGPT引领AI技术变革,带动服务器需求增量

评论