今日,腾讯正式发布新一代混元开源大语言模型。英特尔凭借在人工智能领域的全栈技术布局,现已在英特尔? 酷睿? Ultra 平台上完成针对该模型的第零日(Day 0)部署与性能优化。值得一提的是, 依托于OpenVINO? 构建的 AI 软件平台的可扩展性,英特尔助力ISV生态伙伴率先实现应用端Day 0 模型适配,大幅加速了新模型的落地进程,彰显了 “硬件 + 模型 + 生态” 协同的强大爆发力。

混元新模型登场:多维度突破,酷睿Ultra平台Day0适配

腾讯混元宣布开源四款小尺寸模型,参数分别为 0.5B、1.8B、4B、7B,消费级显卡即可运行,适用于笔记本电脑、手机、智能座舱、智能家居等低功耗场景。新开源的4 个模型均属于融合推理模型,具备推理速度快、性价比高的特点,用户可根据使用场景灵活选择模型思考模式——快思考模式提供简洁、高效的输出;而慢思考涉及解决复杂问题,具备更全面的推理步骤。

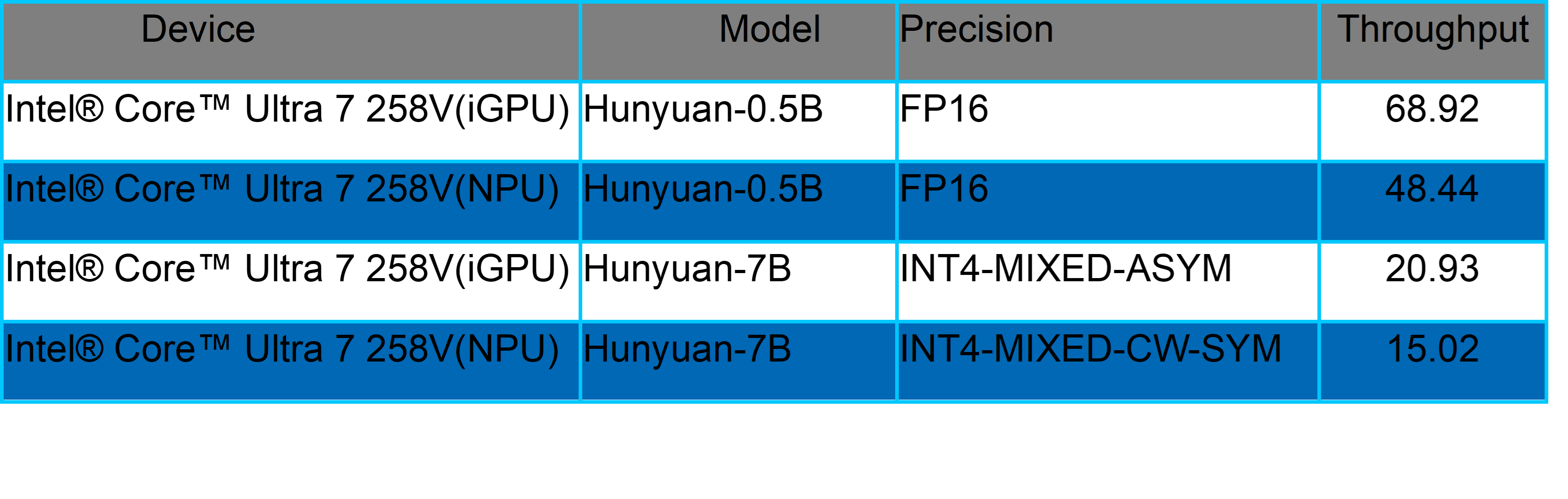

这些模型已在英特尔酷睿 Ultra 平台实现全面适配,其在 CPU、GPU、NPU 三大 AI 运算引擎上都展现了卓越的推理性能表现1。以酷睿 Ultra 2 代 iGPU 平台为例,7B 参数量模型在 INT4 精度下,吞吐量达 20.93token/s;0.5B 小尺寸模型在 FP16 精度下吞吐量达 68.92token/s。值得一提的是,英特尔对新模型的 NPU 第零日支持已形成常态化能力,为不同参数量模型匹配精准硬件方案,满足从个人终端到边缘设备的多样化需求。

OpenVINO:新模型快速落地的“关键引擎”

作为英特尔推出的开源深度学习工具套件,OpenVINO 以 “性能优化 + 跨平台部署” 为核心优势,可充分释放英特尔硬件资源潜力,广泛应用于 AI PC、边缘 AI 等场景。其核心价值在于能将深度学习模型的推理性能最大化,同时实现跨 CPU、GPU、NPU 等异构硬件的无缝部署。

目前,OpenVINO已支持超过 900 个人工智能模型,涵盖生成式 AI 领域主流模型结构与算子库。这样的模型支持体系,使其能在新模型发布的Day 0,即完成英特尔硬件平台的适配部署。此次混元模型的快速落地,正是 OpenVINO 技术实力的直接体现 —— 通过其优化能力,混元模型在酷睿 Ultra 平台的性能得到充分释放,为用户带来即发即用的 AI 体验。

生态共创:AI技术到应用的“最后一公里”加速

生态合作是英特尔 AI 战略的核心支柱,驱动人生作为其长期合作伙伴,专注于互联网客户端软件研发及运营,本着“以用户为中心,以技术为根本,以开放为原则”的理念,长期致力于技术研发和技术创新,为用户提供优质的服务。其 AIGC 助手软件,实现本地部署,离线使用,支持文字输入、语音转译,将大模型装进背包,可随时随地与它进行智能对话,还能让它帮忙解读文档,编撰方案。

该应用采用 OpenVINO推理框架,借助其快速适配能力,在混元模型发布当日即完成应用层适配,成为首批支持新模型的应用之一。

目前,驱动人生 AIGC 助手、英特尔AIPC应用专区和多家OEM 应用商店的 AI PC专区均已上线,搭载混元模型的新版本也将在近期推出,用户可第一时间体验更智能的交互与服务。这种 “模型发布 - 硬件适配 - 应用落地” 的全链条第零日响应,正是英特尔生态协同能力的生动写照。

AI 的发展离不开模型创新与软硬件生态协同 —— 模型如同燃料,生态则是驱动前进的引擎。英特尔通过硬件平台、软件工具与生态网络的深度协同,实现对新模型的第零日适配,不仅加速了技术到应用的转化,更推动着整个 AI 产业的高效创新。未来,英特尔将持续深化与合作伙伴的协同,让 AI 创新更快走进千行百业与大众生活。

快速上手指南

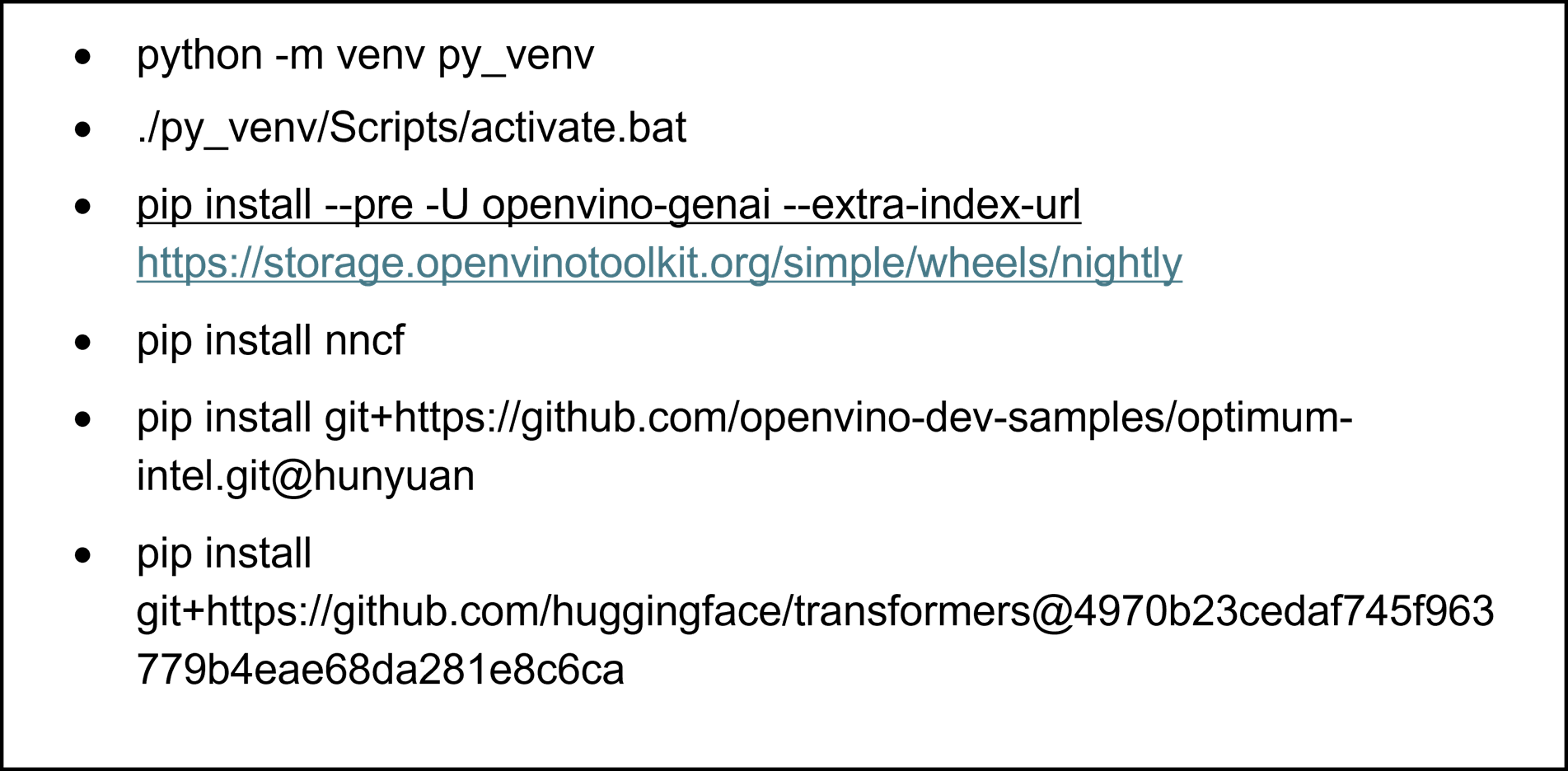

第一步,环境准备

通过以下命令可以搭建基于Python的模型部署环境。

该示例在以下环境中已得到验证:

硬件环境:

Intel? Core? Ultra 7 258V

iGPU Driver:32.0.101.6972

NPU Driver:32.0.100.4181

Memory: 32GB

操作系统:

Windows 11 24H2 (26100.4061)

OpenVINO版本:

openvino 2025.2.0

openvino-genai 2025.2.0.0

openvino-tokenizers 2025.2.0.0

Transformers版本:

https://github.com/huggingface/transformers@4970b23cedaf745f963779b4eae68da281e8c6ca

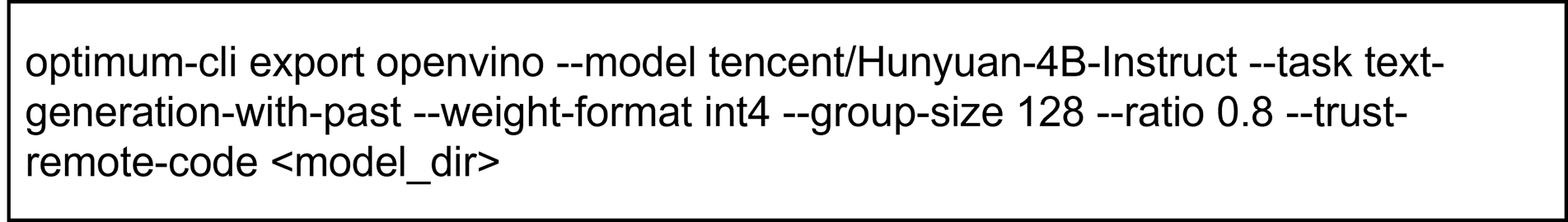

第二步,模型下载和转换

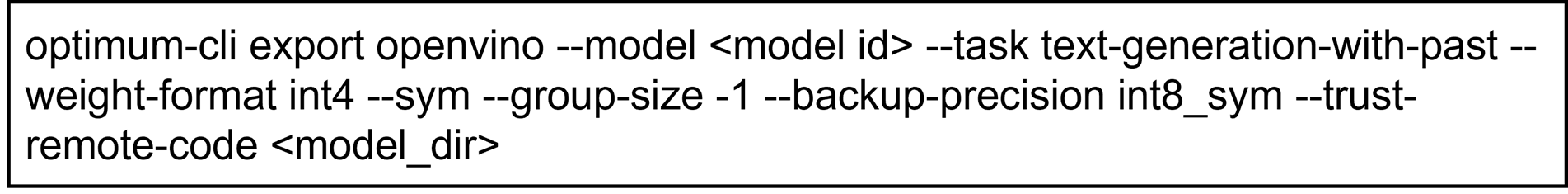

在部署模型之前,我们首先需要将原始的PyTorch模型转换为OpenVINOTM的IR静态图格式,并对其进行压缩,以实现更轻量化的部署和最佳的性能表现。通过Optimum提供的命令行工具optimum-cli,我们可以一键完成模型的格式转换和权重量化任务:

开发者可以根据模型的输出结果,调整其中的量化参数,包括:

--model:为模型在HuggingFace上的model id,这里我们也提前下载原始模型,并将model id替换为原始模型的本地路径,针对国内开发者,推荐使用ModelScope魔搭社区作为原始模型的下载渠道,具体加载方式可以参考ModelScope官方指南:https://www.modelscope.cn/docs/models/download

--weight-format:量化精度,可以选择fp32,fp16,int8,int4,int4_sym_g128,int4_asym_g128,int4_sym_g64,int4_asym_g64

--group-size:权重里共享量化参数的通道数量

--ratio:int4/int8权重比例,默认为1.0,0.6表示60%的权重以int4表,40%以int8表示

--sym:是否开启对称量化

此外我们建议使用以下参数对运行在NPU上的模型进行量化,以达到性能和精度的平衡。

这里的--backup-precision是指混合量化精度中,8bit参数的量化策略。

第三步,模型部署

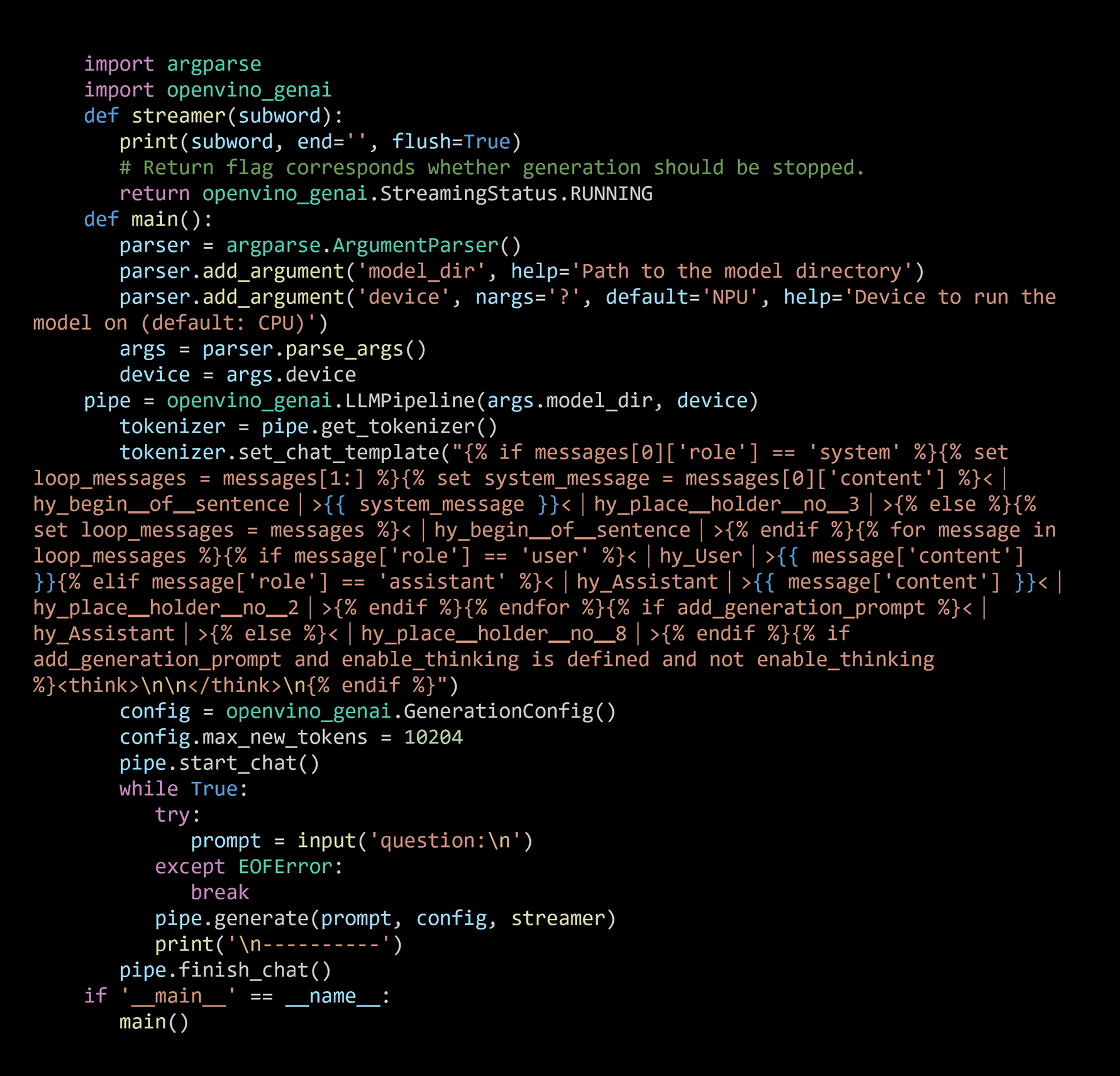

目前我们推荐是用openvino-genai来部署大语言以及生成式AI任务,它同时支持Python和C++两种编程语言,安装容量不到200MB,支持流式输出以及多种采样策略。

GenAI API部署示例

其中,'model_dir'为OpenVINOTM IR格式的模型文件夹路径,'device'为模型部署设备,支持CPU,GPU以及NPU。此外,openvino-genai提供了chat模式的构建方法,通过声明pipe.start_chat()以及pipe.finish_chat(),多轮聊天中的历史数据将被以kvcache的形态,在内存中进行管理,从而提升运行效率。

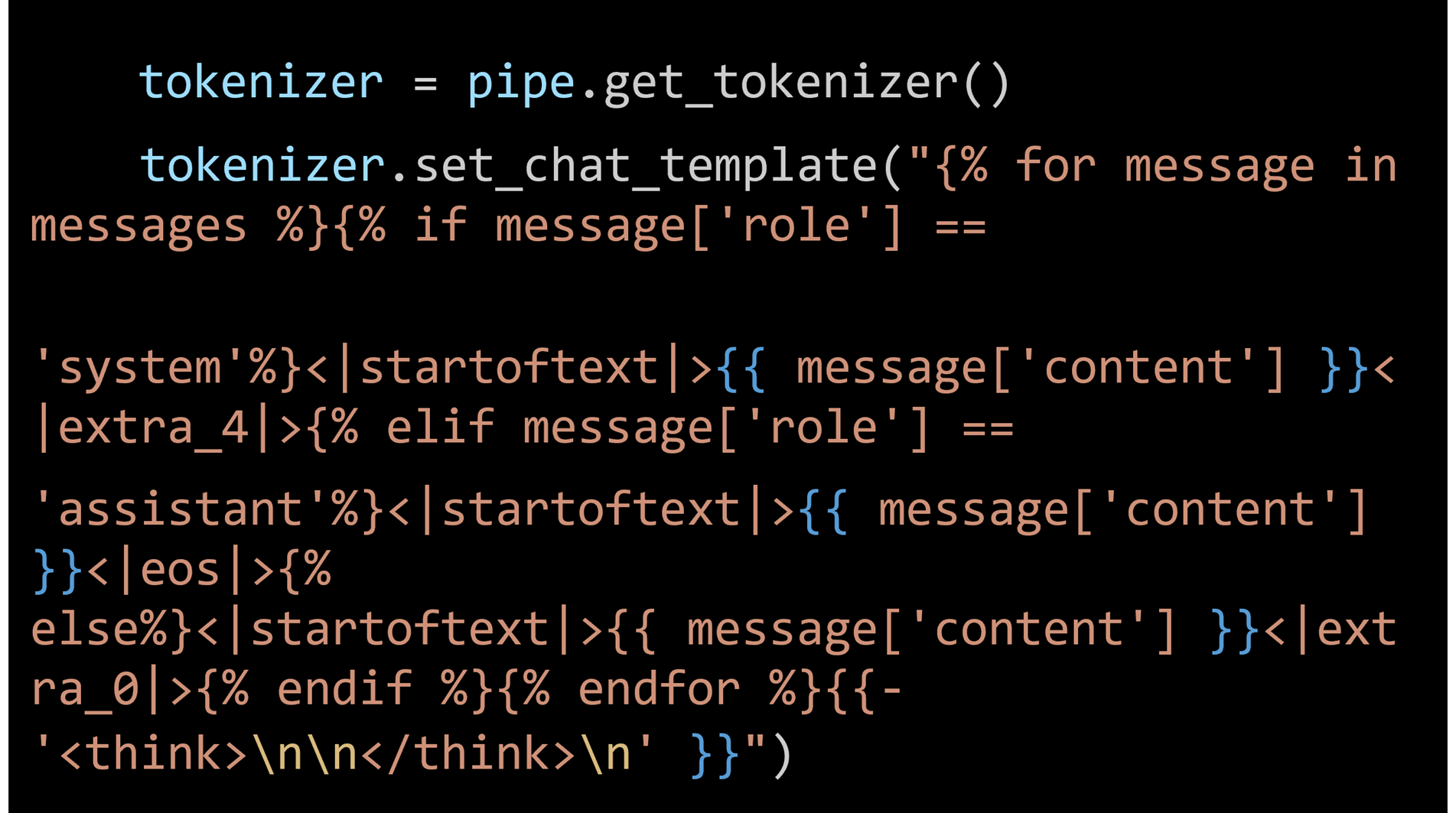

开发者可以通过该该示例的中方法调整chat template,以关闭和开启thinking模式,具体方式可以参考官方文档(https://huggingface.co/tencent/Hunyuan-4B-Instruct)。由于目前OpenVINOTM Tokenizer还没有完全支持Hunyuan-7B-Instruct模型默认的chat template格式,因此我们需要手动替换原始的chat template,对其进行简化,具体方法如下:

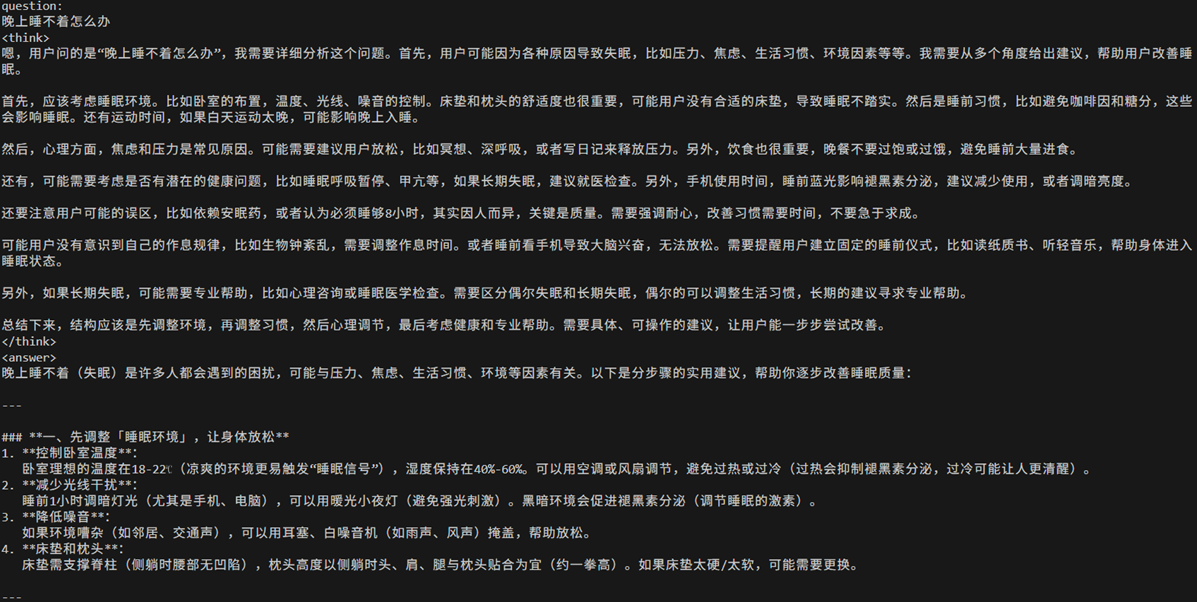

chat模式输出结果示例:

关于该示例的后续更新,可以关注OpenVINO notebooks仓库:https://github.com/openvinotoolkit/openvino_notebooks/tree/latest/notebooks/llm-chatbot

驱动人生应用获取方式:

驱动人生 AIGC 助手(https://www.160.com/aigc/index.html)

英特尔AIPC应用专区(intel.cn/aipc)

1.通过使用 OpenVINO 框架版本 2025.2.0 在 英特尔? 酷睿? Ultra 7 258V 和 英特尔? 酷睿? Ultra 9 285H 上进行测试获得了性能数据,计算过程发生在 iGPU 或 NPU 上。测试评估了首 Token 的延迟以及在 int4-mixed、int4-mixed-cw-sym 和 fp16 精度设置下 1K 输入的平均吞吐量。每项测试在预热阶段后执行三次,并选择平均值作为报告数据。

性能因使用方式、配置和其他因素而异。请访问www.Intel.com/PerformanceIndex了解更多信息。

性能结果基于测试时的配置状态,可能未反映所有公开可用的更新内容。请参阅相关文档以获取配置详情。没有任何产品或组件能够保证绝对安全。

您的实际成本和结果可能会有所不同。

相关英特尔技术可能需要启用相关硬件、软件或激活服务。

审核编辑 黄宇

-

英特尔

+关注

关注

61文章

10210浏览量

175335 -

人工智能

+关注

关注

1810文章

49193浏览量

251173 -

大模型

+关注

关注

2文章

3212浏览量

4195

发布评论请先 登录

摩尔线程率先支持腾讯混元-A13B模型

请问OpenVINO?工具套件英特尔?Distribution是否与Windows? 10物联网企业版兼容?

腾讯元宝升级:深度思考模型“腾讯混元T1”全量上线

腾讯混元大模型开源成绩斐然,GitHub Star数近1.4万

腾讯混元文生图登顶智源FlagEval评测榜首

刚刚!英特尔最新回应

英特尔携手腾讯以技术创新,共驭智算未来新机

硬件与应用同频共振,英特尔Day 0适配腾讯开源混元大模型

硬件与应用同频共振,英特尔Day 0适配腾讯开源混元大模型

评论