电子发烧友网综合报道,据韩媒报道,下一代低功耗内存模块 “SOCAMM” 市场已全面拉开帷幕。英伟达作为 AI 领域的领军企业,计划在今年为其 AI产品部署60至80万个 SOCAMM 内存模块,不仅将用于数据中心AI服务器,也将有望应用于PC。这一举措将对内存市场以及相关产业链产生深远影响。

SOCAMM

SOCAMM 全称为 Small Outline Compression Attached Memory Module,即小型化压缩附加内存模组,是英伟达主导开发的一种新型内存模块,是适用于数据中心 AI 服务器的新型高性能、低功耗内存。

它将低功耗 DRAM 与压缩连接内存模块(CAMM)搭配使用,以全新的外形尺寸提供卓越的性能和能效。基于 LPDDR5X 芯片,采用694个I/O端口,带宽可达传统 DDR5 的2.5倍。

在物理形态上,SOCAMM 尺寸仅为 14×90 毫米,外形类似U盘,相比传统 RDIMM 体积减少66%,为实现更紧凑、高效的服务器设计提供了可能。SOCAMM 采用了可拆卸的模块化插拔结构,改变了以往 LPDDR 内存必须焊接在主板上的限制,用户可以像更换硬盘或 SSD那样便捷地进行内存升级或替换,大大提高了系统的灵活性和可维护性。

SOCAMM 采用引线键合和铜互连技术,每个模块连接 16 个 DRAM 芯片,这种铜基结构增强了散热性能,对于 AI 系统的性能和可靠性至关重要。同时,SOCAMM 基于成熟的封装工艺,显著降低了部署门槛和制造难度,具备更强的成本控制能力和更广泛的适用范围。

于AI服务器和PC中采用

得益于 LPDDR5X 自身的低电压设计和优化后的封装工艺,SOCAMM 使服务器整体运行能耗减少约 45%,这种高效能与低功耗的平衡特性,使得 SOCAMM 不仅适用于集中式的数据中心,也能很好地服务于边缘计算场景中对空间和能耗敏感的应用需求。NVIDIA 计划将 SOCAM 率先应用于其 AI 服务器产品和 AI PC(工作站)产品。

在英伟达的规划中,将率先采用SOCAMM的产品将是GB300 Blackwell 平台。Blackwell 架构 GPU 具有 2080 亿个晶体管,采用专门定制的台积电 4NP 工艺制造。所有 Blackwell 产品均采用双倍光刻极限尺寸的裸片,通过 10 TB/s 的片间互联技术连接成一块统一的GPU。其在性能、效率和规模方面取得了突破性进步。而 SOCAMM 内存模块的加入,将进一步提升其在 AI 运算方面的表现。

此外,英伟达在今年5月GTC 2025上发布的个人 AI 超级计算机 “DGX Spark” 也采用了 SOCAMM 模块。DGX Spark 采用 NVIDIA GB10 Grace Blackwell 超级芯片,能够提供高性能 AI 功能,并支持多达 2000 亿个参数的模型。随着DGX Spark的推出,预计将推动SOCAMM向PC市场渗透,使更多消费者受益于这一先进的内存技术。

SOCAMM 与现有的笔记本电脑 DRAM 模块(LPCAMM)相比,其 I/O 速度提升,数据传输速度加快,且结构紧凑,更易于更换和扩展。

随着 SOCAMM 在 AI 服务器和 PC 中的应用不断增长,其大规模出货预计将对内存和 PCB 电路板市场产生积极影响。知情人士透露,“英伟达正在与内存和电路板行业分享 SOCAMM 的部署量(60 至 80 万片),该模块将应用于其 AI 产品”,目前内存和 PCB 电路板行业都在为订单和供货积极做准备。

从内存市场来看,SOCAMM 的应用将刺激对低功耗 DRAM 的需求,推动内存厂商加大在相关技术研发和产能扩充方面的投入。由于 SOCAMM 需要适配电路板设计,这将促使 PCB 厂商开发新的产品方案,带动行业技术升级。

美光率先供应SOCAMM

目前在内存厂商中,美光的 SOCAMM已率先获得英伟达量产批准。美光在内存解决方案领域一直积极探索创新,成为英伟达下一代内存供应商。而三星和 SK 海力士的 SOCAMM 目前尚未获得英伟达认证,不过这两家内存大厂也在积极与英伟达接洽,希望能够供应SOCAMM。

美光 SOCAMM 是业界首款专为 AI 资料中心设计的资料中心级模块化低功耗存储器模块。透过将美光业界领先的 LPDDR5X 与 CAMM 存储器模块结合在一起,这款次世代存储器为更有效率的 AI 资料中心奠定了基础。

来源:美光官网

美光宣称其最新LPDDR5X芯片能效比竞争对手高出20%,这是其赢得英伟达订单的关键因素。考虑到每台AI服务器将搭载四个SOCAMM模块(总计256个DRAM芯片),散热效率的重要性尤为突出。

与美光此前生产的服务器 DDR 模块RDIMM相比,SOCAMM的尺寸和功耗减少了三分之一,带宽增加了 2.5 倍。

通过采用美光LPDDR5X 等创新型低功耗(LP)存储器架构,资料中心可以大幅提高效能,并能够避免传统 DDR5 存储器的能源损耗。与 DDR5 等传统存储器技术不同,LP 存储器运行于较低的电压,并通过减少功耗、降低发热量、最佳化以节能为重点的电路设计等方式提高功耗和能源效率。

在大规模客户支持环境中执行推理 Llama 3 70B,单个 GPU 管理复杂的AI互动,同时实时处理数千个错综复杂的客户查询。LP 存储器的使用将这一密集型运算工作量转化为能源效率更高的过程。

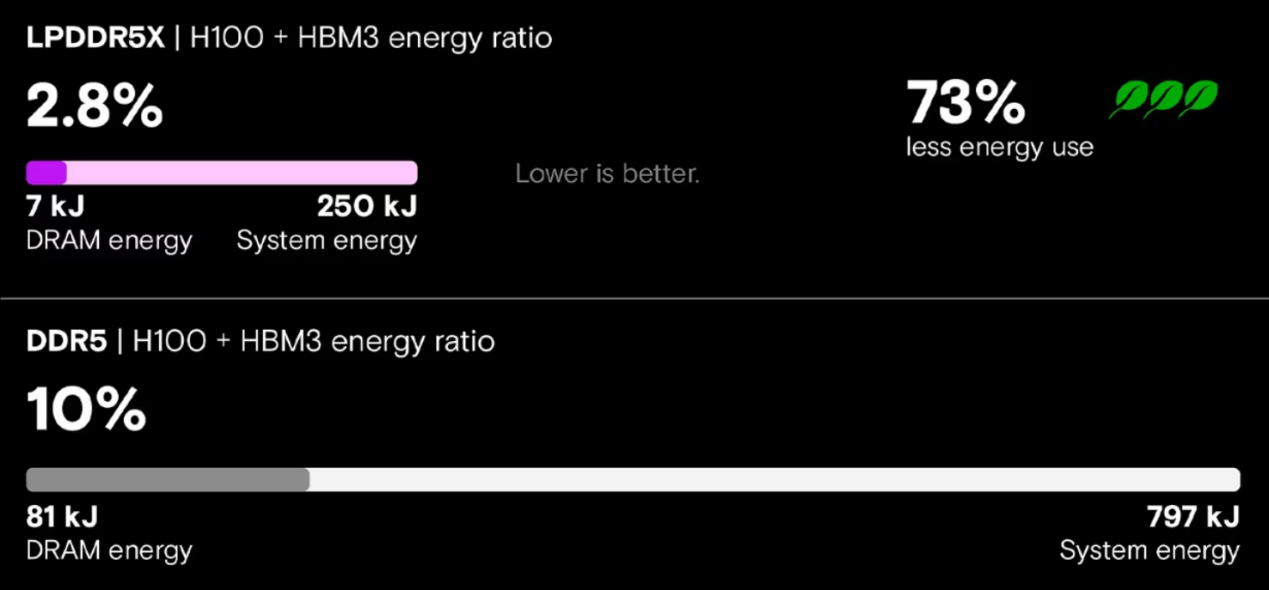

当我们测试 LPDDR5X 存储器(在搭载 NVLink 的 NVIDIA GH200 Grace Hopper 超级芯片上)与传统 DDR5 存储器(在搭载 PCIe 连线 Hopper GPU 的 x86 系统上)时,结果表明 LP 存储器实现了关键的效能提升。使用 Meta Llama 3 70B 测试推理效能时,LP 存储器系统推理吞吐量提高了 5 倍、延迟减少了近 80%、能源消耗降低了 73%。

LLM 推理的能源效率 来源:美光官网

小结:

随着英伟达对 SOCAMM 内存模块的大规模部署,以及其在 AI 服务器和 PC 市场的逐步渗透,将推动整个 AI 产业链围绕这一新型内存技术进行升级和发展。无论是内存厂商、PCB电路板厂商,还是服务器制造商和终端用户,都将受益于SOCAMM带来的影响。

发布评论请先 登录

继HBM之后,英伟达带火又一AI内存模组!颠覆AI服务器与PC

继HBM之后,英伟达带火又一AI内存模组!颠覆AI服务器与PC

评论