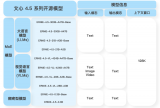

近日,百度正式开源文心大模型4.5系列模型。作为文心开源合作伙伴,宁畅在模型开源首日即实现即刻部署,做到“开源即接入、发布即可用”。据悉,文心4.5开源系列全部基于飞桨深度学习框架进行高效训练、推理与部署。

凭借覆盖训练、推理、微调全流程的AI服务器产品矩阵,宁畅帮助企业在大模型时代一键打通算力与应用“任督二脉”,显著缩短模型落地周期。

在已启动的深度技术合作中,双方将基于文心大模型共同推出面向企业的一站式解决方案:

即插即用:宁畅大模型一体机内置优化后的文心4.5推理与微调环境,开箱即可启动业务,以最小的成本和时间投入,快速开启模型运行与应用。

软硬协同:宁畅AI产品基于文心大模型优化底层算力策略,结合液冷技术,实现端到端性能提升与能耗优化。液冷设计将PUE降至行业新低,基于高吞吐、低延时、超节能,实现极致计算能效比。

完整生态,全链条支持:解决方案覆盖从前期咨询到弹性扩缩容、智能运维及模型调优订阅的一站式服务,全面助力企业智能化进化,助力国产大模型生态繁荣。

宁畅长期深耕服务器与液冷技术赛道,兼具硬件研发制造与软件栈优化能力,已服务众多行业用户构建AI基础设施。本次与百度文心的携手,标志着国产大模型在软硬件协同层面的又一次突破,为企业智能化升级提供了“拿来即用、规模可行”的新路径。

在生成式AI发展再度提速的今天,宁畅将继续秉承“开放、共创、共赢”的理念,与生态伙伴一道,推动中国算力底座与大模型技术双轮驱动,助力企业智能化进程全面提速。

-

开源

+关注

关注

3文章

3754浏览量

43968 -

宁畅

+关注

关注

0文章

52浏览量

5590 -

大模型

+关注

关注

2文章

3191浏览量

4146

原文标题:Say Hi to ERNIE!飞桨×文心4.5,宁畅让大模型落地更简单

文章出处:【微信号:Nettrix宁畅,微信公众号:Nettrix宁畅】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

海光DCU率先展开文心系列模型的深度技术合作 FLOPs利用率(MFU)达47%

百度文心大模型X1 Turbo获得信通院当前大模型最高评级证书

宁畅与与百度文心大模型展开深度技术合作

宁畅与与百度文心大模型展开深度技术合作

评论