文章翻译自EEnews Europe

人工智能(AI)不仅是一项技术突破,它更是软件编写、理解和执行方式的一次永久性变革。传统的软件开发基于确定性逻辑和大多是顺序执行的流程,而如今这一范式正在让位于概率模型、训练行为以及数据驱动的计算。这并不是一时的潮流。AI代表了计算机科学的一次根本性、不可逆的转变——从基于规则的编程,迈向自适应的、基于学习的系统,这些系统正逐步被集成到越来越广泛的计算问题与能力中。

这一转变也对硬件提出了相应的变革需求。在AI架构和算法不断演进(并将持续演进)的时代,为狭窄定义任务而打造的高度专用芯片的旧模式已不再适用。为了满足不断变化的AI需求(尤其是在边缘侧),我们需要具备与工作负载同样动态、适应能力强的计算平台。

这正是为什么通用并行处理器(即GPU)正在成为边缘AI的未来,并开始取代诸如神经网络处理器(NPU)这样的专用处理器。这不仅仅是性能的问题——更是关于灵活性、可扩展性,以及与未来软件发展方向保持一致的问题。

Makimoto波动理论与“灵活性”的回归

要理解这一转变,我们只需回顾“Makimoto波动理论”:这是由日本工程师牧本次雄(Tsugio Makimoto)提出的一个概念,描述了计算产业在不同阶段不断在“标准化”与“定制化”之间摆动的趋势,其背后是市场需求、技术创新和软件复杂性等因素的持续变化。

(Makimoto波动理论展现了计算产业在“灵活性”与“专用性”之间的历史摆动。而当前AI的发展轨迹,标志着计算正再次呈现出在“灵活性”和“通用平台”之间的摆动。)

这一模型与AI硬件的演变过程高度契合。在AI发展的早期阶段,工作负载较为明确且稳定,此时采用NPU等固定功能加速器是合理的。这类处理器对特定任务(例如使用CNN进行图像分类或目标检测)进行了深度优化。

但如今AI已进入高速演进阶段。我们已走出简单、静态模型的时代,迈入混合网络、Transformer架构、基础模型和持续创新的浪潮之中。为去年AI打造的定制硬件,根本无法跟上当今的发展节奏。

我们再次站在了“Makimoto拐点”上——从专用硬件,回归到可扩展、可适配的通用计算平台。

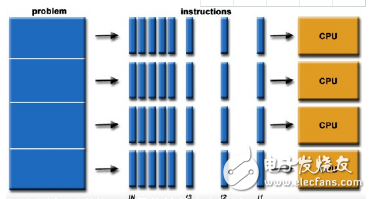

AI是一个并行计算问题,而非专用计算问题

AI的本质在于并行计算。深度学习严重依赖并发操作——矩阵运算、张量乘法、向量计算——这些正是GPU天生擅长的工作负载。能够同时渲染数百万像素的架构,如今正好可以处理数百万神经元的激活。

如今的通用GPU早已不仅仅用于图形处理。它们拥有可编程管线、计算着色器,以及日益增强的AI中心化设计,不仅能加速传统负载,也能支持新兴的AI工作负载,是边缘AI中强大而灵活的计算引擎。

相比之下,像NPU这样的专用处理器则难以应对持续的变革。它们对特定操作进行了优化,而当AI领域快速演进时,这些芯片便迅速被淘汰。显然,面对这种全新的软件范式,我们需要的是一种通用的、并行的、灵活的硬件平台—— GPU。

为什么通用平台在边缘侧更具优势

边缘AI不仅需要性能,更需要适应性、可重用性与较长的生命周期。现代GPU等通用并行处理器在这几个方面均具备明显优势:

灵活性:可编程,能够支持新的模型类型而无需更换硬件;

可扩展性:可适配从IoT传感器到智能摄像头再到自动驾驶汽车等各种边缘设备;

软件生态成熟:拥有丰富的开源工具与开发标准(如OpenCL、LiteRT、TVM);

可持续性:延长产品生命周期,减少不断重新设计芯片的需求。

简而言之,GPU的通用并行计算从架构层面就为AI的持续演进而设计。

展望未来

尽管有越来越多的证据说明GPU具备的优势,市场仍然习惯将AI加速与NPU或定制芯片划等号。但正如图形行业早年发现,固定功能的图形管线无法跟上游戏创新的节奏,如今AI行业也发现:固定硬件无法匹配快速变化的软件需求。

是时候重新教育整个生态了。边缘AI的未来不属于那些高度优化但功能狭窄的芯片,而是属于可编程的、可适配的并行计算平台,它们能与智能软件共同成长并扩展。

几十年前,Makimoto就洞察了这一趋势。如今,我们正在亲身经历他的远见——顺应着通用性和灵活性的浪潮前行。GPU不再是追赶者,它已处于领先位置。

Dennis Laudick是Imagination Technologies的产品管理副总裁。在加入公司之前,Dennis曾在Arm任职超过13年,担任汽车、AI和GPU相关业务的产品与市场领导职务。在此之前,他还曾在多家半导体与OEM巨头企业担任高级管理岗位。

-

gpu

+关注

关注

28文章

4968浏览量

131675 -

并行计算

+关注

关注

0文章

29浏览量

9623 -

NPU

+关注

关注

2文章

333浏览量

19848 -

边缘AI

+关注

关注

0文章

169浏览量

5493

发布评论请先 登录

arm系统中并行计算优化

并行计算和嵌入式系统实践教程

基于GPU图像去噪总变分对偶模型的并行计算

基于Matlab和GPU的BESO方法的全流程并行计算策略

并行计算的崛起:为什么GPU将在边缘AI中取代NPU

并行计算的崛起:为什么GPU将在边缘AI中取代NPU

评论