大语言模型(LLMs)正以革命性的姿态重塑我们与科技的互动模式。然而,由于其庞大的规模,它们往往属于资源密集型范畴,不仅大幅推高了成本,还造成了能源消耗的激增。本文深入剖析了大语言模型的规模大小、硬件需求以及所涉及的财务影响这三者之间的内在联系。我们将深入探究现实中大语言模型的发展趋势,并共同探讨如何借助规模更小、效能更高的模型,打造一个更具可持续性的人工智能生态系统。

理解模型规模:参数与性能

不妨将大语言模型视作一个大脑,其中有着数十亿个名为“参数”的“细胞”。其“细胞”数量越多,它便越智能,功能也越发强大。从传统意义上来说,规模更大的模型往往具备更卓越的理解能力,所储备的知识也更为丰富——这就好比一个大脑,同时拥有了更高的智商和更强大的记忆力。本质上,一个大型的大语言模型就如同一位学识深厚、见解独到的专家。然而,获取这种专业能力是需要付出代价的。这些规模更大的模型需要更为强劲的计算机来驱动,能耗也会大幅增加,不仅使成本显著上升,对环境产生的影响也不容小觑*。

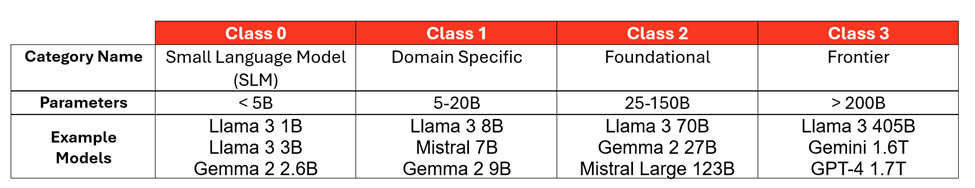

为了能更好地对语言模型进行分类,按照模型规模大小来划分会很有帮助。这张图表展示了不同类别的模型,以及与之对应的参数数量和示例:

基于公开可用信息(在可获取的情况下)和行业对闭源模型的估计。

大语言模型:性能更优,体积更小

我们不妨以 Llama 模型为例。这些模型的迅猛发展,凸显出人工智能领域的一个关键趋势:对效率与性能的高度重视。

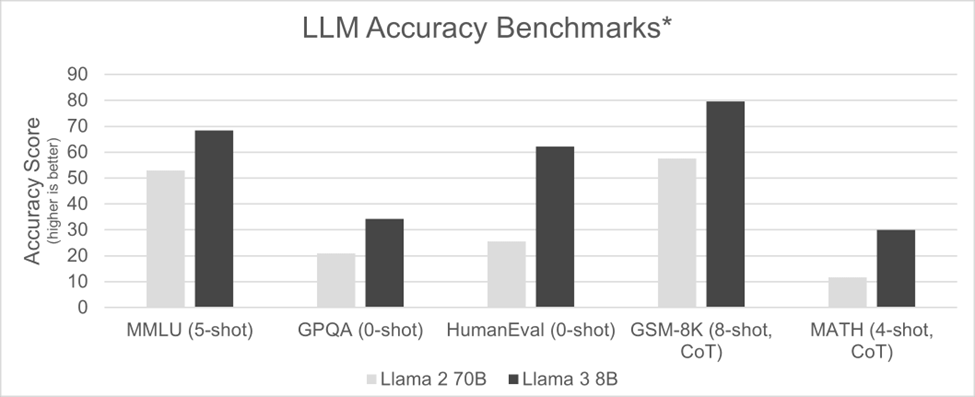

2023年8月,Llama 2 700亿参数(70B)版本一经推出,便被视作顶级基础模型。然而,其庞大的规模对硬件要求极高,只有像 NVIDIA H100 这样强劲的加速器才能支撑其运行。短短不到九个月后,Meta 公司推出了 Llama 3 80亿参数(8B)版本,模型规模锐减近九倍。这一优化使得该模型不仅能够在更为小巧的人工智能加速器上运行,甚至在经过优化的 CPU 上也能顺畅运作,硬件成本与功耗均大幅降低。尤为值得一提的是,在准确性基准测试中,Llama 3 80亿参数版本的表现超越了参数更多、体积更大的前代模型。

*信息来源及测试方法:出自 “指令微调模型” 部分:

这一趋势在2024年9月 Llama 3.2发布时得以延续,该版本推出了适用于多种应用场景的10亿参数(1B)和30亿参数(3B)变体。就连像 Llama 3.2 4050亿参数(405B)这样的大型三类模型也在缩小规模。2024年12月,Llama 3.3 700亿参数(70B)版本问世,在 MMLU 聊天测评中取得了86.0的分数*,几乎与参数规模大得多的前代模型 Llama 3.2 4050亿参数(405B)所获得的88.6分相当。

这表明,如今较小规模类别的模型在使用更少计算资源的情况下,其性能(准确性)已能与上一代较大规模类别的模型相媲美。这种向更小、更高效模型的转变正在推动人工智能的普及,有助于让更多人能够使用人工智能,同时也使其更具可持续性*。更妙的是,这种朝着小型语言模型发展的趋势在未来很可能会持续下去,因此可以预期,未来发布的新模型其规模可能会比当前一代的模型小很多倍。

模型愈发贴合特定应用场景

我们正见证着一种日益增长的趋势,即通过一种名为知识蒸馏的过程来创建专门的人工智能模型。这种技术本质上是从大语言模型中“去除冗余”,剔除不必要的信息,并常常针对特定任务对其进行优化。

可以这样理解:一家大型销售机构想要分析其内部数据,它并不需要一个能够写诗或设计建筑的人工智能模型。同样,一个需要编码帮助的工程部门也不需要一个拥有丰富鸟类迁徙知识的模型。

通过知识蒸馏,我们能够创建出在指定领域表现卓越的高度专业化模型。这些模型更加精简、运行速度更快且效率更高,因为它们没有被无关信息所累。

这种朝着特定领域模型发展的趋势带来了诸多好处:

? 提高准确性:通过专注于特定领域,这些模型在其专业领域内能够实现更高的准确性和更好的性能表现。

? 降低资源消耗:规模更小、更具针对性的模型通常所需的计算能力和内存更少,这有助于使其更具成本效益且更加节能。

? 增强可部署性:特定领域的模型可以轻松部署在更广泛的硬件上,包括直接在经过人工智能优化的 CPU 上进行推理。

随着人工智能的不断发展,我们可以预期,这些专门的模型将大量涌现,在从客户服务、医学诊断到金融分析、科学研究等各个特定领域中表现出色。我们期待看到在全球范围内的各个行业和应用中,新的潜力被不断挖掘出来。

你的人工智能运行速度是不是太快了?

人们往往很容易想要把重点放在最大化人工智能推理速度上(就好比吹嘘一辆跑车的最高时速那样),但一种更为实际的做法是考虑用户的实际需求。

就像用一辆跑车来满足日常通勤需求有点大材小用一样,以闪电般的速度生成文本对于人机交互来说可能也没有必要。有资料显示,普通人每分钟能阅读200到300个英文单词。人工智能模型很容易就能超过这个速度,但根据与人工智能平台联盟*的合作经验,每分钟输出大约450个单词(每秒10个词元,按每个英文单词约1.3个词元来算*)的速度通常就足够了。

一味地追求绝对速度可能会导致不必要的成本增加和流程复杂化。一种更为平衡的方法是注重在不过度消耗资源的前提下,为用户提供最佳的使用体验。

云原生处理器:用于推理的灵活解决方案

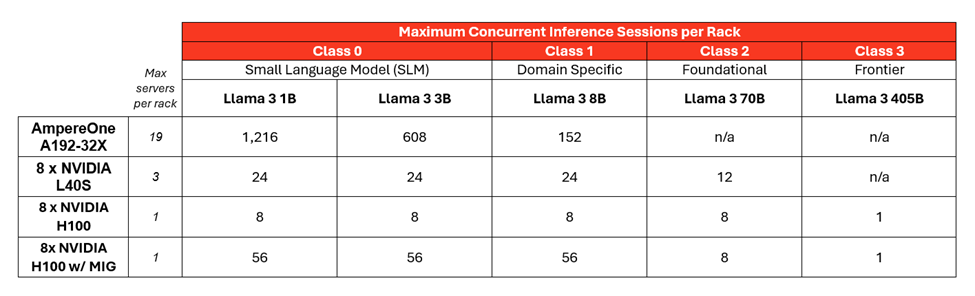

AmpereOne 云原生处理器,相较于 GPU 具有一项关键优势:灵活性。它们能够对计算核心进行分配,从而允许多个人工智能推理会话同时运行。虽然 GPU 通常一次只能处理单个

会话(不过也有一些例外情况,比如 NVIDIA H100 具备有限的多实例 GPU(MIG)功能),但一个拥有192个核心的 CPU 可以进行分区,以处理大量较小的任务,其中包括通用型工作负载。

这使得 CPU 在运行规模较小的0类或1类人工智能模型时效率极高。尽管 GPU 凭借其强大的原始计算能力,在处理规模较大的2类或3类模型时仍然表现出色,但对于许多常见的人工智能应用而言,CPU 提供了一种具有成本效益且可扩展的解决方案。

从本质上讲,这关乎为任务选择合适的工具。对于大型、复杂的模型而言,人工智能硬件加速器无疑是最佳选择。但对于数量较多的小型任务,经过人工智能优化的云原生处理器所具备的灵活性和高效性则展现出了显著的优势。

通过合理规划计算规模,实现每个机架的大语言模型效率最大化

为了让每个人都能更轻松地使用人工智能推理,我们需要降低其成本。这意味着要选择规模较小的人工智能模型,并让它们在高效的硬件上运行,从而最大限度地增加我们能够同时执行的人工智能任务数量。

大多数数据中心运营商每个机架的电力预算限制在10千瓦到20千瓦之间*。通过优化模型规模和硬件选择,我们可以提高每个机架上人工智能推理的密度,使这项技术更具成本效益,也更能广泛普及。

我们以一个功率为12.5千瓦、42U规格的机架为例来进行说明。以下是根据模型规模和硬件配置,在保持每秒至少10个词元(TPS)的情况下,能够运行的人工智能推理会话数量:

敲黑板划重点:较小规模的人工智能模型(0类或1类)能够在一个机架中大幅增加可同时运行的人工智能任务数量,并且还能始终保持令人满意的用户体验。以下是这一情况得以实现的原因:

? 能源效率:AmpereOne 能源利用效率高,能够在普通机架中实现可运行服务器数量的最大化。

? 分区能力:拥有192个计算核心的 AmpereOne 允许每个机架创建多个并发的推理会话。

? Ampere 人工智能优化器:Ampere 的人工智能优化器(AIO)库有助于提升诸如Llama 3等大语言模型的性能。

构建更具可持续性的人工智能计算体系通过针对特定的应用场景和行业对人工智能模型进行优化,我们能够显著减小模型的规模和复杂程度。这种有的放矢的方法有助于创建出规模更小、效率更高的模型,这些模型所需的计算能力较低,并且可以在成本更低、更易于获取的云原生硬件上运行。这不仅使个人和小型组织更容易接触和使用人工智能,还能通过降低能源消耗来促进可持续发展。

这赋予了个人、研究人员以及各种规模的企业利用人工智能潜力的能力,从而在各个领域推动创新并带来社会效益。若想深入了解 Ampere 在人工智能推理领域的创新成果,可访问 Ampere 人工智能主页。

关于 Ampere Computing

Ampere Computing 是一家现代化半导体企业,致力于塑造云计算的未来,并推出了世界上首款云原生处理器。为可持续云而生,Ampere 云原生处理器兼具最高性能和最佳每瓦性能,助力加速多种云计算应用的交付,为云提供行业领先的性能、能效和可扩展性。

-

处理器

+关注

关注

68文章

19935浏览量

236271 -

cpu

+关注

关注

68文章

11097浏览量

217643 -

人工智能

+关注

关注

1809文章

49151浏览量

250622 -

语言模型

+关注

关注

0文章

563浏览量

10836 -

Ampere

+关注

关注

1文章

81浏览量

4722

原文标题:大语言模型(LLMs):并非越大越好

文章出处:【微信号:AmpereComputing,微信公众号:安晟培半导体】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

体验碎片化及安徽信任度将影响大时代人工智能设备的可靠发展

STM32单片机基础01——初识 STM32Cube 生态系统 精选资料分享

Microchip FPGA 和基于 SoC 的 RISC-V 生态系统简介

IT的生态系统概述

BAT抢占智能家庭市场入口,打造自家生态系统

如何使用人工智能进行智能家居生态系统设计的研究分析

美军人工智能的生态系统变化综述

如何借助大语言模型打造人工智能生态系统

如何借助大语言模型打造人工智能生态系统

评论