SL1680 SoC本地运行DeepSeek R1 1.5B大模型

自DeepSeek大模型发布以来,深蕾半导体SoC团队针对在端侧运行DeepSeek大模型不断进行研究,探索将DeepSeek大模型与SoC系列产品相结合的模式。目前已经实现利用深蕾半导体的ASTRA SL1680 SoC本地运行DeepSeek R1 Distill Qwen2.5 1.5B大模型。

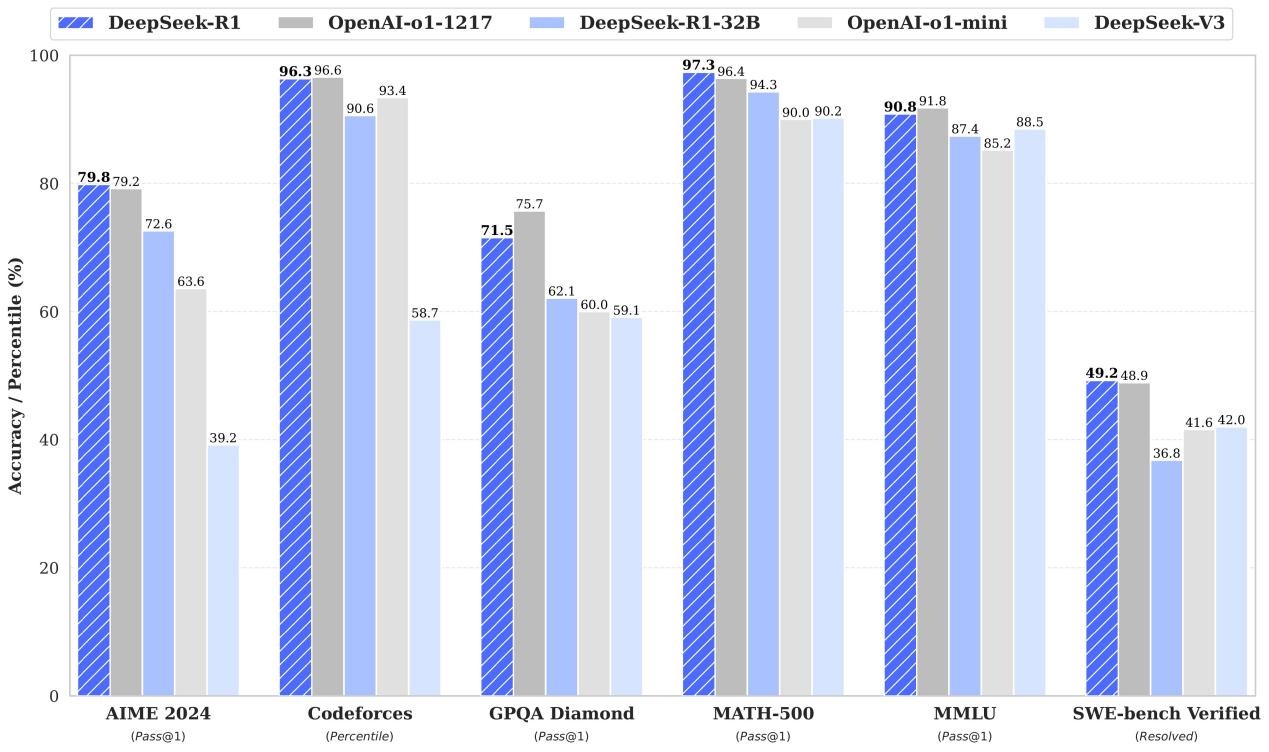

DeepSeek R1 Distill Qwen2.5 1.5B是DeepSeek R1发布中最小的模型 - 它可以在ASTRA SL1680上舒适地运行。

一、SL1680本地运行Deepseek-R1-1.5B大模型展示

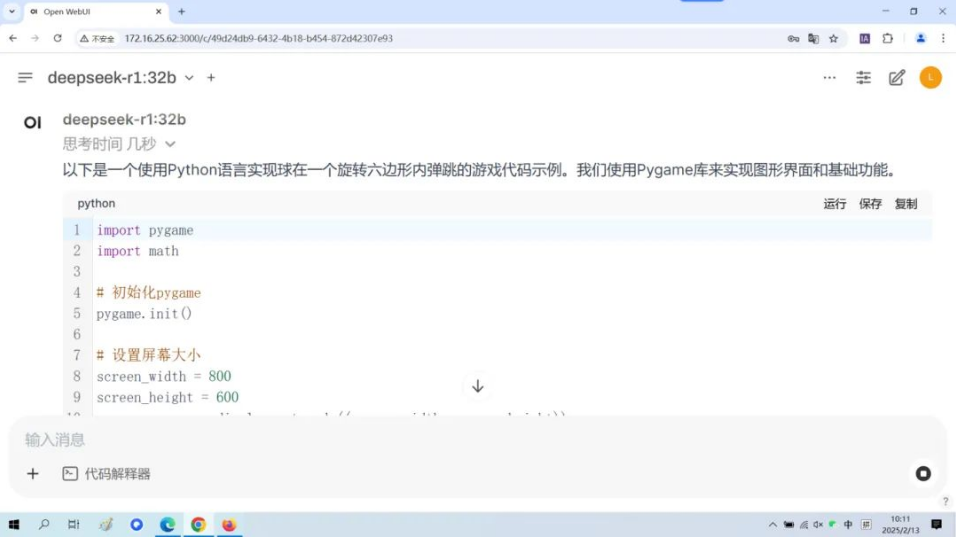

SL1680本地运行Deepseek-R1-1.5B大模型视频效果

执行过程

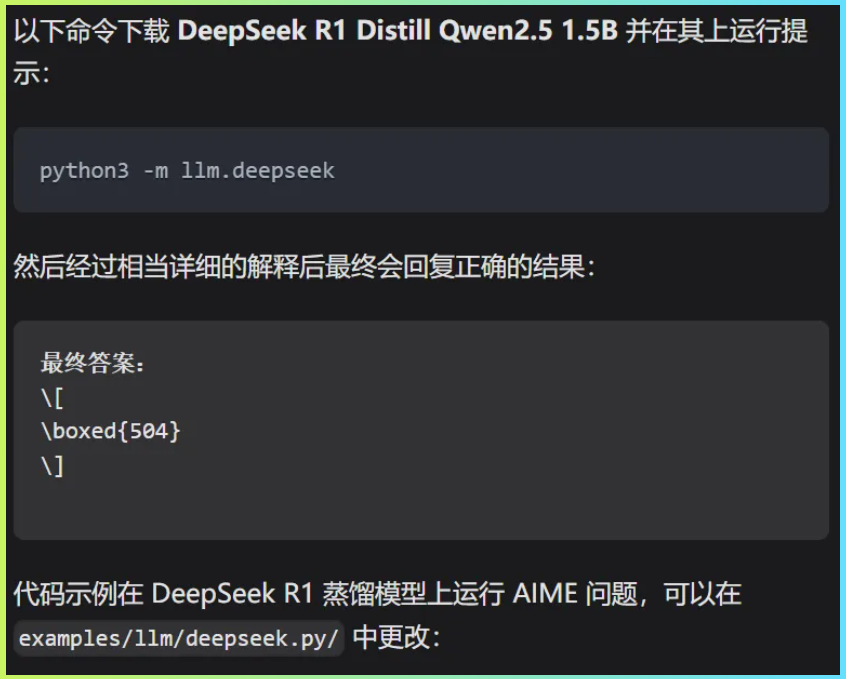

要在ASTRA开发板上运行Qwen,我们将使用llama-cpp-python包,它为Georgi Gerganov的llamacpp提供了便捷的Python绑定。

除了在SL1680本地运行Deepseek-R1-1.5B大模型,还实现了运行Llama 3.2 1B大模型。

运行环境

系统:Linux(yocto)

硬件:SL1680 RDK开发板

产品化路径

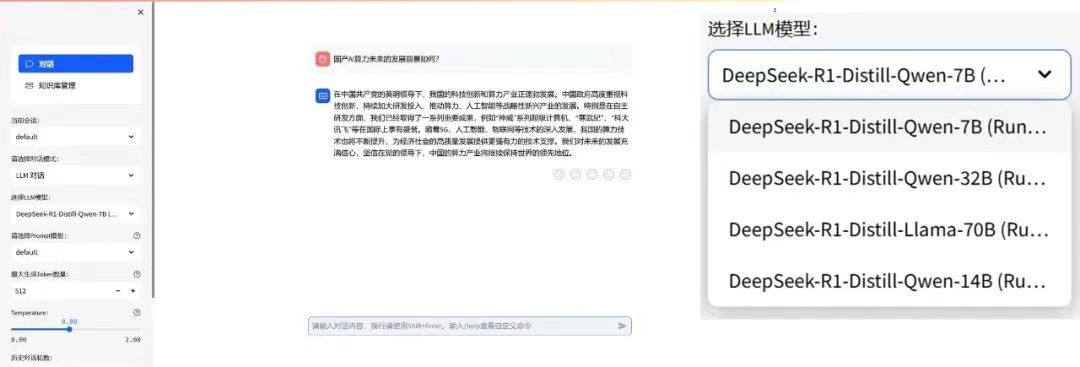

对于SL1680产品如何与大模型结合的问题,建议采用端侧大模型与云端大模型相结合的工程化方式处理,本地能处理的用户任务使用端侧大模型快速解决和输出,而较复杂的逻辑以及联网功能则通过请求云端大模型API的方式实现。

如视频所展示的,将Deepseek-R1-1.5B大模型部署到SoC本地,能够实现知识问答、FuntionCall等AI能力。通过将云端的大模型与端侧的语音识别、机器视觉功能、端侧小参数大模型相结合,从而让AI赋能我们的产品,提升产品的智能化程度。

二、本地小参数大模型与端云大模型结合的应用场景

1,多媒体终端:本地小参数大模型可在端侧如智能大屏,快速处理一些常见的简单任务,如语音助手对常见指令的快速响应、文本的简单摘要生成、数据加工整理、设备操控、产品说明、产品售后问题自助解决等。当遇到复杂任务,如深度文本分析、多模态内容生成时,可将任务发送到云侧大模型进行处理,利用云侧大模型强大的计算能力和丰富的知识储备来完成。

2,智能办公设备(MINI PC):本地小参数大模型可以实时处理用户的语音交互、文字输入信息处理、智能控制等任务,作为用户AI助手。而对于一些复杂的逻辑理解、内容生成设计和决策任务等,则借助云侧大模型的强大算力和更全面的数据分析能力来完成。

3,零售电商:在商品展示平台的搜索推荐场景中,本地小参数大模型可以根据用户在本地设备上的浏览历史、购买行为、环境感知等数据,快速生成初步的推荐结果。当用户有更复杂的搜索需求,如对比不同商品的详细参数、询问商品的使用场景等问题时,云侧大模型可以利用其庞大的商品知识库和强大的语言理解能力,给出更准确、详细的回答和推荐。

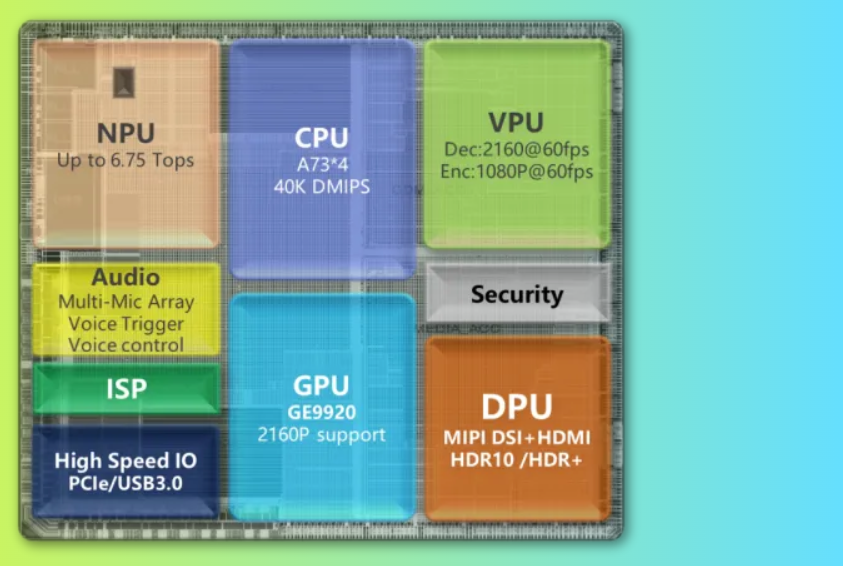

三、ASTRA SL1680 SoC介绍

ASTRA SL1680是一款专为智能应用设计的高性能系统级芯片(SoC),它拥有

Cortex A73是ARM公司设计的一款高性能CPU核心,适用于需要高性能计算的应用场景,能够提供强大的处理能力和多任务处理能力,为Deepseek-R1-1.5B大模型的运行提供坚实保障。

2,高达7.9 Top NPU算力:

NPU(Neural Processing Unit,神经网络处理单元)是专门用于加速神经网络计算的硬件单元。7.9 Top的算力使SL1680在神经网络计算方面有着极高的性能,为端云结合的应用模式创造了有利条件。

3,64-bit高速内存:

64位内存架构支持更大的内存寻址空间,使得SL1680能够同时处理更多的数据和运行更复杂的应用程序。高速内存则保证了数据访问的迅速性,提升了整体性能。

审核编辑 黄宇

-

soc

+关注

关注

38文章

4406浏览量

223194 -

大模型

+关注

关注

2文章

3191浏览量

4147 -

DeepSeek

+关注

关注

2文章

804浏览量

1830

发布评论请先 登录

【幸狐Omni3576边缘计算套件试用体验】CPU部署DeekSeek-R1模型(1B和7B)

DeepSeek R1模型本地部署与产品接入实操

如何基于Android 14在i.MX95 EVK上运行Deepseek-R1-1.5B和性能

RK3588开发板上部署DeepSeek-R1大模型的完整指南

兆芯全面部署DeepSeek R1大模型

9.9万元用上“满血”DeepSeek R1一体机,本地部署成新商机?

景嘉微JM11 GPU已流片,JM、景宏系列完成DeepSeek R1系列模型适配

IBM在watsonx.ai平台推出DeepSeek R1蒸馏模型

Gitee AI 联合沐曦首发全套 DeepSeek R1 千问蒸馏模型,全免费体验!

部署DeepSeek R1于AX650N与AX630C平台

壁仞科技顺利部署DeepSeek R1千问蒸馏模型

AI赋能驾驶安全:Synaptics SL1680疲劳驾驶检测方案

SL1680 SoC本地运行DeepSeek R1 1.5B大模型

SL1680 SoC本地运行DeepSeek R1 1.5B大模型

评论