近期科技圈对Deepseek R1的热度持续升温。这款AI模型是否真的如传闻中那般神奇?让我通过Raspberry Pi实测带您一探究竟。

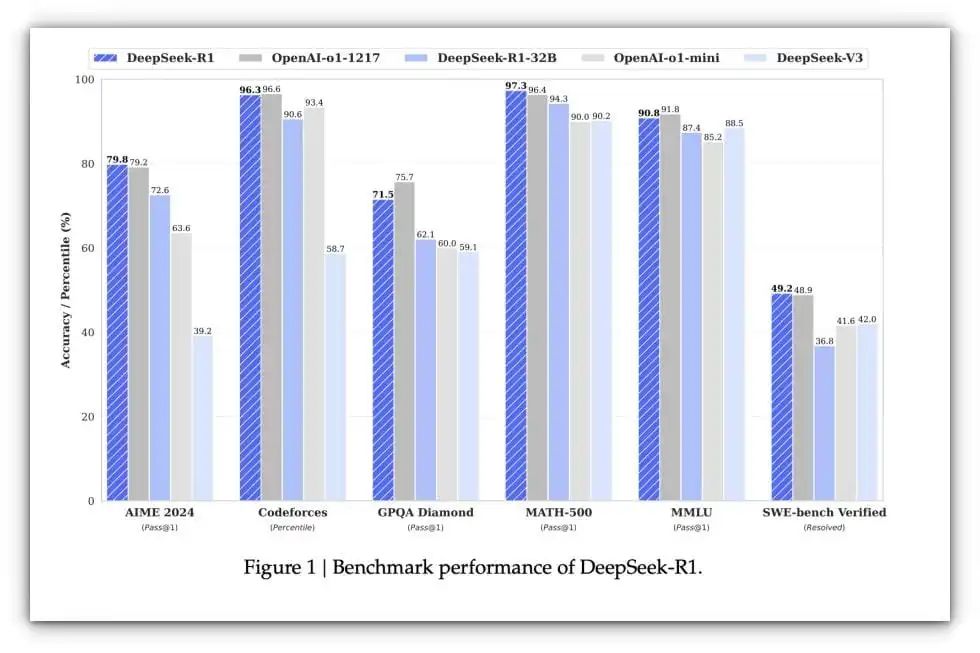

自DeepSeek AI发布以来,科技媒体圈就掀起了一场风暴。这款模型不断打破性能基准测试记录,俨然已成为AI创新领域的标杆。

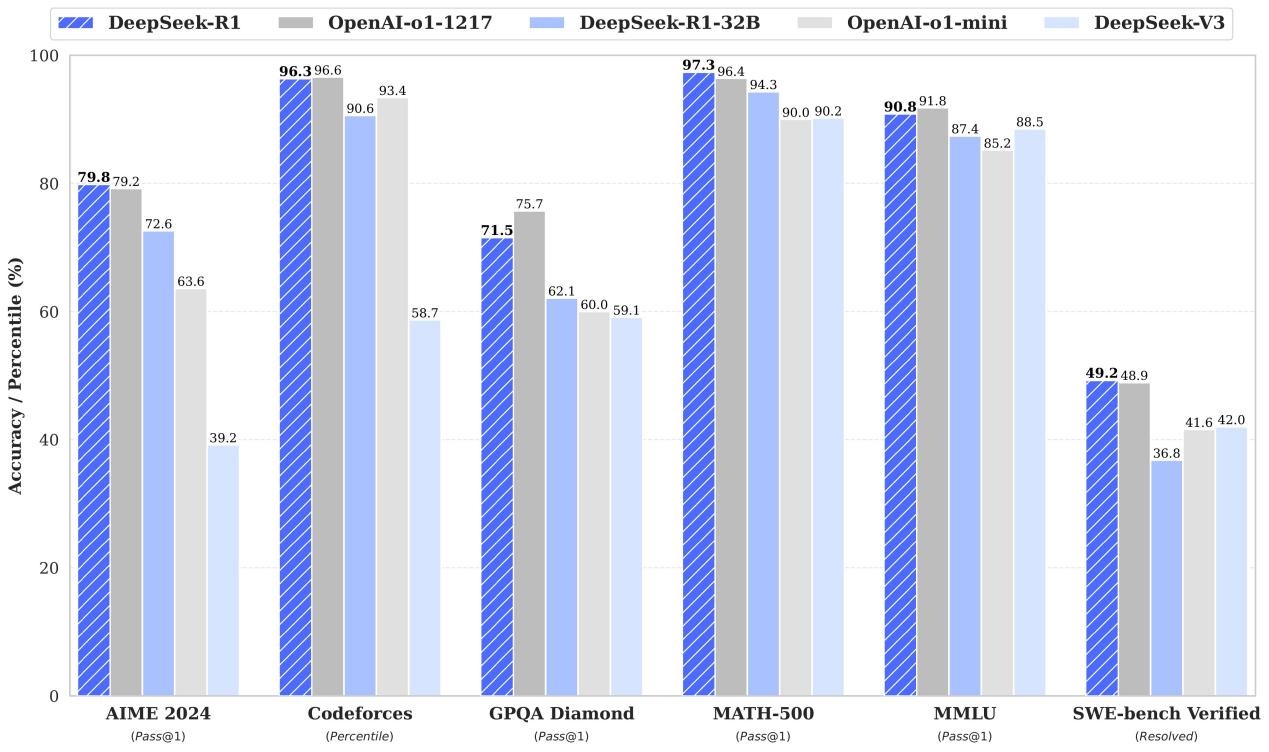

DeepSeek与OpenAI基准对比 | 来源:Brian Roemmele

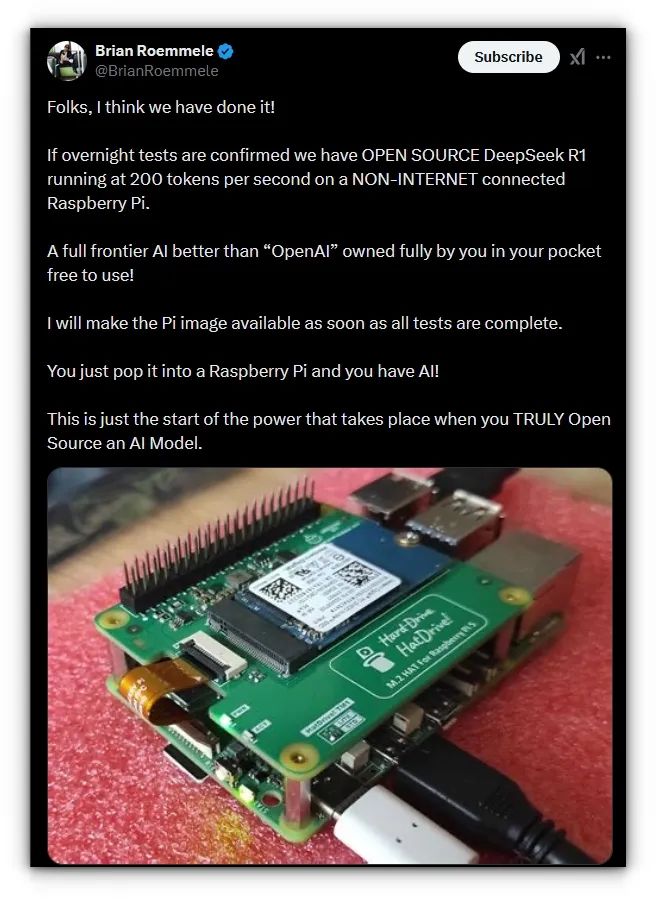

最近我在X平台偶然看到有人声称在Raspberry Pi上以200 token/秒的速度运行Deepseek。

这让我瞬间怀疑人生:"什么鬼?!"

仔细研究整个讨论串后发现,该用户是通过在Raspberry Pi上叠加AI加速模块才达成的成绩。但好奇心驱使我决定挑战极限:在没有额外硬件的情况下,用原生Raspberry Pi 5(8GB版)测试Deepseek的真实性能。

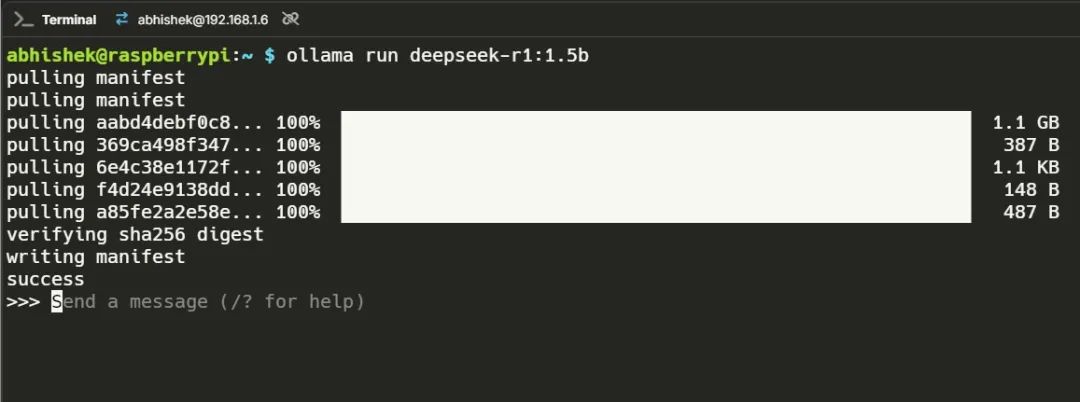

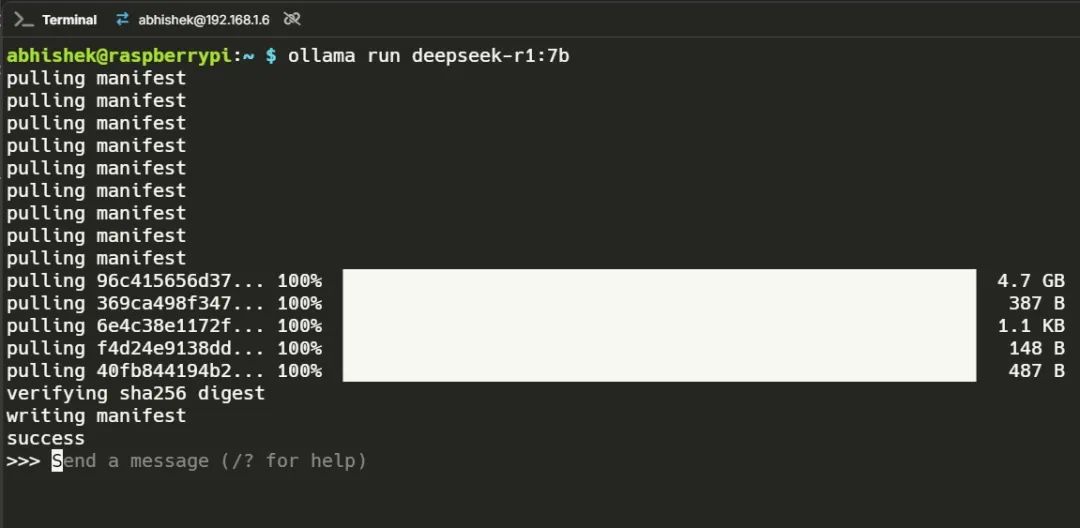

因此,为了这篇文章,我在我的Raspberry Pi 5(8GB内存型号)上安装了Ollama,并下载了具有不同参数(即15B、70B、80B和140B参数)的Deepseek模型。

Ollama:

https://ollama.com/

Deepseek模型:

https://ollama.com/library/deepseek-r1

以下是每个模型的性能表现:

Deepseek 1.5B

这个模型反应迅速。它出乎意料地灵敏,能够轻松处理改写任务。我没有遇到任何幻觉(生成不符合逻辑或上下文的内容)问题,这使其成为日常任务(如摘要生成和文本生成)的理想选择。

性能数据

为了进一步测试其能力,我提出了一个问题:Podman和Docker有什么区别?

模型给出了相当不错的回答,清晰地阐述了这两种容器化工具之间的区别。它强调了Podman是无守护进程的,而Docker依赖于守护进程,并涉及了无根操作等安全方面。

这个回答花了大约两分钟,以下是性能数据:

总时长:1m33.59302487s加载时长:44.322672ms提示评估次数:13个tokens提示评估时长:985ms提示评估速率:13.20个tokens/s评估次数:855个tokens评估时长:1m32.562s评估速率:9.24个tokens/s

Deepseek 7B

7B模型引入了一定程度的幻觉。我尝试编写一个创意提示,要求生成三首俳句,但它开始生成无尽的文本,甚至自己问自己问题!

虽然很有趣,但并不实用。为了基准测试的目的,我简化了提示,如视频所示。在性能方面,它更慢,但仍然可用。

性能数据

为了进一步测试,我问:Docker Compose和Docker Run有什么区别?回答是准确信息和不准确信息的混合体。

它正确地解释了Docker Compose通过docker-compose.yml文件用于管理多容器应用程序,而Docker Run通常用于使用特定标志运行单个容器。

然而,它很快就开始自己问问题,比如“但是,对于一个单应用,比如单台机器上的简单Flask应用,Docker Run可能就足够了?还是有其他命令或方法?”

以下是性能数据:

总时长:4m20.665430872s加载时长:39.565944ms提示评估次数:11个token(s)提示评估时长:3.256s提示评估速率:3.38个token/秒评估次数:517个token评估时长:4m17.368s评估速率:2.01个token/秒

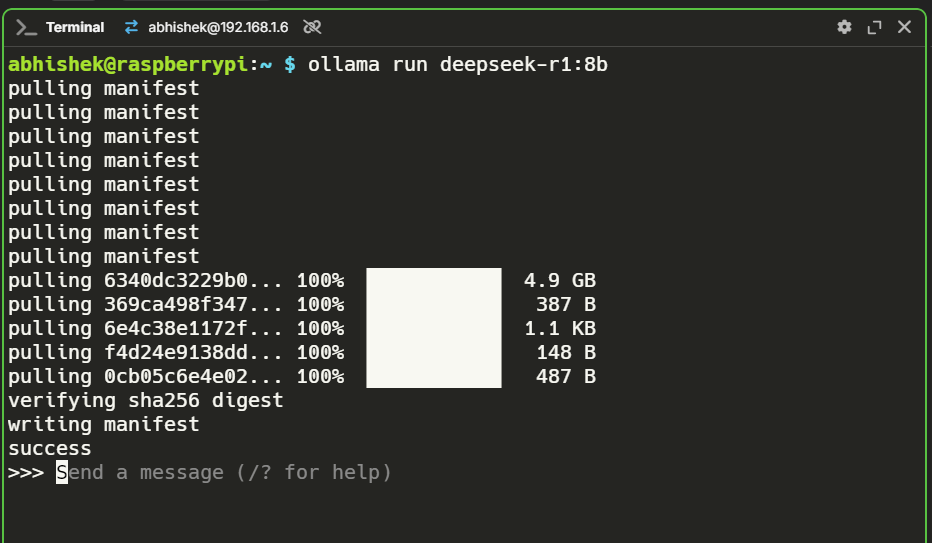

Deepseek 8B

这是一个变数。考虑到这些模型对资源的巨大需求,我没想到8B模型能运行起来。令我惊讶的是,它竟然成功了!

性能与7B模型相当,既不快,也不是特别灵敏,但在没有任何额外硬件的Raspberry Pi上运行一个8B模型,在我看来就是胜利。

性能数据

我通过提问“编写一个HTML模板和CSS模板”来测试它。模型成功地在单个代码块中生成了一个功能性的HTML和CSS模板,并确保它们整齐地配对。

然而,在跳到解决方案之前,模型解释了它的方法、它将要做什么以及还可以添加什么。

虽然这提供了信息,但对于一个直接的查询来说,这感觉是不必要的。如果我更精确地构造提示,回答可能会更直接(即用户错误)。

以下是性能数据:

总时长:6m53.350371838s加载时长:44.410437ms提示评估次数:13个 token(s)提示评估时长:4.99s提示评估速率:2.61个tokens/s评估次数:826个token评估时长:6m48.314s评估速率:2.02个tokens/s

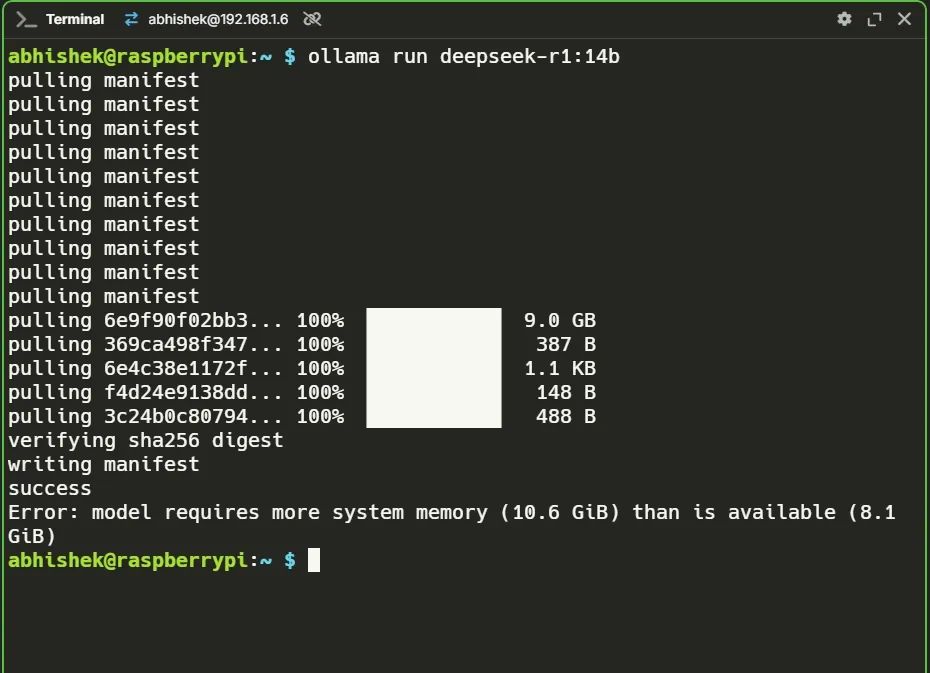

Deepseek 14B?

不幸的是,这并没有成功。14B模型需要超过10GB的内存,而我的8GB Raspberry Pi无法处理。在8B模型成功后,我充满希望,但现实给了我一击。

结论

DeepSeek在Raspberry Pi 5上的原始性能展示了单板计算机(SBC)在处理AI工作负载方面的巨大潜力。

1.5B模型是轻量级任务的实际选择,而7B和8B模型则展示了Raspberry Pi处理更大工作负载的能力,尽管速度较慢。

-

树莓派

+关注

关注

122文章

2034浏览量

107692 -

DeepSeek

+关注

关注

2文章

804浏览量

1845

发布评论请先 登录

DeepSeek开源新版R1 媲美OpenAI o3

4台树莓派5跑动大模型!DeepSeek R1分布式实战!

RK3588开发板上部署DeepSeek-R1大模型的完整指南

OpenAI O3与DeepSeek R1:推理模型性能深度分析

安霸大算力AI芯片接入DeepSeek R1

IBM在watsonx.ai平台推出DeepSeek R1蒸馏模型

了解DeepSeek-V3 和 DeepSeek-R1两个大模型的不同定位和应用选择

超星未来惊蛰R1芯片适配DeepSeek-R1模型

Deepseek R1大模型离线部署教程

Krea发布Deepseek R1驱动的Chat功能

云天励飞上线DeepSeek R1系列模型

Deepseek R1在树莓派5上的真实表现...

Deepseek R1在树莓派5上的真实表现...

评论