作者:算力魔方创始人/英特尔创新大使刘力

一,简介

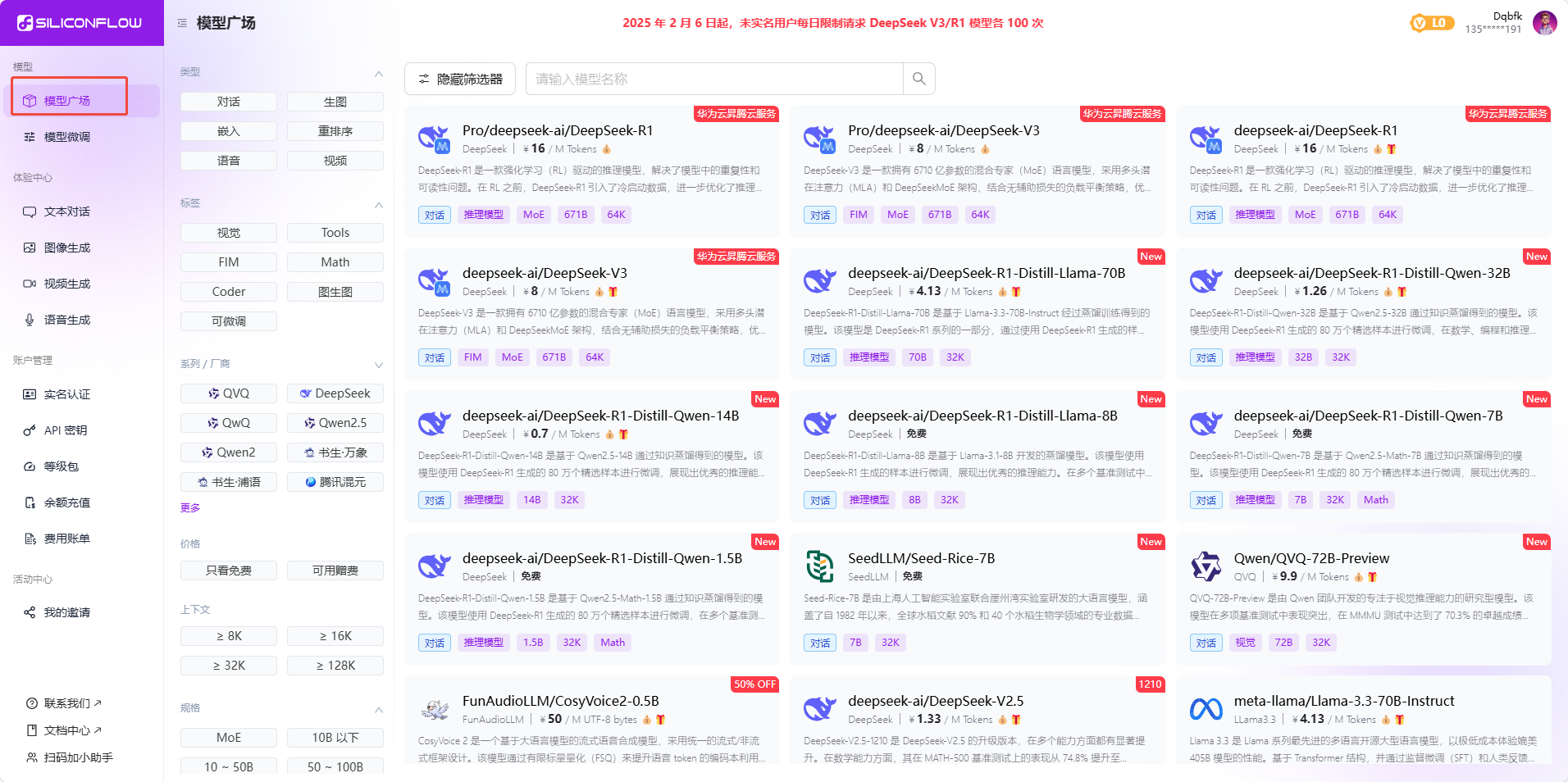

本文将指导您如何在MAC mini4上安装Ollama和Chatbox,并下载Deepseek-r1:32b模型。Ollama是一个用于管理和运行大型语言模型的工具,而Chatbox则是一个用户友好的聊天界面,用于与这些模型进行交互。Deepseek-r1:32b是一个高性能的语言模型,适用于多种自然语言处理任务。

二,安装Ollama和Chatbox AI

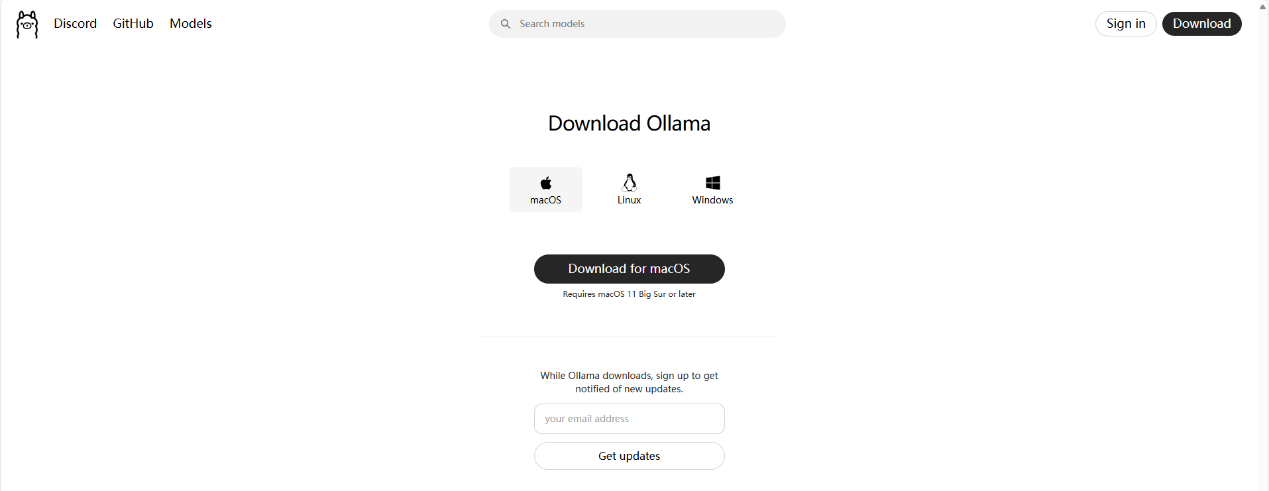

1,下载安装Ollama;

访问Ollama的官方网址:(https://ollama.com/)。下载最新的macOS版本文件。

打开下载的文件双击ollama图标安装程序进行默认安装即可。

2,下载安装Chatbox;

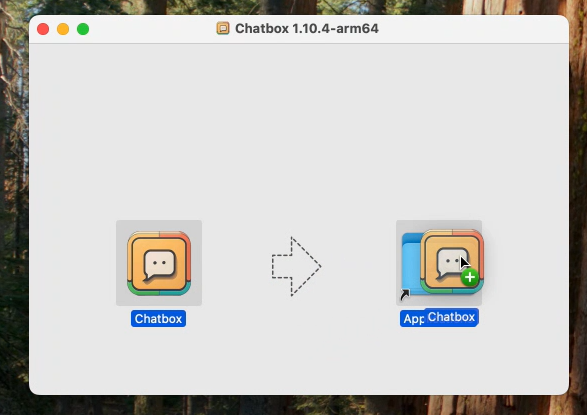

访问Chatbox的官方网站(https://chatboxai.app/zh#download)下载最新的macOS版本(.dmg文件)。

双击下载的.dmg文件,将Chatbox应用程序拖到“应用程序”文件夹中。打开“应用程序”文件夹,双击Chatbox图标启动应用程序。

三,使用Ollama运行模型

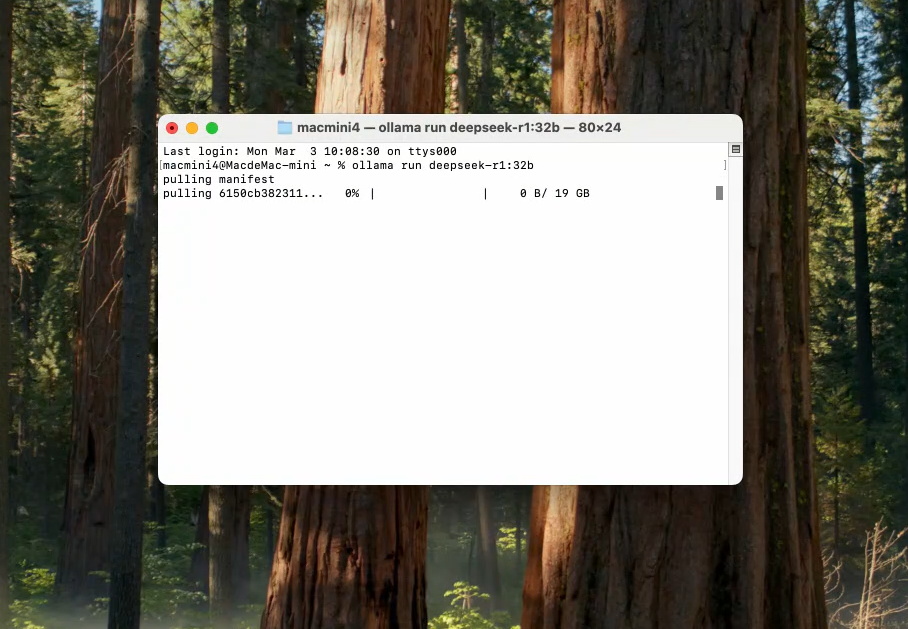

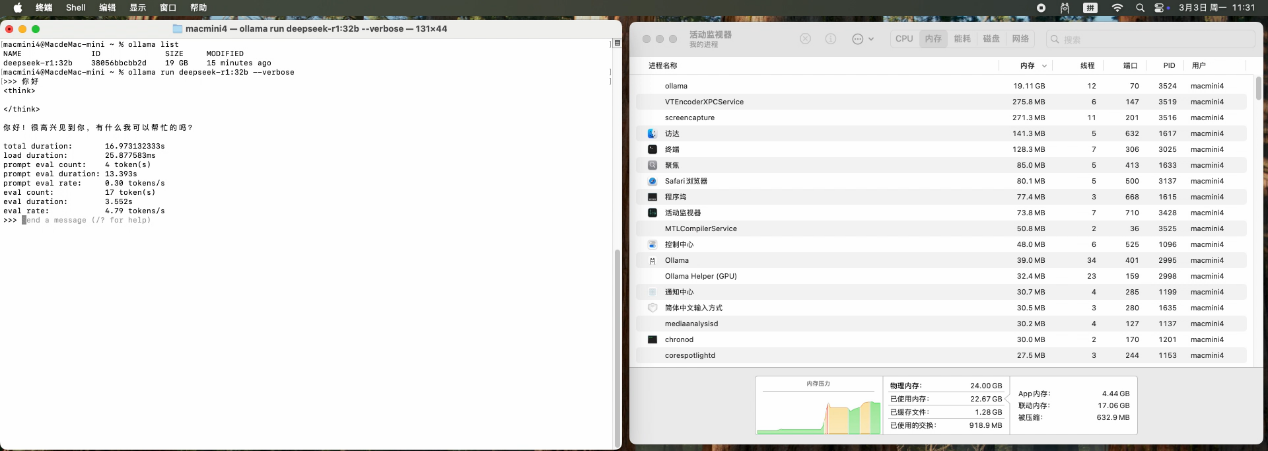

1,打开终端,运行以下命令启动Deepseek-r1:32b模型:ollama run deepseek-r1:32b(若未下载则会自动进行下载)。

2,输入您的问题或文本,模型将生成响应。32B模型下运行得出平均输出为:4.79token/s。

四,使用Chatbox与模型交互

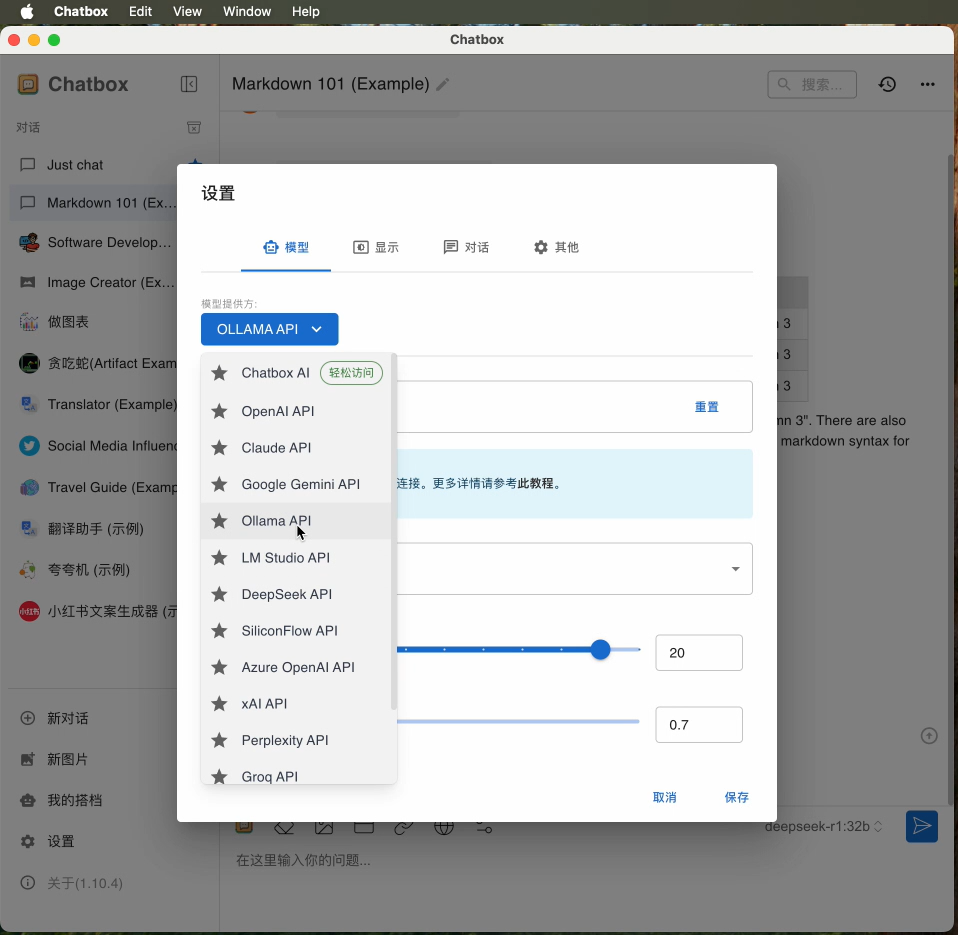

1,打开Chatbox应用程序,在设置中,选择“Ollama”作为后端服务,并输入Ollama的API地址(默认是`http://localhost:11434`)。

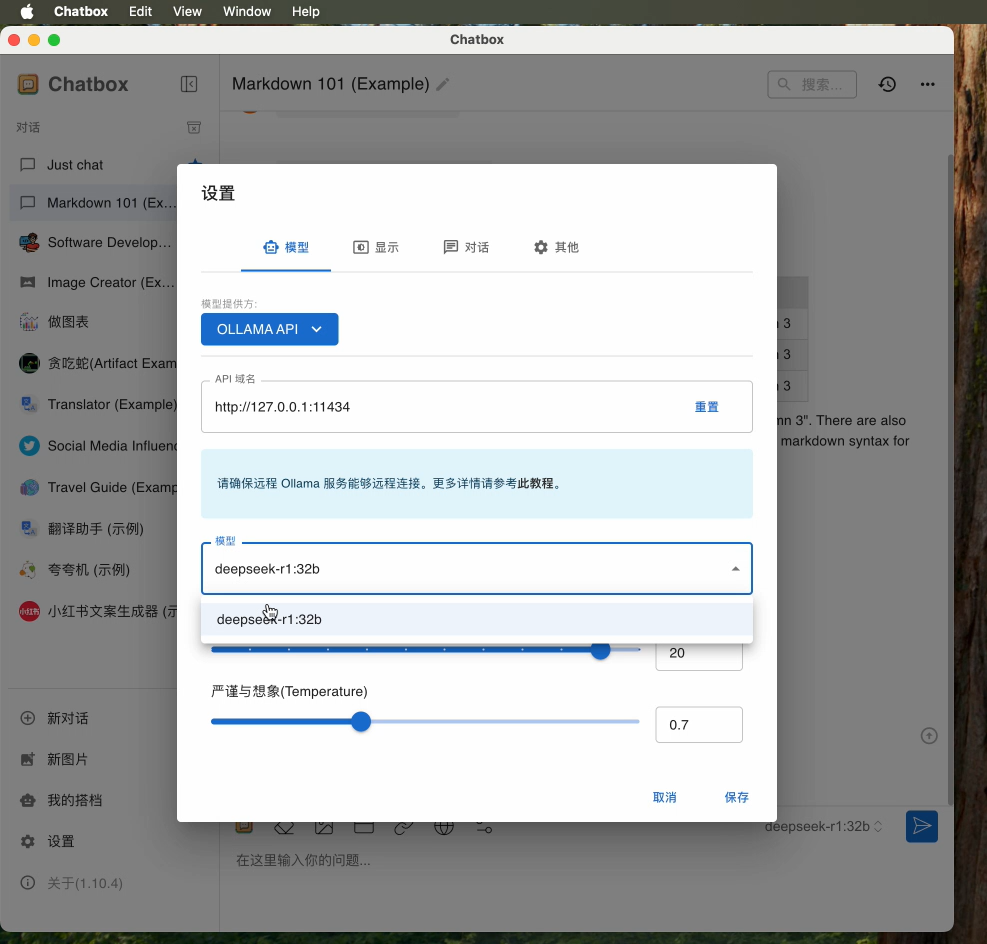

2,选择“Deepseek-r1:32b”模型。

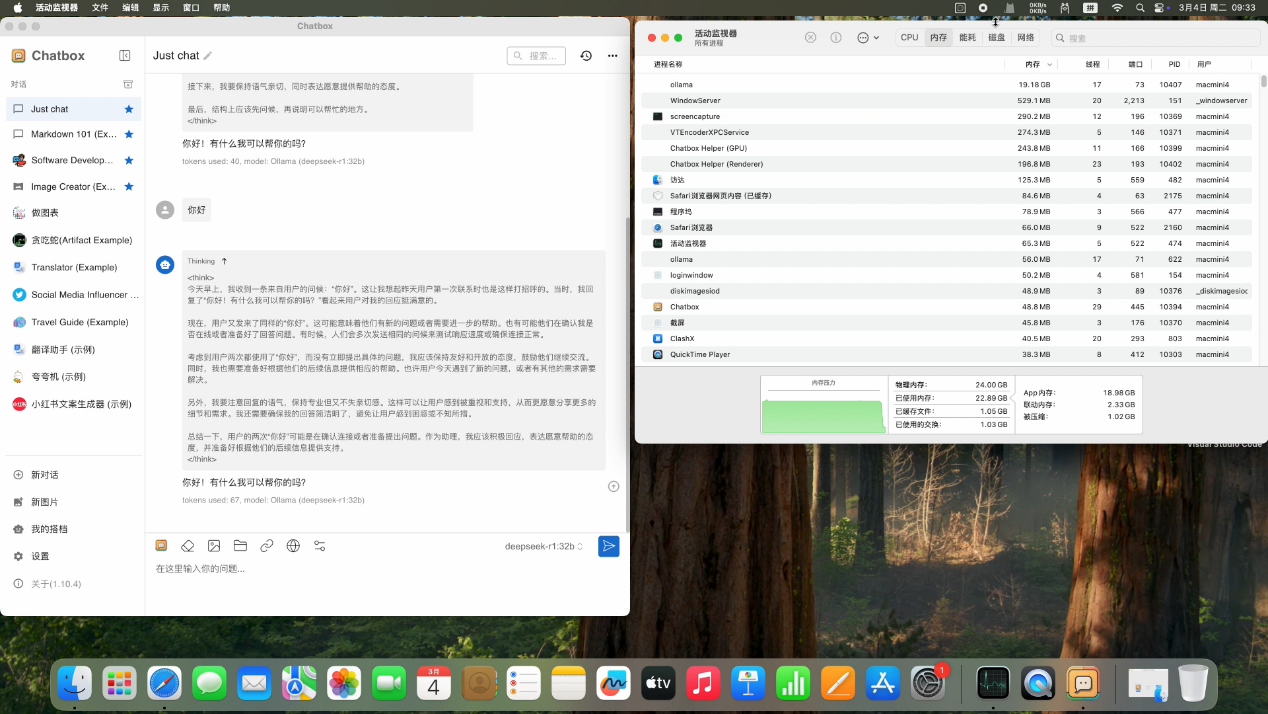

3,在聊天界面中输入您的问题或文本,Chatbox将显示模型的响应。

五,总结

通过本文的指导,您已经成功在MAC mini4上安装了Ollama和Chatbox,并部署了Deepseek-r1:32b模型。现在,您可以使用这些工具进行自然语言处理任务,享受高性能的语言模型带来的便利。

如果你有更好的文章,欢迎投稿!

稿件接收邮箱:nami.liu@pasuntech.com

更多精彩内容请关注“算力魔方?”!

审核编辑 黄宇

-

DeepSeek

+关注

关注

2文章

804浏览量

1825

发布评论请先 登录

【VisionFive 2单板计算机试用体验】3、开源大语言模型部署

【幸狐Omni3576边缘计算套件试用体验】CPU部署DeekSeek-R1模型(1B和7B)

如何在Ollama中使用OpenVINO后端

如何在RakSmart服务器上用Linux系统部署DeepSeek

在 MAC mini4 上安装与使用 ComfyUI 文生图软件完整指南

在 MAC mini4 上使用 VSCode 和 Cline 插件对接 Deepseek-R1:32b 的完整指南

DeepSeek与Chatbox:开启本地AI交互新时代!

米尔RK3576开发板评测】+ RKLLM-Toolkit 环境安装

添越智创基于 RK3588 开发板部署测试 DeepSeek 模型全攻略

在龙芯3a6000上部署DeepSeek 和 Gemma2大模型

OpenAI:GPT-4o及4o-mini模型性能下降,正展开调查

用Ollama轻松搞定Llama 3.2 Vision模型本地部署

在MAC mini4上安装Ollama、Chatbox及模型交互指南

在MAC mini4上安装Ollama、Chatbox及模型交互指南

评论