01性能炸裂

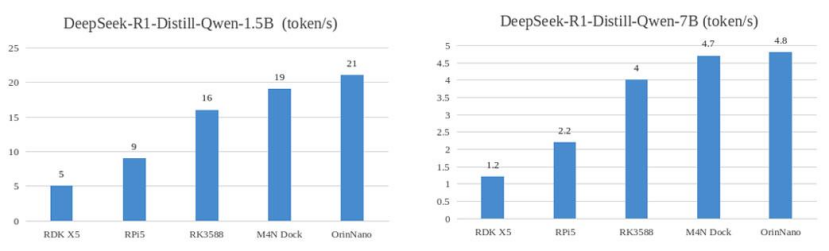

速度领先RK358815%,性能直逼OrinNano!

久等了!矽速 M4N Dock(爱芯派Pro,AX650N) 已支持部署 DeepSeek R1 大模型,实测运行速度超越 RK3588 达15% ,距离 40TOPS 算力的 Nvidia Orin Nano 8G版仅差10% !

图1:DeepSeek-R1 Distill Qwen 运行速度对比

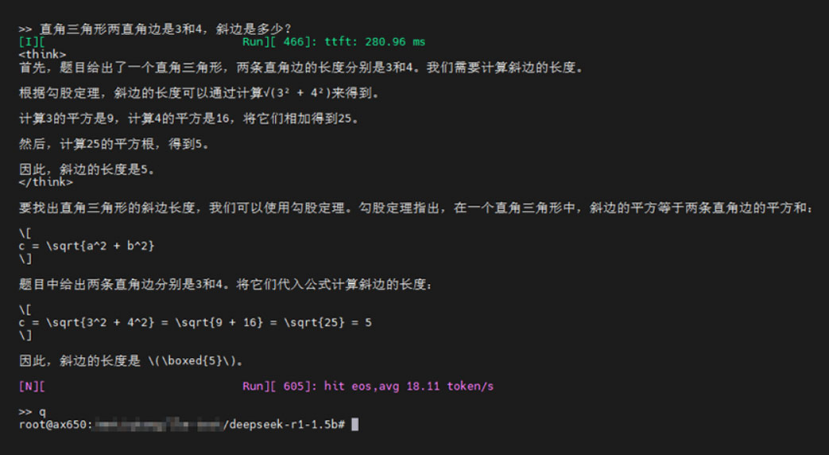

图2:运行实测图

02开发者福利

开源模型+一键部署!

为助力开发者快速上手,现已开源 DeepSeek-R1-Distill-Qwen-1.5B 轻量化模型,支持 GPTQ-Int4 高效推理!

模型下载:Huggingface仓库直达 镜像支持:基于Ubuntu系统的最新镜像 AX650_pipro_box_ubuntu_rootfs_desktop_V1.45.0内置预装环境,用户root,密码1234566,

03

即刻入手

M4N Dock,体验极致性能!

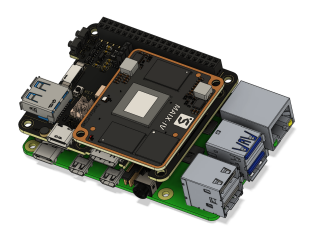

图3:M4N Dock产品图

超高性价比,AI推理性能比肩旗舰支持多模态大模型部署即插即用,开发板+算法一站式体验立即购买:Sipeed官方店

04

新品剧透

百元级LLM硬件即将登场!

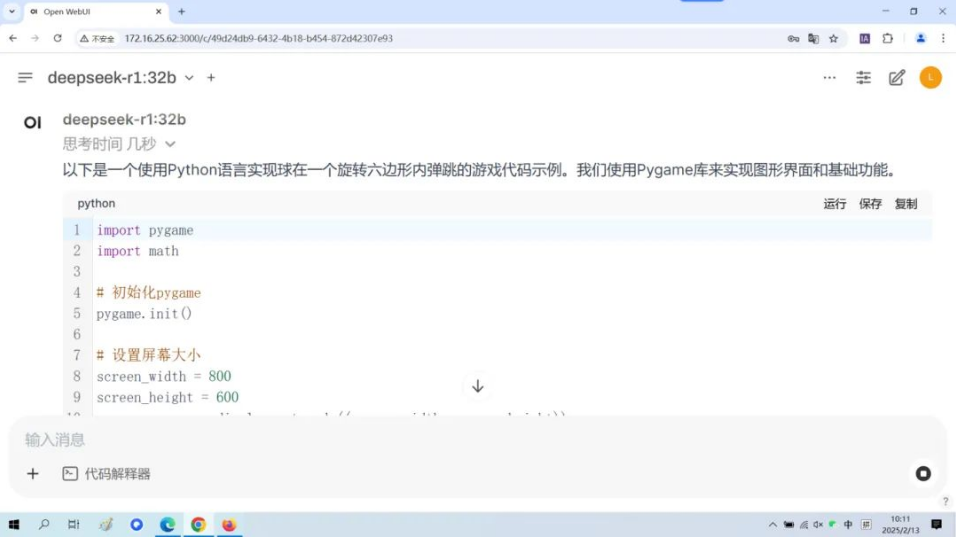

2025年矽速科技将推出 MaixHAT —— 百元级端侧大模型硬件平台!

图4:MaixHAT产品预览图

核心优势

支持串口LLM推理,可独立运行或作为开发模块

高性价比,加速AIoT产品落地

发布日期:未来2个月内,敬请期待!

-

RK3588

+关注

关注

7文章

428浏览量

6010 -

大模型

+关注

关注

2文章

3191浏览量

4147 -

DeepSeek

+关注

关注

2文章

804浏览量

1836

发布评论请先 登录

速看!EASY-EAI教你离线部署Deepseek R1大模型

DeepSeek R1模型本地部署与产品接入实操

【幸狐Omni3576边缘计算套件试用体验】DeepSeek 部署及测试

RK3588开发板上部署DeepSeek-R1大模型的完整指南

研华发布昇腾AI Box及Deepseek R1模型部署流程

研华边缘AI Box MIC-ATL3S部署Deepseek R1模型

了解DeepSeek-V3 和 DeepSeek-R1两个大模型的不同定位和应用选择

Deepseek R1大模型离线部署教程

部署DeepSeek R1于AX650N与AX630C平台

扣子平台支持DeepSeek R1与V3模型

deepin UOS AI接入DeepSeek-R1模型

云天励飞上线DeepSeek R1系列模型

重磅发布 | 矽速 M4N Dock 支持 DeepSeek R1,端侧大模型部署新标杆!

重磅发布 | 矽速 M4N Dock 支持 DeepSeek R1,端侧大模型部署新标杆!

评论