电子发烧友网报道(文/黄晶晶)DeepSeek-R1是幻方量化旗下深度求索(DeepSeek)公司研发的推理模型。DeepSeek-R1于2025年1月20日正式发布。该模型采用强化学习进行后训练,旨在提升推理能力,尤其擅长数学、代码和自然语言推理等复杂任务。

DeepSeek-R1在发布后迅速引发了广泛关注,以高性能与低训练成本令外界震惊。DeepSeek表示, DeepSeek-R1在数学、代码、自然语言推理等任务上,性能比肩 OpenAI o1 正式版。

去年12月底发布的DeepSeek-V3模型,整个训练使用2048块英伟达H800 GPU仅花费约557.6万美元,不到其他顶尖模型训练成本的十分之一。H800是英伟达特供中国显卡,相较于它的旗舰芯片H100降低了部分性能。OpenAI的GPT-4o模型训练采用的是上万个H100 GPU。DeepSeek-V3性能与GPT-4o相近。而DeepSeek-R1与OpenAI的o1相比,其成本仅为3%-5%。

这意味着,高性能AI模型的开发不必依赖于昂贵的算力和海量的数据,却能达到国外顶级AI大模型的效果。DeepSeek让大模型推理应用更加平民化、普及化,于存储行业而言,它既能降低存储成本,又能激发更多存储技术的创新,拓展存储应用,真正利好存储行业的发展。

降低存储成本

DeepSeek通过算法优化和模型压缩等技术大幅降低了AI模型的训练成本。也令一些企业看到软件和硬件的结合,比单纯地堆硬件能获得更佳的效果。DeepSeek不仅降低了对高端GPU的需求,对于高性能计算的关键存储高带宽内存(HBM)的需求也可能放缓。这使得一些企业对AI服务器的投入或将不再着眼于更高规格的配置,从而降低了其购置成本。

不过,DeepSeek本身在大模型训练和推理时,仍然离不开高性能存储。从长期来看,AI应用对数据存储容量和速率都有着更高要求。

DeepSeek大模型训练需要处理海量的数据,像DeepSeek-V3训练使用了大规模的语料库,总参数达6710亿,这些数据的存储、读取和传输都需要大量高性能存储芯片来支持。在推理阶段,DeepSeek-R1应用于智能客服、图像识别、自然语言处理等众多场景时,会产生大量的中间数据和结果数据,需要存储芯片进行临时或长期存储。随着AI应用场景的广泛落地,存储芯片的总需求有望增加。

促进存储创新

DeepSeek的技术发展可能会促使存储芯片制造商探索新的存储架构和解决方案,以更好地满足AI应用的需求。例如,随着AI模型的本地部署量增加,对低功耗、高能效的存储芯片如LPDDR以及高速内存的需求可能会增长。

近期DeepSeek运行在AMD EPYC CPU上,无需显卡支持,而搭配高频内存多通道内存能够有效提升运行速度,token/秒值得到明显提升,且功耗低、成本更低。

DeepSeek的算法可适配存内计算架构,减少数据搬运能耗。例如,优化神经网络模型以匹配ReRAM(阻变存储器)的模拟计算特性。还可与存储厂商合作优化AI加速器与存储的接口协议(如CXL),降低系统级延迟。

计算和存储能力的提升是AI技术持续进步和广泛应用的硬件基础。AI训练和推理过程中,需要频繁地读取和处理海量数据,高性能计算芯片要充分发挥其性能优势,需要高性能的内存系统与之匹配。因此,HBM仍然是满足高强度数据处理所不可或缺的内存。SK海力士、三星电子、美光三大家的HBM内存竞赛也来到了HBM4阶段,随着技术研发的深入将不断推出高带宽HBM内存进阶。

除HBM之外,AI服务器对于传统高性能DIMM内存的容量与读取性能要求也明显提升,与此相应的,DDR5在RDIMM产品的渗透率大幅增长。同时,AI服务器进行大模型训练时产生的数据相较传统服务器的中间数据极具保存价值,因此保存次数大幅度增加。在此情形下eSSD的高速度、低能耗优势决定其可以大面积取代HDD,全球各大云服务提供商均开始大规模采购eSSD。江波龙表示eSSD与RDIMM产品已在互联网、运营商等领域的多个知名客户处完成了产品验证和批量出货,未来公司将通过与大客户的深度长期合作,实现企业级业务的持续高速增长。

AI推理广泛落地,存储需求增长

根据 IDC 数据,随着人工智能进入大规模落地应用的关键时期,云端推理占算力的比例将逐步提升,“预计到 2026 年,推理占到 62.2%,训练占 37.8%。”这一预测进一步强调了 AI 推理在未来市场竞争中的核心地位。

根据机构测算,到2028年人工智能的推理负载占比有望达到85%,考虑到云端和边缘侧巨大的推理需求,未来推理芯片的预期市场规模将是训练芯片的4~6倍。

在边缘计算场景下,DeepSeek-R1推理大模型应用于AIoT设备,必将对低功耗、高耐久存储提出需求,推动NOR Flash、MRAM等细分市场增长。

兆易创新谈到NOR Flash在 AI终端的应用。AIPC方面,随着BIOS程序量代码量的不断增长,对NORFlash提出了更大容量的需求,即便PC总量维持不变,程序量的增长也会带动NORFlash 容量的提升。

AI眼镜是新的品类,期待AI眼镜能够发展成与TWS可比的品类,新需求对于NORFlash将会形成较明显的拉动作用。耳机方面,目前除了行业头部品牌对于NORFlash的容量需求比较大,大部分中低端的TWS耳机,由于功能相对简单,所以对NORFlash的容量要求很小。未来如果AI耳机能够升级,对NORFlash容量的拉动就会比较明显。如果未来消费者要求耳机必须加入AI功能,那么随着AI耳机渗透率的提升,对NOR Flash 容量的需求也会增长,即便耳机总的销售台数不增加,只要单机容量提升,对市场规模也是有拉动效果的。

写在最后

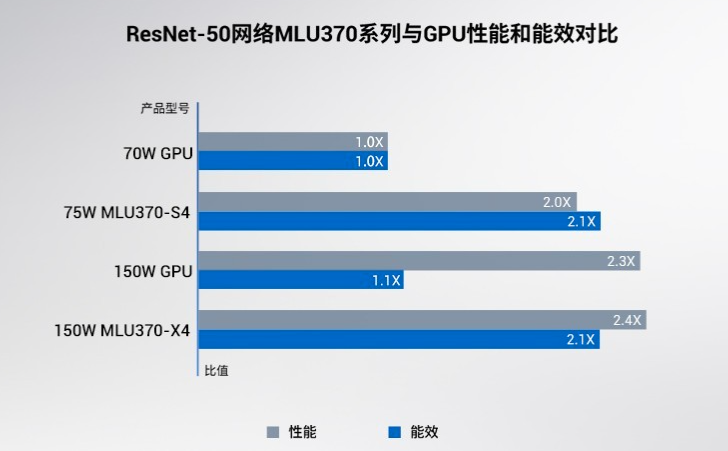

DeepSeek的算法革新降低了对最尖端算力的依赖,最近一大批国内CPU、GPU、AI芯片厂商踊跃适配DeepSeek,将有利于国产芯片在AI推理市场的竞争力提升。DeepSeek推理模型在边缘计算设备和企业本土化的部署,也将刺激更多推理芯片需求。存储芯片作为AI存力的组成部分,最先受益的莫过于HBM,如今DeepSeek带来的AI推理应用大爆发,将带动主流存储芯片品类真正的市场机会。

-

存储

+关注

关注

13文章

4542浏览量

87595 -

DeepSeek

+关注

关注

2文章

804浏览量

1836

发布评论请先 登录

寒武纪“炸裂”财报!一季度营收增长40倍,积极备货应对“爆单”?

寒武纪3000亿市值与GPU厂商密集IPO,AI芯片正是当打之年

寒武纪联手阶跃星辰成立模芯生态创新联盟

寒武纪一季度营收大涨4230% 净利润3.55亿 扭亏为盈

Deepseek横空出世!中美AI之间的差距逆转了吗?

DeepSeek大模型如何推动“AI+物流”融合创新

研华边缘AI平台测试DeepSeek蒸馏版模型的最新数据

华为推出昇腾DeepSeek大模型一体机

【实测】用全志A733平板搭建一个端侧Deepseek算力平台

如何在MATLAB中使用DeepSeek模型

DeepSeek横空出世,存储产业的寒武纪大爆发来了

DeepSeek横空出世,存储产业的寒武纪大爆发来了

评论