在机器学习领域,集成学习算法因其出色的性能和泛化能力而受到广泛关注。其中,XGBoost和LightGBM是两种非常流行的梯度提升框架。

1. 算法基础

XGBoost(eXtreme Gradient Boosting) 是一种基于梯度提升决策树(GBDT)的优化分布式梯度提升库,由陈天奇等人于2014年提出。它通过优化目标函数的负梯度来构建树模型,并支持并行和GPU加速。

LightGBM 是微软基于梯度提升框架的实现,由Ke等人于2017年提出。它采用了基于梯度的单边采样(GOSS)和互斥特征捆绑(EFB)等技术,以提高训练速度和减少内存消耗。

2. 性能对比

速度和内存消耗

- LightGBM 在速度和内存消耗方面具有明显优势。它通过GOSS和EFB技术,减少了数据传输和计算量,使得在处理大规模数据集时更加高效。

- XGBoost 虽然也支持并行和GPU加速,但在处理大规模数据集时,其内存消耗和训练速度通常不如LightGBM。

模型泛化能力

- XGBoost 在模型泛化能力上通常表现更好。它通过正则化项(L1和L2)来控制模型复杂度,从而减少过拟合的风险。

- LightGBM 虽然也支持正则化,但其在某些复杂数据集上可能不如XGBoost稳健。

支持的数据类型

- XGBoost 支持更广泛的数据类型,包括稀疏数据和分类特征。

- LightGBM 虽然也支持稀疏数据,但在处理分类特征时可能需要额外的处理。

3. 适用场景

XGBoost 适用于需要高泛化能力和对模型复杂度有严格控制的场景,尤其是在数据集不是特别大的情况下。

LightGBM 则更适合处理大规模数据集,尤其是在需要快速训练和预测的场景中。

4. 易用性和可扩展性

XGBoost 提供了丰富的参数和接口,使得用户可以灵活地调整模型以适应不同的任务。同时,其开源社区活跃,支持多种编程语言。

LightGBM 虽然参数相对较少,但其接口简洁明了,易于上手。此外,LightGBM也在不断扩展其功能,如支持多分类和多输出任务。

5. 实际应用案例

在Kaggle等数据科学竞赛中,XGBoost和LightGBM都是获胜者常用的算法。例如,在2017年的Kaggle房屋价格预测竞赛中,获胜队伍就使用了XGBoost。而在2018年的Tencent广告点击率预测竞赛中,LightGBM因其出色的速度和内存效率而受到青睐。

6. 结论

XGBoost和LightGBM各有优势,选择哪种算法取决于具体的应用场景和需求。对于需要高泛化能力和模型复杂度控制的任务,XGBoost可能是更好的选择。而对于需要快速训练和处理大规模数据集的场景,LightGBM可能更加合适。

-

gpu

+关注

关注

28文章

4968浏览量

131675 -

模型

+关注

关注

1文章

3531浏览量

50578 -

XGBoost

+关注

关注

0文章

16浏览量

2393

发布评论请先 登录

对比 BNC,MCX接头的连接优势真的明显吗?

住宅IP动态化技术应用解析:对比数据中心IP的三大核心优势

WD5030高效同步降压转换器:性能对比、优势解析及应用领域详解

云服务器对比空间有什么优势和劣势?

三相负载箱与单相负载箱的区别与优势对比

xgboost超参数调优技巧 xgboost在图像分类中的应用

常见xgboost错误及解决方案

使用Python实现xgboost教程

xgboost的并行计算原理

xgboost在图像分类中的应用

激光焊接对比传统焊接的优势和前景

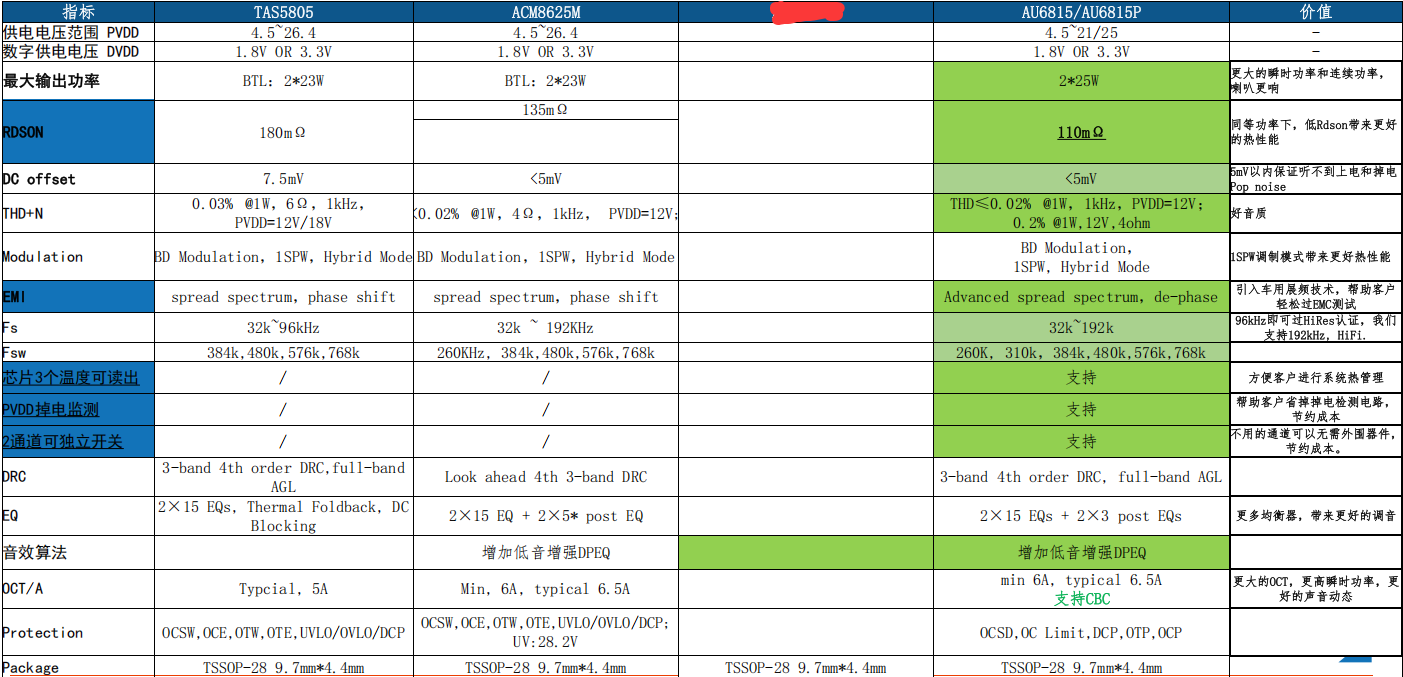

xgboost与LightGBM的优势对比

xgboost与LightGBM的优势对比

评论