简介 /

几十年来,人工智能 (AI) 的威胁一直是科幻小说不变的主题。荧幕反派角色,比如 HAL 9000、终结者、复制人和《黑客帝国》中的机器人,都站在了人类的对立面,迫使人类必须克服这些技术带来的威胁。最近,DALLE-2 和 ChatGPT 的发布引起了广大公众对 AI可以做什么的极大兴趣,也引发了人们关于 AI 将如何改变教育和工作性质的讨论。AI 也是当前和未来数据中心增长的主要驱动力。

AI 包含以下三个方面: 在训练期间,大量数据被输入算法,算法使用数据并从数据中“学习”。 然后,算法接触新数据集,并将负责基于在训练期间学习的内容生成新知识或结论。例如,这是一张猫的照片吗?此过程称作“推理 AI”。 第三个方面是“生成式 AI”,这可能比较有意思。生成式 AI 是指算法根据简单的提示“创建”原始输出,包括文本、图像、视频、代码等。

AI 计算由图形处理单元 (GPU) 进行处理,GPU 是专为并行处理而设计的芯片,非常适合 AI。用于训练和运行 AI 的模型会占用大量处理能力,这通常是单台机器无法承受的。

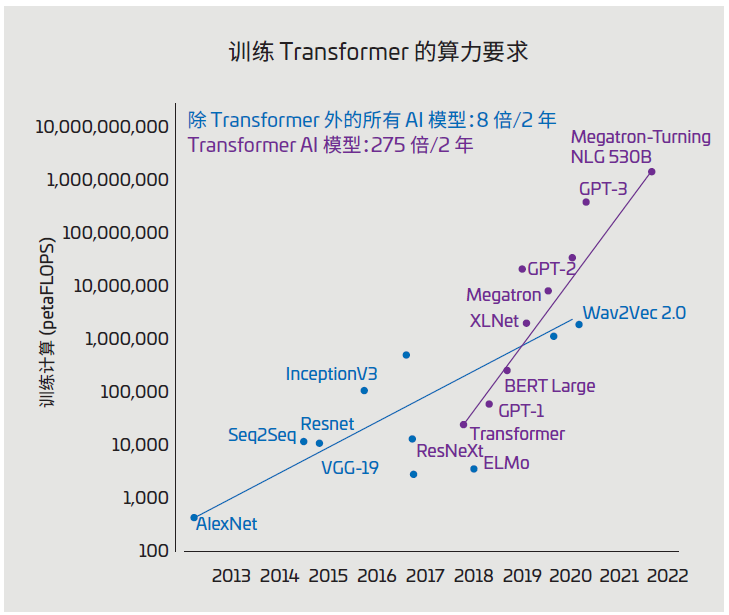

图 1:AI 模型大小(单位:petaFLOPS)

(资料来源:https://blogs.nvidia.com/blog/2022/03/25/what-is-a-transformer-model/)

图 1 显示了 A I 模型的历史增长情况, 单位为petaFLOPS(每秒千万亿次浮点运算)。处理这些大型模型需使用多个服务器和机架上的众多互联GPU。AI 数据中心部署了几十个这样的 AI 集群,而将所有内容连接在一起以保持数据流动的布线基础设施正面临着一系列棘手挑战。

以下内容概述了 AI 数据中心布线的一些关键挑战和机遇,以及一些最佳实践和成功技巧。

典型数据中心架构 /

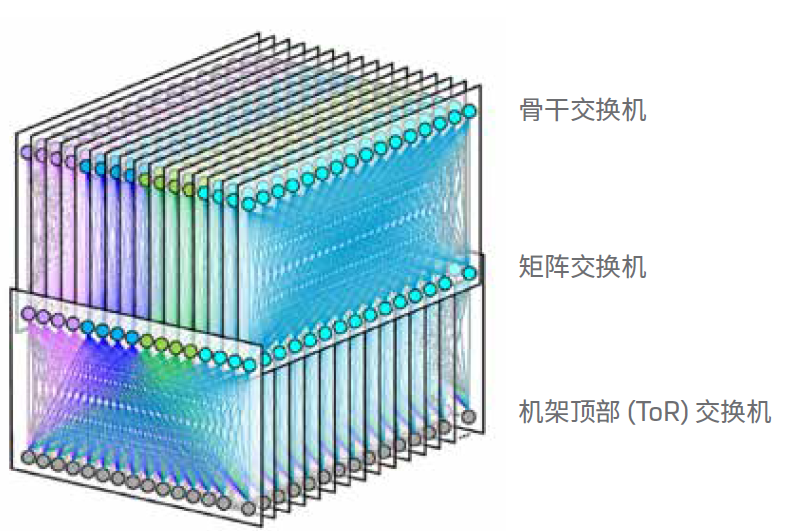

几乎所有现代数据中心,尤其是超大规模数据中心,使用的都是折叠式 Clos 架构,也称为“分支和骨干”架构。数据中心的所有分支交换机都连接到所有骨干交换机。在数据中心中,服务器机架连接到机架顶部 (ToR) 交换机。然后,ToR 连接到行末端的分支交换机或通过光缆连接到另一个房间。机架中的服务器通过一至两米的短铜缆连接到 ToR,传输 25G 或 50G信号。

这种配置可让数据中心使用很少的光缆。例如,使用 F16 架构的 Meta 数据中心(参见图 2),一行中每台服务器机架有 16根双工光缆。这些线缆从 ToR 延伸到行的末端,在那里它们与模块连接,将双工光纤组合成 24 根光缆。接着,这 24 根光缆延伸到另一个房间,与分支交换机连接。

数据中心在实施 AI 时,会将 AI 集群部署在采用传统架构的计算集群旁。传统计算有时称为“前端网络”,AI 集群有时称为“后端网络”。

图 2:FaceBook F16 数据中心网络拓扑结构

(资料来源:https://engineering..com/2019/03/14/data-center-engineering/f16-minipack/)

带有 AI 集群的数据中心 /

如上所述,AI 集群具有特有的数据处理要求,因此需要新的数据中心架构。GPU 服务器需要更多的服务器间连接,但是由于电力和散热的限制,每个机架不得不减少服务器的数量。因此,与传统数据中心相比,AI 数据中心中的机架间布线更多。每台 GPU 服务器都连接到行内或房间内的交换机。这些链路需要在长距离内达到 100G 到 400G 的速率,而这是铜缆所无法支持的。此外,每台服务器都需要连接到交换机网络、存储和带外管理。

例如:NVIDIA

举个例子,可以看看 AI 领域知名企业 NVIDIA 提出的架构。NVIDIA 发布了新款 GPU 服务器 DGX H100,该服务器具有 4 个 800G 交换机端口(作为 8 个 400GE 运行)、4 个 400GE 存储端口以及 1GE 和 10GE 管理端口。一个 DGXSuperPOD(图 3)可以包含 32 个这样的 GPU 服务器,这些GPU 服务器可连接到单行中的 18 台交换机。然后,每行将拥有 384 个 400GE 光纤链路用于交换机网络和存储,还有 64个铜缆链路用于管理。数据中心中光纤链路的数量将显著增加。前面提到的 F16 架构将在服务器机架数量保持不变的情况下拥有 128 (8x16) 根双工光缆。

AI 集群的链路有多长?/

在 NVIDIA 描绘的理想场景中,AI 集群中的所有 GPU 服务器将紧密结合在一起。与高性能计算 (HPC) 一样,AI/机器学习算法对延迟极为敏感。有人估计,运行大型训练模型有 30%的时间花在网络延迟上,70% 的时间花在计算上。由于训练一个大模型的成本可能高达 1000 万美元,因此这种网络延迟时间代表着一笔巨大的费用。即使是节省 50 纳秒或 10 米光纤的延迟,效果也非常明显。AI 集群中几乎所有的链路都限制在 100 米范围内。

不幸的是,并非所有数据中心都能够在同一行部署 GPU 服务器机架。这些机架需要大约 40 kW 才能为 GPU 服务器供电。这一功率比典型服务器机架的更高,按较低功率要求构建的数据中心将需要腾出专门的 GPU 机架空间。

如何选择收发器?/

运营商应仔细考虑其 AI 集群使用哪些光收发器和光缆才能更大限度地降低成本和功耗。如上所述,AI 集群中的最长链路将限制为 100 米。由于距离短,光学设备成本将主要集中在收发器上。使用并行光纤的收发器将具有一个优势:它们不需要使用光复用器和分解复用器进行波分复用 (WDM)。这降低了并行光纤收发器的成本和功耗。收发器节省下的费用远远抵消了多芯光纤取代双工光缆所略微增加的成本。例如,使用带有八芯光纤的 400G-DR4 收发器比采用双工光缆的 400G-FR4 收发器更具成本效益。

单模和多模光纤应用可以支持长达 100 米的链路。硅光子技术的发展降低了单模收发器的成本,使其更接近等效多模收发器的成本。我们的市场研究表明,对于高速收发器 (400G+),单模收发器的成本是等效多模收发器成本的两倍。虽然多模光纤的成本略高于单模光纤,但由于多芯光纤成本主要由 MPO 连接器决定,因此多模和单模光纤之间的成本差异较小。

此外,高速多模收发器的功耗比单模收发器少一两瓦。单个 AI集群具有 768 个收发器(128 个内存链路 + 256 个交换机链路x2),使用多模光纤将节省高达 1.5 kW 的功率。与每个 DGXH100 消耗的 10 kW 相比,这似乎微不足道,但对于 AI 集群来说,任何降低功耗的机会都非常宝贵。

在 2022 年,IEEE 短距离光纤工作小组完成了 IEEE 802.3db的工作,该规范为新的超短距离 (VR) 多模收发器确立了标准。此新标准针对的是 AI 集群等行内布线,最大覆盖范围为50 米。这些收发器有可能更大程度地降低 AI 连接的成本和功耗。

收发器与 AOC /

许多 AI、ML 和 HPC 集群使用有源光缆 (AOC) 来互联 GPU 和交换机。AOC 是两端集成了光发射器和接收器的光缆。大多数 AOC 用于短距离,通常与多模光纤和 VCSEL 搭配使用。高速 (>40G) 有源光缆将使用与连接光收发器的光缆相同的 OM3 或 OM4 光纤。AOC 中的收发器未必和设备兼容,如果不兼容将无法工作。AOC 的收发器直接接入设备即可,但是由于安装人员测试 AOC 中的收发器,因此不需要具备清洁和检查光纤连接器所需的技能。

AOC 的缺点是它们不具备收发器所拥有的灵活性。AOC 安装非常耗时,因为布线时必须连接收发器。正确安装带有扇出功能的 AOC 尤其具有挑战性。AOC 的故障率是同等收发器的两倍。当 AOC 发生故障时,必须通过网络来安装新的 AOC。这会占用计算时间。最后,当需要升级网络链路时,必须拆除有问题的 AOC 并更换为新的 AOC。相对于 AOC 连接而言,光纤布线是基础设施的一部分,并且可以在几代数据速率迭代升级中保持生命力。

结论 /

仔细考虑 AI 集群的布线将有助于节省成本、功耗和安装时间。合理的光纤布线将使企业能够充分受益于人工智能。

-

数据中心

+关注

关注

16文章

5258浏览量

73647 -

AI

+关注

关注

88文章

35515浏览量

281424 -

布线

+关注

关注

9文章

800浏览量

85232

原文标题:数据中心白皮书系列丨AI 数据中心的布线考量

文章出处:【微信号:康普中国,微信公众号:康普中国】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

PCIe协议分析仪在数据中心中有何作用?

中型数据中心中的差分晶体振荡器应用与匹配方案

华为面向亚太地区发布全新星河AI数据中心网络方案

华为面向中东中亚地区发布全新星河AI数据中心网络

是德科技推出AI数据中心构建器

适用于数据中心和AI时代的800G网络

华为全新升级星河AI数据中心网络

优化800G数据中心:高速线缆、有源光缆和光纤跳线解决方案

Cadence颠覆AI数据中心设计

数据中心发展与改造

韩国将建全球最大AI数据中心

Meta AI数据中心网络用了哪家的芯片

AI数据中心的布线考量

AI数据中心的布线考量

评论